Zuckerberg fa incetta di GPU, Altman ha paura dello shortage: il boom dell'IA incepperà la filiera dei semiconduttori?

Mentre Mark Zuckerberg ha annunciato un ingente investimento nell'acquisto di GPU NVIDIA H100 per l'intelligenza artificiale, mettendo in scacco alcuni competitor, il boss di OpenAI Sam Altman bussa alla porta dei fondi per creare una "rete di impianti per produrre chip IA".

di Manolo De Agostini pubblicata il 20 Gennaio 2024, alle 08:41 nel canale MercatoIntelligenza ArtificialeAmazonGoogleMicrosoftCDNAInstinctAMDNVIDIAHopperOpenAIMeta

La corsa sviluppo dell'intelligenza artificiale generativa metterà a dura prova, ancora di più rispetto a quanto non sia stato l'anno passato, le linee produttive di TSMC e degli altri produttori di chip per conto terzi. In poche parole, non tutte le società del settore IA riusciranno ad accedere al quantitativo di chip che desiderano, se non dopo lunghissimi tempi di attesa.

Questo stato di cose potrebbe avere un impatto anche sulla produzione di altri componenti, dalle CPU alle GPU per il gaming, perché malgrado TSMC abbia in predicato investimenti per ampliare la produzione tra 28 e 32 miliardi dollari, una larga fetta andrà a per soddisfare le necessita dei settori smartphone e HPC (High Performance Computing), che da soli hanno catalizzato l'86% - con il 43% a testa - del fatturato Q4 2023 della casa taiwanese.

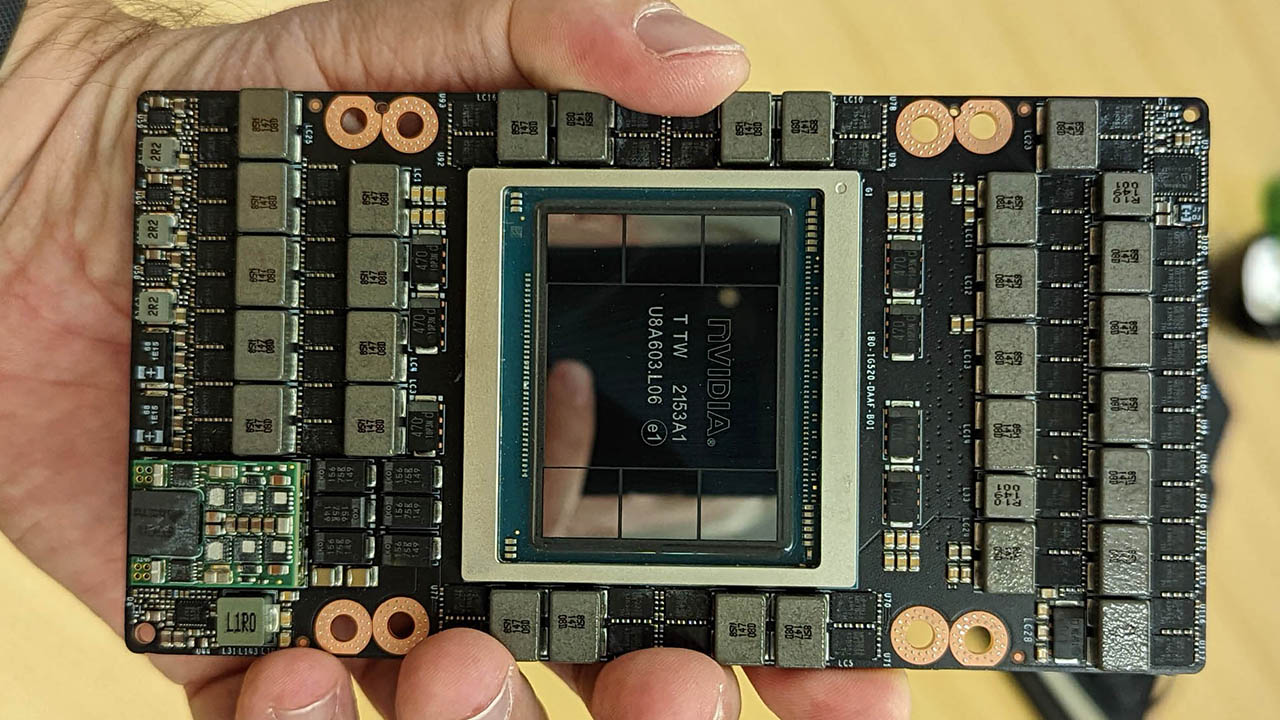

Mark Zuckerberg sarà uno dei protagonisti in questa corsa all'accaparramento di GPU. "Attualmente stiamo addestrando il nostro modello di prossima generazione Llama 3, e stiamo costruendo un'enorme infrastruttura di calcolo per supportare la nostra roadmap futura, il che include 350mila [NVIDIA] H100 entro la fine dell'anno - e in generale quasi 600 mila equivalenti ad H100 in termini di potenza di calcolo se includete anche le altre GPU", ha dichiarato nelle scorse ore, svelando l'obiettivo di arrivare a una IA generale.

Il boss di Meta è pronto ad alzare la posta: secondo le stime di Omdia, lo scorso anno Meta ha piazzato 150 mila ordini per GPU NVIDIA H100, numero pareggiato solo da Microsoft. Dietro al numero di 350mila GPU H100 ce ne sono altri che mettono in luce l'investimento di Meta: a prezzi attuali, procurarsi così tante GPU vuol dire investire oltre 10 miliardi di dollari, una cifra enorme.

Alimentare tutte quelle GPU non sarà impresa da poco, così come raffreddarle. Secondo una stima di Paul Churnock, Principal Electrical Engineer of Datacenter Technical Governance and Strategy di Microsoft, una GPU H100 con un tasso d'uso annualizzato del 61%, richiede 3740 kWh l'anno di elettricità. Moltiplicando quel dato per il numero indicato da Zuckerberg si ottiene un valore di 1300 GWh l'anno. E questo solo per quanto riguarda Meta: pensate a tutta l'energia che richiederanno Google, OpenIA, Microsoft, Amazon, Apple e il resto dei big player dell'IA. A Davos, il CEO di OpenAI Sam Altman ha citato l'energia come un tema centrale per il progresso dell'IA.

Dylan Patel, Chief Analyst di SemiAnalysis, ritiene che NVIDIA riuscirà a produrre circa 800 mila soluzioni della famiglia Hopper ogni trimestre, almeno questo è la sua stima per il Q1 e il Q2, tra tutti i vari chip che compongono la gamma (H100, H200, GH100, GH200 e H20).

Zuckerberg ha però parlato anche di altre GPU, ed è probabile che oltre all'infrastruttura esistente, Meta acquisti anche un buon numero di acceleratori AMD Instinct MI300, senza dimenticare che NVIDIA quest'anno dovrebbe presentare il successore di Hopper, Blackwell B100.

Le fabbriche Intel in Malesia: come assembly e packaging trasformano un wafer in un chip

Il punto è che produrre queste GPU non significa solo realizzare il chip: i progetti sono sempre più complessi e necessitano di avanzate soluzioni di packaging come CoWos di TSMC. E mentre le fabbriche saranno già messe alla prova per produrre chip a rotta di collo, la capacità di packaging potrebbe rappresentare un ulteriore collo di bottiglia. TSMC sta investendo in nuovi impianti per far fronte alle richieste, ma le fabbriche non si completano dall'oggi al domani e la domanda è altissima.

Chi si accaparrerà più GPU per addestrare i propri modelli IA avrà un vantaggio sulla concorrenza e questo Zuckerberg lo sa bene. Ma lo sanno anche gli altri. Non è un caso che Bloomberg riporti - proprio a poche ore dall'annuncio di Mark - l'impegno di Sam Altman di OpenAI per trovare fondi utili a creare una "rete di impianti per produrre chip IA".

Non sembra che Altman voglia entrare in competizione con TSMC, Samsung Foundry e Intel Foundry Services, semmai collaborarci per stimolare ulteriormente il settore a costruire impianti e linee produttive che sostengano la produzione di chip per l'intelligenza artificiale.

Da tempo si vocifera, tra l'altro, di un Altman convinto che OpenAI debba progettarsi in casa i chip che le servono per far avanzare ChatGPT e simili, un po' come fanno - in parte - Amazon, Google e altri: oggi OpenAI è ampiamente legata alle GPU di NVIDIA e non ha flessibilità in termini di costi e altri aspetti fondamentali della gestione delle proprie operazioni. Il progetto citato da Bloomberg potrebbe esservi in qualche modo collegato.

Il boss di OpenAI avrebbe intavolato discussioni con i fondi G42 di Abu Dhabi e SoftBank Group per trovare una soluzione a una carenza di chip destinata ad acuirsi. Il progetto richiederebbe svariate decine di miliardi di dollari: stando alla fonte, la trattativa con la sola G42 mirerebbe a rastrellare tra 8 e 10 miliardi di dollari.

La portata del progetto e l'elenco dei partner sono ancora poco chiari, ma una cosa è invece lampante: il boom dell'intelligenza artificiale metterà a dura prova la filiera produttiva dei semiconduttori, forse come mai prima d'ora, con ripercussioni per tutti i segmenti di mercato.

BOOX Note Air4 C è uno spettacolo: il tablet E Ink con Android per lettura e scrittura

BOOX Note Air4 C è uno spettacolo: il tablet E Ink con Android per lettura e scrittura Recensione Sony Xperia 1 VII: lo smartphone per gli appassionati di fotografia

Recensione Sony Xperia 1 VII: lo smartphone per gli appassionati di fotografia Attenti a Poco F7: può essere il best buy del 2025. Recensione

Attenti a Poco F7: può essere il best buy del 2025. Recensione I 3 portatili più convenienti su Amazon: sono 2 tuttofare Lenovo e un HP Victus gaming con RTX 5060

I 3 portatili più convenienti su Amazon: sono 2 tuttofare Lenovo e un HP Victus gaming con RTX 5060 AirPods Pro 2 a soli 199€: su Amazon anche AirPods 4 in sconto, ecco le differenze che contano

AirPods Pro 2 a soli 199€: su Amazon anche AirPods 4 in sconto, ecco le differenze che contano 2 Smart TV 4K Hisense con doppio sconto su Amazon: sono OLED e QLED, 55" e 75", fateci un bel pensierino

2 Smart TV 4K Hisense con doppio sconto su Amazon: sono OLED e QLED, 55" e 75", fateci un bel pensierino Portatili Apple ai minimi: MacBook Pro con chip M4 a 1.648€ e Macbook Air 13 16GB7256GB, sempre M4, a 998€

Portatili Apple ai minimi: MacBook Pro con chip M4 a 1.648€ e Macbook Air 13 16GB7256GB, sempre M4, a 998€ Come mantenere Windows 10 sicuro dopo il 2025: tutto sul programma ESU

Come mantenere Windows 10 sicuro dopo il 2025: tutto sul programma ESU Finalmente è tornato su Amazon l'iPhone 16 128GB a 749€, in tutti i colori, ma ci sono anche i 16e e 16 Pro in offerta

Finalmente è tornato su Amazon l'iPhone 16 128GB a 749€, in tutti i colori, ma ci sono anche i 16e e 16 Pro in offerta Auto nuove? Per il 65% degli italiani sono troppo care, non dovrebbero costare oltre i 20.000 euro

Auto nuove? Per il 65% degli italiani sono troppo care, non dovrebbero costare oltre i 20.000 euro Droni solari Airbus volano nella stratosfera grazie alle nuove batterie al silicio: test riusciti a oltre 20 km di quota

Droni solari Airbus volano nella stratosfera grazie alle nuove batterie al silicio: test riusciti a oltre 20 km di quota Colpo da 15 milioni di dollari: chi ha rubato un carico di prodotti AMD e Apple?

Colpo da 15 milioni di dollari: chi ha rubato un carico di prodotti AMD e Apple? Elon Musk lancia l'allarme su GPT-5: 'OpenAI divorerà Microsoft'. Ma Nadella lo sfida con un sorriso

Elon Musk lancia l'allarme su GPT-5: 'OpenAI divorerà Microsoft'. Ma Nadella lo sfida con un sorriso iPhone 17 Pro sarà più costoso, ma anche più conveniente

iPhone 17 Pro sarà più costoso, ma anche più conveniente Leapmotor spinge sull'acceleratore: nuovo C10 AWD da 585 cavalli e ricarica ultraveloce a 800V

Leapmotor spinge sull'acceleratore: nuovo C10 AWD da 585 cavalli e ricarica ultraveloce a 800V Toyota vuole battere i produttori cinesi di auto elettriche. Come? Alleandosi con i loro fornitori

Toyota vuole battere i produttori cinesi di auto elettriche. Come? Alleandosi con i loro fornitori Colpo grosso di Musk: 14 ricercatori Meta hanno scelto xAI per il futuro dell'AI

Colpo grosso di Musk: 14 ricercatori Meta hanno scelto xAI per il futuro dell'AI

24 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoFar pagare il 30% in più CPU,GPU e memorie: TAAAAC...

Far schizzare i consumi elettrici a dismisura per rendere i nuovi utenti dei bamboccioni incapaci di pensare con una mediocre imitazione dell'intelligenza umana: TAAC e TAAC...

Link ad immagine (click per visualizzarla)

Far pagare il 30% in più CPU,GPU e memorie: TAAAAC...

Far schizzare i consumi elettrici a dismisura per rendere i nuovi utenti dei bamboccioni incapaci di pensare con una mediocre imitazione dell'intelligenza umana: TAAC e TAAC...

Forse non hai letto bene la notizia: il problema è nella capacità produttiva delle fonderie... TSMC è straintasata, Samsung non ha rese paragonabili a TSMC, Intel non ha ancora processi avanzati, le altre sono fuori gioco... Meno slot disponibili per gli OEM e più salgono i prezzi...

per non parlare delle gpu datacenter e IA-oriented

ma tanto ormai a Nvidia non interessa più tanto il mondo del gaming. I soldi a palate li fanno con la IA ed è quello il loro futuro e il loro pozzo magico di investimenti.

Che mondo ci aspetta...prezzi sempre più alti su tutto...IA dappertutto (ho fatto anche la rima)...gaming ridotto ormai a remake e remaster dovunque...Denuvo dappertutto e empress che ha gettato la spugna

E' questo il mondo voluto dai nerds IT di Cupertino e company (non quello in provincia in lecce): soldi, potere, speculazione, controllo capillare delle masse, e briciole alle masse

dubito oggi il videogiocatore medio ricerchi assiduamente nuove gpu, si stanno trovando soluzioni sw per ottimizzare i giochi e molti stanno passando alle handheld (giocare quando vuoi e dove vuoi non ha prezzo).

ma potenzialmente i bagarini potrebbero lucrare su alcuni professionisti ma anche lì non so quanti effettivamente necessitino dell'ultimissima gpu

In questo caso,non servono ne rtx core ne tensor core ma riflessi pronti e tanta mano.....

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".