AMD Advancing AI: dai supercomputer ai notebook intelligenza artificiale per tutti

In occasione dell'evento Advancing AI, AMD ha delineato quanto le elaborazioni legate all'intelligenza artificiale stiano modificando il mondo dell'informatica in modo radicale. Nel prossimo futuro non solo soluzioni sempre più potenti per i datacenter, ma anche tanta potenza di elaborazione integrata all'interno dei prodotti consumer per elaborazioni che sono in locale.

di Paolo Corsini pubblicato il 06 Dicembre 2023 nel canale ProcessoriAMDZenInstinctRyzen

Nelle parole di un po' tutte le aziende impegnate nel settore della tecnologia, l'attuale fase storica con la diffusione di elaborazioni di intelligenza artificiale in modo massiccio viene identificata come una delle più importanti nella storia dei personal computer. Il suo impatto sul mercato è stimato essere di simile portata a quello che è stata la diffusione di Internet tanto negli ambiti d'impresa come per il mercato consumer. Lisa Su, CEO di AMD, ha indicato questo mercato come capace di arrivare a un controvalore stimato di 400 miliardi di dollari nel 2027, con un tasso di crescita medio annuale del 70%: è evidente come le opportunità all'orizzonte siano enormi.

In occasione del keynote tenuto al CES 2023, all'inizio del mese di gennaio, Lisa Su aveva annunciato le soluzioni della famiglia Instinct MI300 destinate ai datacenter e pensate per le nuove necessità di elaborazione nei datacenter pesantemente influenzate dall'intelligenza artificiale.

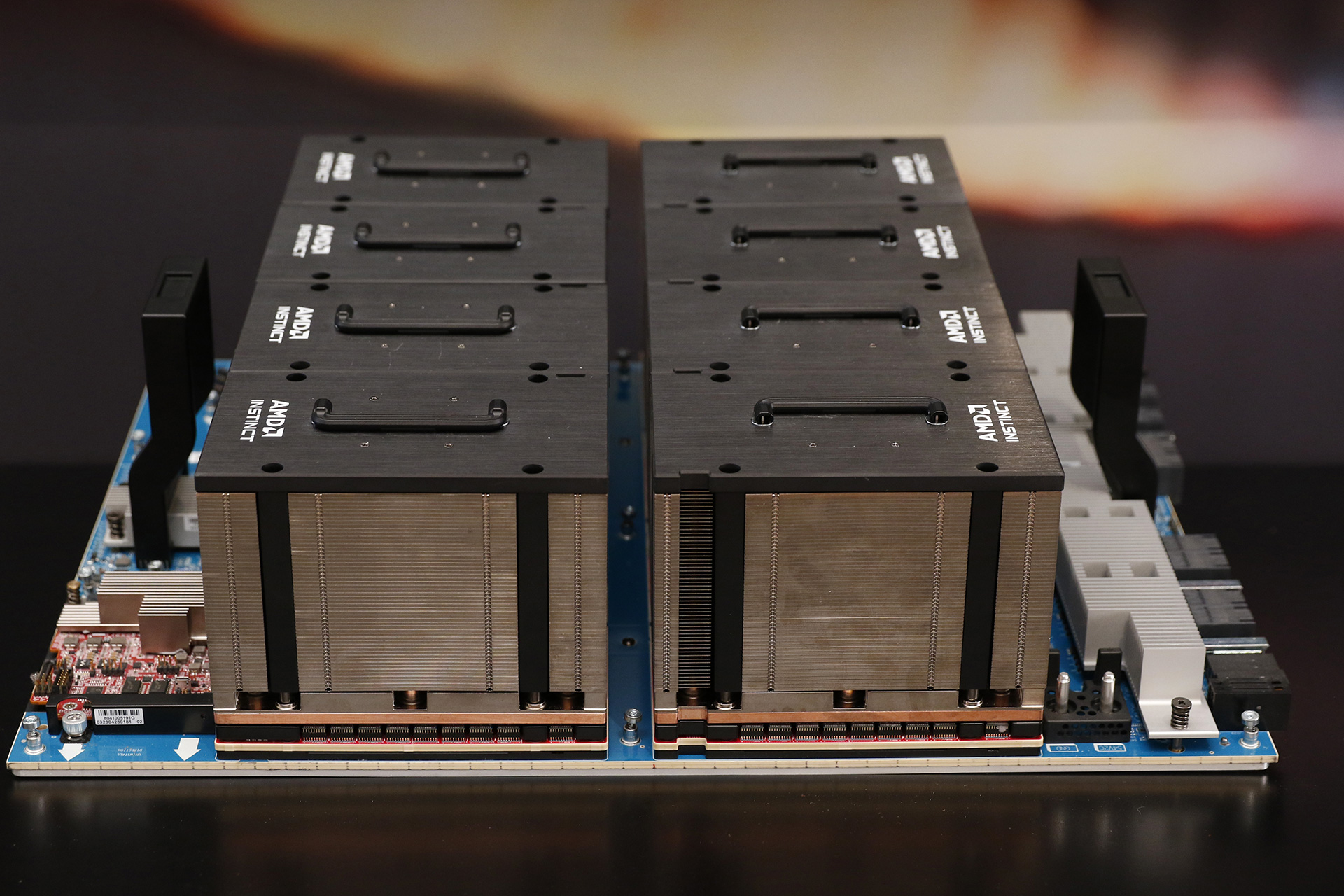

Questa famiglia prevede due distinte soluzioni, indicate con i nomi di Instinct MI300X e Instinct MI300A. La prima è una GPU particolarmente complessa basata su architettura CDNA 3, mentre la seconda è una soluzione che integra una componente CPU Zen 4 con una GPU CDNA 3 integrando memoria HBM3 condivisa e unificata tra le due distinte unità di elaborazione.

Instinct MI300X

Si tratta di una GPU basata su architettura CDNA 3 che è abbinata a 192 GB di memoria HBM3 montata sullo stesso package, in grado di offrire una bandwidth massima teorica che tocca i 5,3 TB/s con una bandwidth massima di 896 GB/s ottenuta dai link Infinite Fabric.

La struttura vede 8 XCD, Accelerator Complex Die, divisi in 4 blocchi ciascuno contenente 2 XCD e abbinati a 4 IOD, gli I/O die; in totale sono presenti 304 Compute Unit di tipo CDNA 3. Gli 8 stack di memoria HBM3 raggiungono un totale di 192 GB di capacità complessiva e sono abbinati a 256 MB di Infinity Cache, nota anche come la cache di terzo livello grafica sviluppata da AMD.

Il tutto è collegato tramite 7x16 link Infinity Fabric, ciascuno capace di una bandwidth massima teorica di 128 GB/s e che sommati assieme conducono al dato cumulato di 896 GB/s. Il package è di tipo 3.5D, ottenuto abbinando 3D Hybrid Bonded con 2.5D silicon interposer.

Nel confronto con la soluzione concorrente NVIDIA H100 SXM, AMD evidenzia un vantaggio in termini di capacità della memoria, da 80 GB a 192 GB integrati per ogni scheda, con una bandwidth che è più elevata del 60% (da 3,3 TB/s a 5,3 TB/s).

Ne derivano prestazioni massime teoriche con elaborazioni in ambiente HPC come in quelle di intelligenza artificiale che sono più elevate, con un margine di vantaggio che parte dal 30% sino al 140% a seconda del tipo di elaborazione: è bene ricordare che si tratta di picchi massimi teorici, non di prestazioni effettivamente misurate con specifiche applicazioni.

Pr quanto concerne le elaborazioni di intelligenza artificiale, AMD ha evidenziato un margine di vantaggio compreso tra il 10% e il 20% a seconda del tipo di applicazione rispetto alla scheda NVIDIA H100, usando dei grandi modelli linguistici di ampio utilizzo. Notiamo come il margine di vantaggio sia, in termini percentuali, inferiore a quanto evidenziato nel confronto precedente sui dati massimi teorici ottenibili con le due architetture ma che stando a questi casi di utilizzo pratico la proposta AMD sia allineata, quanto a potenzialità, a quella concorrente di NVIDIA.

AMD propone anche la piattaforma MI300X, ottenuta affiancando 8 di queste GPU in un classico chassis per datacenter: il confronto è in questo caso con la corrispondente piattaforma H100 HGX di NVIDIA, dalla quale la proposta AMD si distanzia per la capacità di memoria complessiva (1,5 TB contro 640 GB) e per la potenza di elaborazione cumulata superiore come massimo teorico del 30% restando di fatto perfettamente sovrapponibili gli altri aspetti delle due piattaforme.

Nel confronto tra le due piattaforme a 8 GPU di AMD e NVIDIA emerge, con due applicazioni pratiche come Bloom e Llama 2, un margine di vantaggio netto per MI300X: i valori sono superiori in termini di throughput oltre che di latenza, prendendo modelli dalle dimensioni piuttosto importanti (rispettivamente da 176 miliardi e 70 miliardi).

Instinct MI300A

AMD Instinct MI300A è la seconda proposta dell'azienda americana, che integra al proprio interno una componente GPU sempre basata su architettura CDNA 3 assieme a una CPU basata su architettura Zen 4. AMD ha preso il chip MI300X rimuovendo uno dei 4 XCD così da avere un totale di 228 Compute Unit, implementando 3 CCD (CPU Complex Die) per un totale di 24 core x86 basati, come scritto, su architettura Zen 4. Sul package sono presenti 128 GB di memoria HBM3, che è unificata tra GPU e CPU per una bandwidth massima di 5,3 TB/s. L'architettura è completata da 4 link x16 Infinity Fabric, oltre a 4 link x16 con interfaccia PCI Express 5.0.

Una proposta di questo tipo ha la peculiarità di offrire potenza di calcolo parallela tipica del mondo GPU affiancata a quella tradizionale di un'architettura CPU, il tutto con memoria condivisa e quindi senza necessità di dover copiare i dati tra le differenti memorie delle due unità di elaborazione.

Se ne ricavano vantaggi in termini di prestazioni massime teoriche in ambito HPC, con un margine che AMD quantifica nell'80% rispetto all'architettura concorrente NVIDIA H100 SXM, con gli stessi benefici visti in precedenza con MI300X in termini di quantitativo di memoria e sua bandwidth. Il confronto in termini di elaborazioni di intelligenza artificiale, fatto sui dati massimi teorici di picco che possono essere raggiunti da queste due architetture concorrenti, evidenzia valori che sono di fatto equivalenti.

È l'ambito HPC quello nel quale una soluzione come quella Instinct MI300A spicca, grazie all'unione di CPU e GPU e all'utilizzo di una memoria unificata: AMD ha fornito 3 esempi pratici di questa tipologia di scenario di elaborazione dai quali emerge un margine di vantaggio tra il 10% e il 20% della nuova architettura AMD rispetto a quella H100 di NVIDIA.

ROCm 6 al debutto

Per poter sfruttare al meglio l'hardware nelle elaborazioni legate all'intelligenza artificiale è necessario abbinare una componente software che sia all'altezza. Lo sforzo di AMD è in ROCm, che giunge in questa fine di 2023 alla nuova versione 6 dotata di differenti ottimizzazioni e in grado di assicurare un ulteriore boost prestazionale a parità di architettura hardware abbinata. ROCm è stato ora esteso anche alle schede video consumer della famiglia Radeon, così da dare maggiori opportunità di sviluppo.

Lo si vede bene da questi dati resi disponibili da AMD, nei quali emerge un miglioramento della latenza consistente in differenti scenari applicativi: andiamo dal +30% sino al +160%, secondo i dati di AMD, a testimoniare quanto il lavoro di sviluppo e perfezionamento del lato software abbia incidenza sull'ottimale sfruttamento delle architetture hardware.

L'abbinamento tra nuovo hardware e ottimizzazione software ha permesso a AMD di ottenere miglioramenti a dir poco significativi, come nel caso qui proposto: la latenza è migliorata di 8 volte passando dalla GPU Instinct MI250 di precedente generazione abbinata a ROCm 5 alla nuova Instinct MI300X con ROCm 6.

AI anche nel mondo dei client

Il tema dell'intelligenza artificiale sta interessando tutti gli ambiti nei quali le aziende impegnate nello sviluppo di soluzioni hardware si trovano ad operare. Se inizialmente le necessità di elaborazione si erano indirizzate verso grandi datacenter, siamo ora in un'epoca nella quale anche il singolo dispositivo a disposizione dell'utente finale richiede di avere capacità integrata per l'elaborazione dell'IA. AMD, al pari del resto delle altre aziende impegnate in questo settore, è ben presente con differenti tipologie di soluzioni che vanno dagli acceleratori AMD Instinct per i datacenter a quanto integrato all'interno delle CPU per i sistemi notebook più sottili e compatti.

Lo sviluppo di soluzioni hardware vede AMD impegnata su 3 distinti settori, che rappresentano le differenti tipologie di soluzioni hardware che possono essere utilizzate per accelerare l'intelligenza artificiale. Tutto questo viene raccolto dall'azienda sotto il nome di AMD Ryzen AI:

- NPU, Neural Processing Unit, basata al momento su architettura AMD XDNA;

- CPU: l'architettura Zen 4 di ultima generazione integra al proprio interno supporto alle istruzioni AVX-512 VNNI che accelerano l'esecuzione di elaborazioni di intelligenza artificiale;

- GPU: le soluzioni AMD con architettura RDNA sono ottimizzate per le elaborazioni parallele tipiche dei carichi di lavoro di intelligenza artificiale, accelerando le varie applicazioni che le supportano.

Abbiamo detto che negli ultimi tempi si è sviluppata una forte domanda di soluzioni di elaborazione per l'intelligenza artificiale che portino i calcoli sempre più nel client, allontanandoli da quelle elaborazioni tipiche all'interno dei datacenter. Secondo AMD, sono 4 le ragioni principali che hanno portato a questa nuova dinamica di mercato:

- prestazioni: non è necessario inviare informazioni e dati sulla rete verso i centri di elaborazione in cloud, evitando ripercussioni sui tempi di elaborazione;

- sicurezza: i dati restano in locale senza il rischio che vengano esposti in qualche modo nella rete, diventando accessibili a terzi;

- costi futuri: elaborando nel proprio hardware i calcoli di intelligenza artificiale si può ovviare all'utilizzo di software in licenza esterni, ricorrendo anche a soluzioni open source senza aggravi di costo;

- efficienza: la presenza di hardware dedicato, in particolare nella forma di una NPU, permette di ottenere la massima efficienza possibile nelle elaborazioni.

AMD ha scelto una strategia di mercato che punta in primo luogo ad avere in commercio il maggior numero possibile di soluzioni hardware con supporto all'accelerazione delle elaborazioni di intelligenza artificiale, così che possano venir acquistate dai propri clienti. Non solo soluzioni per i datacenter, quindi, ma un numero sempre più elevato di sistemi notebook che integrano al proprio interno i componenti richiesti per gestire le elaborazioni di intelligenza artificiale al meglio: NPU, CPU e GPU.

In questo modo gli sviluppatori software hanno una base di clienti che possa sfruttare con l'hardware a propria disposizione le funzionalità di accelerazione implementate nei propri programmi. AMD interviene inoltre nei rapporti con gli sviluppatori attraverso un coinvolgimento diretto, così che il software sia supportato e ottimizzato, oltre che facendo in modo che ogni sviluppatore abbia accesso all'hardware AMD e in questo modo possa lavorare efficacemente sulle proprie soluzioni software.

AMD suggerisce l'utilizzo di ONNX Runtime per coloro che volessero sviluppare soluzioni con accelerazione per intelligenza artificiale in ambiente Windows. Si tratta di una soluzione Open Source compatibile con tutte le differenti tipologie di hardware in commercio. Per facilitare il lavoro degli sviluppatori AMD mette a disposizione il proprio AMD Ryzen AI Software, con il quale gli sviluppatori possono impacchettare i propri applicativi e i modelli AI attraverso le ONNX Runtime.

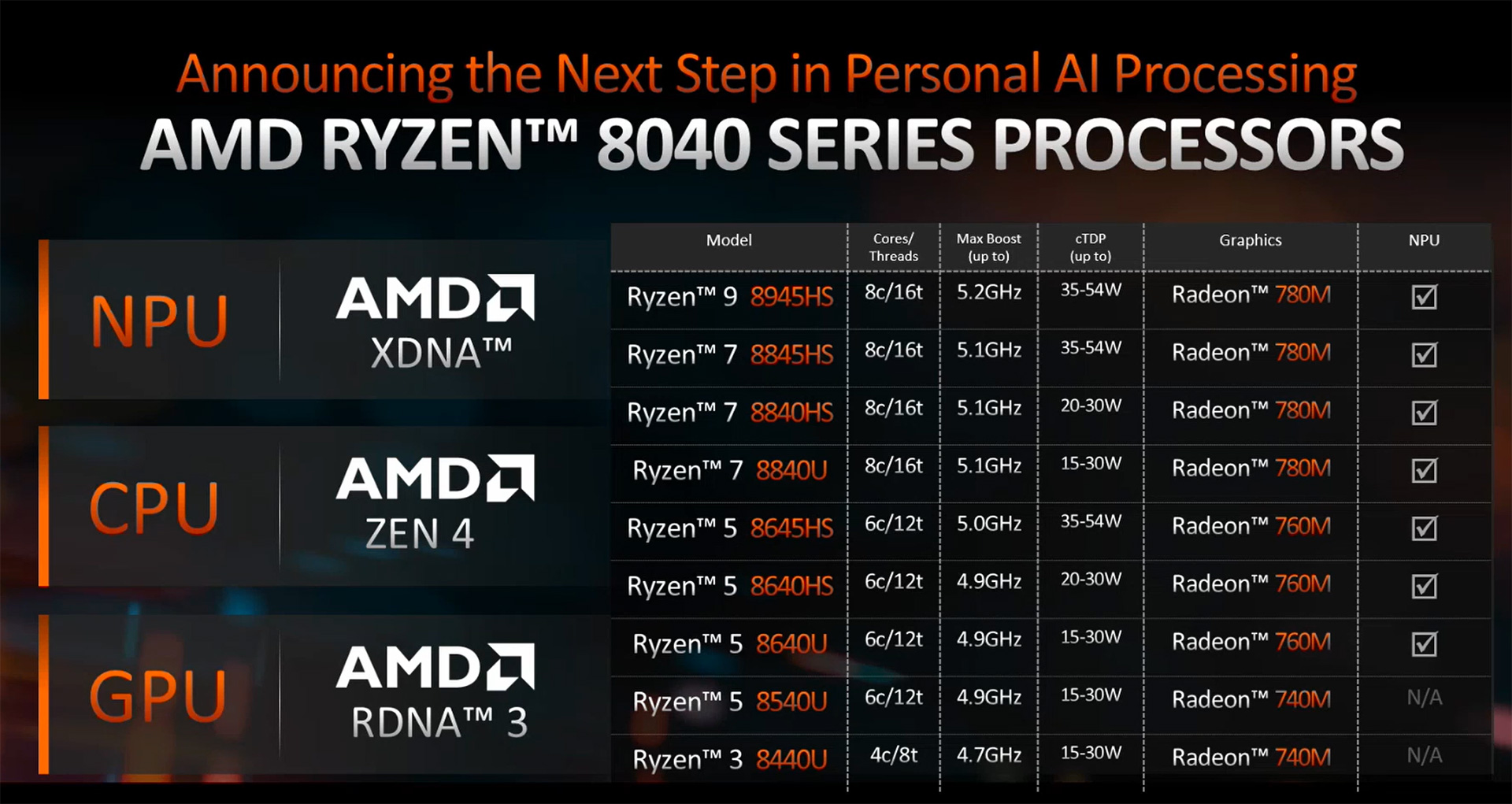

Le nuove CPU Ryzen 8040, basate su architettura Zen 4 e previste in commercio all'inizio del 2024, integrano al proprio interno tutte le componenti hardware necessarie per la migliore gestione delle elaborazioni di intelligenza artificiale: la NPU XDNA, la CPU Zen 4 e la GPU RDNA 3.

AMD dichiara importanti incrementi nelle prestazioni con elaborazioni AI da parte di questi nuovi processori rispetto a quelli della serie Ryzen 7040: parliamo di un aumento sino al 40% con Llama 2 e con Vision Models. Nel confronto con le soluzioni concorrenti Intel Core i9-13900H, il margine di vantaggio varia da un 12% medio con applicazioni multi-thread a un 77% massimo con i giochi (usando la GPU integrata) sino a un +37% di picco con applicazioni di content creation.

La nuova famiglia comprende versioni che integrano da un minimo di 4 core sino a un massimo di 8 core, con TDP che varia da un minimo di 15 Watt sino a un picco di 54 Watt nella configurazione a più elevate prestazioni delle proposte top di gamma.

Rispetto ai modelli di precedente generazione della gamma Ryzen 7040 si nota un incremento nelle frequenze di clock, dal quale derivano i risultati prestazionali evidenziati in precedenza. Tutte le CPU integrano al proprio interno la NPU, fatta eccezione per le due proposte Ryzen 3 e Ryzen 5 d'ingresso nella famiglia di nuovi prodotti.

La roadmap AMD per le soluzioni AI prevede le soluzioni 8040, che saranno messe in commercio nel corso del primo trimestre 2024, indicate con il nome in codice di Hawk Point ad andare progressivamente a prendere il posto d quelle Phoenix della gamma Ryzen 7040.

A seguire, con spedizioni nel corso del 2024 e presumibile commercializzazione a inizio 2025, avremo le nuove proposte Strix Point basate su architettura della componente NPU di tipo XDNA 2, nuova generazione specificamente sviluppata per le necessità della generative AI per la quale AMD ha già dichiarato sin d'ora un incremento di almeno 3 volte delle prestazioni con questa tipologia di elaborazioni.

L'AI è il futuro del mondo dei computer

Nel corso di tutto il 2023 il tema che ha guidato lo sviluppo nel mondo dei datacenter è stato quello delle elaborazioni di Intelligenza Artificiale, in modo particolare l'IA generativa che ha visto un'espansione senza precedenti nel corso degli ultimi 12 mesi. Tutte le aziende impegnate nel settore dei datacenter, tanto produttrici di hardware come nello sviluppo software, hanno visto il proprio impegno crescere in modo repentino nel corso dell'anno.

AMD non è ovviamente da meno ma vedremo a breve come lo stesso valga per Intel, oltre che per NVIDIA: il mercato è alla costante e continua richiesta di nuove soluzioni che siano in grado di accelerare le elaborazioni di Intelligenza Artificiale. È un mercato non solo esigente ma in grande espansione, visto le stime di un controvalore di oltre 400 miliardi di dollari USA previsto per il 2027.

Ma le elaborazioni di intelligenza artificiale non si devono limitare alle sole soluzioni destinate ai datacenter: le necessità di elaborazione si spostano anche verso i client che teniamo tra le mani ogni giorno. Da questo l'attenzione a integrare all'interno delle CPU per le prossime generazioni di notebook, e in prospettiva riteniamo anche per tutti i processori per sistemi PC attesi in commercio, potenza di calcolo dedicata per le necessità dell'IA offrendo non solo CPU e GPU sempre più potenti ed efficienti ma anche unità NPU dedicate.

Questa pervasività delle elaborazioni di intelligenza artificiale è la conferma di come questo genere di elaborazioni siano destinate a cambiare in modo radicale tutto il mercato, passando dai datacenter sino ai client a disposizione degli utenti senza tralasciare le elaborazioni nell'edge.

I produttori di soluzioni hardware sono quindi chiamati a sviluppare soluzioni che siano sempre più potenti nel gestire l'IA ma al contempo anche in grado di assicurare la massima efficienza energetica. Ma accanto a questo lavoro, che vede AMD impegnata al massimo come sono del resto anche Intel e NVIDIA, è indispensabile che l'ecosistema software continui il costante lavoro di ottimizzazione richiesto per sfruttare al meglio le novità hardware e rendere le elaborazioni di IA sempre meno influenzate dalla latenza e dalla dimensione dei modelli utilizzati.

AWS re:Invent 2025: inizia l'era dell'AI-as-a-Service con al centro gli agenti

AWS re:Invent 2025: inizia l'era dell'AI-as-a-Service con al centro gli agenti Cos'è la bolla dell'IA e perché se ne parla

Cos'è la bolla dell'IA e perché se ne parla BOOX Palma 2 Pro in prova: l'e-reader diventa a colori, e davvero tascabile

BOOX Palma 2 Pro in prova: l'e-reader diventa a colori, e davvero tascabile Bari punta sull'elettrico: arrivano 42 autobus snodati a batteria da 18 metri per le nuove linee BRT

Bari punta sull'elettrico: arrivano 42 autobus snodati a batteria da 18 metri per le nuove linee BRT Prezzi in salita di 200 dollari in 6 anni e vendite in calo: l'allarme di Circana sulle console

Prezzi in salita di 200 dollari in 6 anni e vendite in calo: l'allarme di Circana sulle console Google introduce CC: l'AI che riassume la tua giornata ogni mattina

Google introduce CC: l'AI che riassume la tua giornata ogni mattina Samsung potrebbe produrre il chipset Z990 per le future CPU Intel Nova Lake

Samsung potrebbe produrre il chipset Z990 per le future CPU Intel Nova Lake Bose Smart Ultra Soundbar è un prodotto di ottima qualità ora a un super prezzo su Amazon: Dolby Atmos top di gamma a 599€ invece di 999€

Bose Smart Ultra Soundbar è un prodotto di ottima qualità ora a un super prezzo su Amazon: Dolby Atmos top di gamma a 599€ invece di 999€ Wallbox trifase a prezzo minimo: ricarica fino a 22 kW con app e RFID a meno di 270€

Wallbox trifase a prezzo minimo: ricarica fino a 22 kW con app e RFID a meno di 270€ Digitalizzazione e stampa, i flussi di lavoro ibridi restano centrali per le PMI: il punto di vista di HP

Digitalizzazione e stampa, i flussi di lavoro ibridi restano centrali per le PMI: il punto di vista di HP Samsung ha trovato un modo per produrre memorie DRAM al di sotto dei 10nm

Samsung ha trovato un modo per produrre memorie DRAM al di sotto dei 10nm SK hynix ottiene la certificazione Intel Data Center Certified per le memorie DDR5 server: è la prima al mondo

SK hynix ottiene la certificazione Intel Data Center Certified per le memorie DDR5 server: è la prima al mondo Tesla deposita un brevetto per tetti "trasparenti" alle connessioni satellitari. Starlink in arrivo a bordo?

Tesla deposita un brevetto per tetti "trasparenti" alle connessioni satellitari. Starlink in arrivo a bordo? Diablo Immortal chiude l'Era della Follia: ecco tutte le novità dell'aggiornamento

Diablo Immortal chiude l'Era della Follia: ecco tutte le novità dell'aggiornamento Il prezzo della corsa all'IA sarà mostruoso: centinaia di miliardi di dollari, secondo Microsoft

Il prezzo della corsa all'IA sarà mostruoso: centinaia di miliardi di dollari, secondo Microsoft Uno youtuber ha ricreato il prototipo di Xbox, ed è meglio dell'originale

Uno youtuber ha ricreato il prototipo di Xbox, ed è meglio dell'originale Warner Bros. Discovery dice no a Paramount e conferma l'accordo con Netflix, ora è ufficiale

Warner Bros. Discovery dice no a Paramount e conferma l'accordo con Netflix, ora è ufficiale

23 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infonon è che a comprare queste GPU c'è Gino dodicenne che guarda il trailer del videogioco...

Gli IT manager sanno benissimo cosa comprano e perchè lo comprano; ad ogni presentazione di AMD le GPU sembrano eccellenti, poi non hanno seguito; vedremo se a questo giro cambierà o meno l'andazzo.

Gli IT manager sanno benissimo cosa comprano e perchè lo comprano; ad ogni presentazione di AMD le GPU sembrano eccellenti, poi non hanno seguito; vedremo se a questo giro cambierà o meno l'andazzo.

Come non hanno seguito? Instinct e' un successone anche nelle gen precedenti, sta in ben 8 dei 10 supercomputer piu' veloci li fuori.

Su larga scala quello che importa e' il rapporto fra costo, performance e consumi e in questo AMD va benissimo, il software te lo scrivi da solo.

Su scala piu' piccola il discorso cambia. Ma sono prodotti per gente che ne ordina decine di migliaia almeno.

Nvidia H200 in arrivo

spero che AMD abbia in campo, velocemente, un mi400. perchè nvidia in 4 mesi ha pronto H200. AMD è in ritardo, insegue, oltre a non avere una piattaforma software lontanamente simile a CUDA. se mi300 fosse stato pronto 9 mesi fa era un reale vantaggio. ma così? il 90% del mercato AI resterà a nvidia. non c'è storia.Su larga scala quello che importa e' il rapporto fra costo, performance e consumi e in questo AMD va benissimo, il software te lo scrivi da solo.

Su scala piu' piccola il discorso cambia. Ma sono prodotti per gente che ne ordina decine di migliaia almeno.

cambia si, e la scala "piu piccola" è in realtà il grosso del mercato che non ragiona come poche entità particolari.

AMD durante la presentazione dell'ultima trimestrale ha dichiarato: "Ora ci aspettiamo che il fatturato delle GPU per datacenter raggiunga circa 400 milioni nel quarto trimestre e superi 2 miliardi di dollari nel 2024 con l'aumento dei ricavi durante tutto l'anno"

parole di AMD è, non mie affermazioni o supposizioni; sono circa 1,6 miliardi quest'anno e si aspettano piu di 2 miliardi l'anno prossimo; nVidia quest'anno chiuderà intorno ai 40 Miliardi di dollari ( la divisione datacenter ovviamente ).

40 vs 1,6

quindi, se vogliamo chiamarla successone rispetto alle precedenti generazioni, certo, l'incremento è consistente e hanno sicuramente prodotti migliori del passato, ma vs la concorrenza bè, è tutto fuorchè un successone....

Su larga scala quello che importa e' il rapporto fra costo, performance e consumi e in questo AMD va benissimo, il software te lo scrivi da solo.

Su scala piu' piccola il discorso cambia. Ma sono prodotti per gente che ne ordina decine di migliaia almeno.

Si, vabbeh che sei un AMD fan, ma questa cosa te la sei inventata di sana pianta.

https://en.wikipedia.org/wiki/TOP500

https://www.top500.org/lists/top500/2023/11/

https://en.wikipedia.org/wiki/TOP500

https://www.top500.org/lists/top500/2023/11/

E' vero che Vul ha sbagliato e Instinct non sta in 8 supercomputer su 10 tuttavia dalla pagina di top500 che hai linkato si vede come MI250 sia presente nel 2% dei sistemi (H100 nell 1%) e che abbia una performance share del 25% quanto tutti i chip Nvidia messi insieme

Le 7900XTX 24GB non valgono le enormi seccature e limitazioni in termini di supporto software rispetto ad NVidia, ma se ci fosse qualcosa con il doppio della memoria, qualcosa potrebbe smuoversi.

https://en.wikipedia.org/wiki/TOP500

https://www.top500.org/lists/top500/2023/11/

Non sono fan proprio di nulla.

Comunque mi ero sbagliato, l'ultima volta che avevo controllato _AMD_ era in 8 dei 10 supercomputer, non instinct da solo.

Va detto che la classifica cambia di mese in mese, ci sono letteralmente 3 new entry a novembre 2023 nella sola top 10.

Comunque tutto questo non cambia che in ambito acceleratori AMD faccia molto bene e che in questo contesto quel che conta e' il rapporto fra consumi/prestazioni/costo, non l'avere l'acceleratore piu veloce.

Se X vende top a 50k, e tu vendi Y a 20k, ma va piu veloce di X e' chiaro che Y vendera' di piu.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".