IDF Fall 2007, processori Octo Core e GPU Intel

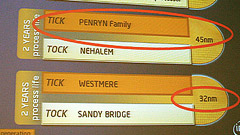

Intel anticipa le caratteristiche di Nehalem, architettura del dopo Penryn, promettendo processori ad otto core, memory controller integrato ed un nuovo bus di comunicazione. Si fa strada l'idea di destinazioni d'uso del modulo Larrabee anche per schede video di fascia alta, in concorrenza con AMD e NVIDIA. Questo e altro ancora nel report del Day 1

di Alessandro Bordin , Andrea Bai pubblicato il 19 Settembre 2007 nel canale SistemiNVIDIAIntelAMD

IDF Fall 2007, dal Tera Scale alle Mobile Sensing Platform

IDF Fall 2007, dal Tera Scale alle Mobile Sensing Platform Polestar 3 Performance, test drive: comodità e potenza possono convivere

Polestar 3 Performance, test drive: comodità e potenza possono convivere Qualcomm Snapdragon X2 Elite: l'architettura del SoC per i notebook del 2026

Qualcomm Snapdragon X2 Elite: l'architettura del SoC per i notebook del 2026 Recensione DJI Mini 5 Pro: il drone C0 ultra-leggero con sensore da 1 pollice

Recensione DJI Mini 5 Pro: il drone C0 ultra-leggero con sensore da 1 pollice Il nuovo Qualcomm Snapdragon 8 Gen 5 stupisce in un primo benchmark: è vicino alla versione Elite

Il nuovo Qualcomm Snapdragon 8 Gen 5 stupisce in un primo benchmark: è vicino alla versione Elite Sky e Amazon trasmetteranno la Champions League in Italia ancora per molti anni

Sky e Amazon trasmetteranno la Champions League in Italia ancora per molti anni 'Robot abbastanza forti da fratturare un cranio': scoppia il caso Figure AI

'Robot abbastanza forti da fratturare un cranio': scoppia il caso Figure AI Anche DAZN ha il suo Black Friday: 40 euro di sconto sul piano Family per utenti selezionati

Anche DAZN ha il suo Black Friday: 40 euro di sconto sul piano Family per utenti selezionati Carmageddon: Rogue Shift, il prossimo capitolo del franchise affidato agli italiani di 34BigThings

Carmageddon: Rogue Shift, il prossimo capitolo del franchise affidato agli italiani di 34BigThings Redal Alert 2: Command & Conquer si gioca senza installazioni adesso, direttamente da browser

Redal Alert 2: Command & Conquer si gioca senza installazioni adesso, direttamente da browser Kingston Technology: memorie e storage con il cliente al centro

Kingston Technology: memorie e storage con il cliente al centro Narwal Freo Z10 Ultra: il robot con mocio estensibile fra le migliori offerte Black Friday

Narwal Freo Z10 Ultra: il robot con mocio estensibile fra le migliori offerte Black Friday In 3 minuti le vedete tutte: sono le migliori offerte Amazon Black Friday, aggiornate (droni DJI, PS5, MacBook, iPhone)

In 3 minuti le vedete tutte: sono le migliori offerte Amazon Black Friday, aggiornate (droni DJI, PS5, MacBook, iPhone) Black Friday da record per Tineco: le scope elettriche più richieste esplodono di sconti

Black Friday da record per Tineco: le scope elettriche più richieste esplodono di sconti La nuova PS5 con Fortnite manda in tilt le offerte: bundle imperdibile per chi vuole passare alla next-gen a soli 349€

La nuova PS5 con Fortnite manda in tilt le offerte: bundle imperdibile per chi vuole passare alla next-gen a soli 349€ Amazon, i tagli hanno colpito soprattutto gli ingegneri: l'intelligenza artificiale avanza

Amazon, i tagli hanno colpito soprattutto gli ingegneri: l'intelligenza artificiale avanza Pazzesco: Panasonic Lumix DC-GH5M2E a 799€ e Lumix S5 II con 18-40mm a 1.499€, scorte limitate

Pazzesco: Panasonic Lumix DC-GH5M2E a 799€ e Lumix S5 II con 18-40mm a 1.499€, scorte limitate Ecco tutte le offerte Black Friday più folli sui robot aspirapolvere: sconti imperdibili su ECOVACS, Dreame, roborock, Xiaomi e altri

Ecco tutte le offerte Black Friday più folli sui robot aspirapolvere: sconti imperdibili su ECOVACS, Dreame, roborock, Xiaomi e altri

38 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoProbabilmente ai software che usi gli è troppo anche un solo core moderno, perchè le applicazioni che hanno una qualche rilevanza tecnica/commerciale oggi giorno sono tutte multithread.

X chi dice che i quad o octa-core sono inutili: è da quando esiste l'informatica che si sente la parola "inutile", in frasi che nel giro di poco tempo furono smentite. Certo c'è stato del vaporware e insuccessi, ma ci sarà sempre un modo di sfruttare la potenza elaborativa a disposizione.

Per esempio io sto ancora aspettando un uso massiccio dell'interfaccia vocale: già quella di Vista è davvero promettente (ma quando la localizzano in italiano?)

Ricordi...

...l'MC68010-8 (le ultime due cifre corrispondevano alla velocità in MHz) lo sostituì al processore "originale", il glorioso MC68000, di cui era/è dotato il mio primo Amiga 500 (avrei voluto comperare il 2000 con scheda Janus ma costava troppo)...Il 68010 poteva essere più veloce grazie alla sua piccola loop-cache memory (la cache memory per istruzioni venne introdotta nel 68020 ed assommava a 256 Bytes) ma purtroppo generava delle guru-meditations a causa di istruzioni che nel 68010 avrebbero dovuto essere eseguite in modalità "privilegiata"...

Per chi si ricorda il programma Gomf 3.0 era molto di aiuto...

Un ragazzo al di sotto dei 20 anni probabilmente troverà ridicoli i numeri (piccoli) che ho enunciato sopra ma questo era...

Quando poi si parla del concetto di "inutile" nel mondo dei computer (in Italia "calcolatori elettronici"

Quando nel 1985/1986 Intel presentò l'80386 (con un bug sulle istruzioni MUL che lo faceva "scaldare" parecchio già a 16 MHz...) le "cassandre" dell'epoca si affannarono a presagire sventure tremende a causa della modalità FLAT del protected mode che permetteva di avere un enorme spazio di memoria indirizzabile ammontante a 4GiB...

Ora si parla tanto di "memorie a stato solido", forse qualcuno si ricorderà delle unità bubble memory di I.B.M che equipaggiarono i primi Shuttle...

Grazie.

Marco71.

Non sono d'accordo...

...con chi limita i "vantaggi teorici" (per ora) dell'impiego del set di istruzioni S.S.E4 a poche "applicazioni di nicchia" in ambito grafico e gaming principalmente...Con l'utilizzo di compilatori Intel Fortran o C/C++ si può trarre un vantaggio da ogni set di istruzioni s.i.m.d più esteso in molti ambiti del calcolo scientifico (per fare un esempio)...

Senza contare gli algoritmi "base 16" per il divider e quello migliorato per il calcolo delle radici quadrate...

Grazie.

Marco71.

Beh, dubito che l'utente comune usi altre applicazioni a parte quelle.

Tutti i software che fanno operazioni intensive come comprimere audio o video, rendirizzare immagini 3D , calcoli scientifici parallelizzabili , etc.... sono multithreaded da una vita.

La verità è che all'utente casalingo che usa una sola applicazione il multicore non serve a nulla, perchè le applicazioni che usa l'utente casalingo , anche se a volte sono parallelizzabili, richiedono una potenza infima e quindi la parallelizzazione è totalmente inutile, fa crescere i costi di sviluppo e porta spesso più overhead di calcolo per via della sincronizzazione tra i vari thread. Il multicore all'utente comune serve solo per il multitasking (usare più applicazioni in contemporanea)

I giochi? Beh, oggi il limite nei giochi è soprattutto la scheda video più che i processori. Se non hanno ancora fatto l'"ottimizzazione" allora significa che probabilmente non è così fondamentale per il risultato finale.

Comunque sono sicuro che la maggiorparte dei giochi moderni usa un approccio multithreaded in qualche modo senza che l'utente comune lo sappia.

Saluti

Soliti discorsi?

@markenforcer:il link al post che riferisci spiega (a parte qualche entusiasmo ed ottimismo di troppo), quel che già si afferma nei "soliti discorsi" sui multicore non sfruttati o addirittura al momento inutili: tutto dipende dal software applicativo da rivedere anzi ripensare per poterlo rendere multicore (se e dove è possibile).

Che i S.O. recenti, Linux in particolare, siano già progettati multicore non vi sono mai stati dubbi nei "soliti discorsi", ma quanto questo parallelismo possa essere spinto, ovvero quante operazioni siano sensatamente e significativamente sovrapponibili nelle componenti di un sistema operativo, e sopratutto che percentuale di impatto abbiano sul thruput generale, è tutto da vedersi (rammento che quando una o più applicazione stanno impegnando massivamente la cpu il S.O. è in condizione di "wake-up" ossia dormiente).

Quanto agli applicativi, la parallelizzazione perfetta è una chimera.

Ma il vero problema è che nel mare di software esistente ed indispensabile ancora squisitamente monothread, per poter fare interventi ad hoc occorne ricomprenderne perfettamente la logica di funzionamento, ed il software moderno e fortemente packetizzato, nel senso che è composto in massima parte di moduli precostruiti (purtroppo), di cui si conoscono esattamente le specifiche di utilizzo ma molto spesso ci si è del tutto dimenticati della logica di funzionamento (visto che documentare con dettagliati diagrammi di flusso è considerato ormai una ridicola mania del passato...).

In questa ottica l'ottimismo dell'autore del post segnalato è completamente fuori luogo.

i h

. dtutto da vedereposssano non il più pgli dare in qualche modo, ove possibile, i. coquasi co

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".