NVIDIA Tegra K1: un SoC con integrata una GPU Kepler

In anticipo rispetto all'apertura ufficiale dell'International CES 2014 NVIDIA presenta il proprio SoC di nuova generazione, sino ad oggi noto con il nome in codice di Logan. Tegra K1 è basato su architettura di GPU della famiglia Kepler e abbina a questa due differenti varianti di CPU: la prima dual Denver a 64bit, la seconda quad core Cortex A15 a 32bit

di Alessandro Bordin , Paolo Corsini pubblicato il 06 Gennaio 2014 nel canale TabletNVIDIATegra

Tegra K1

Domenica 6 Gennaio 2013 è stata per NVIDIA la giornata di presentazione ufficiale di varie novità che avrebbero poi caratterizzato i propri piani di sviluppo per l'interno 2013. Ci riferiamo al SoC Tegra 4 e alla console portatile Shield, prodotti che hanno mostrato la notevole attenzione dell'azienda americana versoi l'ecosistema Android e più in generale per i prodotti mobile.

Domenica 5 Gennaio 2014, 2 giorni prima dell'apertura ufficiale dell'International CES 2014 di Las Vegas, la storia si ripete con un nuovo evento stampa di NVIDIA con il quale l'azienda americana sceglie di anticipare quelli che saranno prodotti e tecnologie attesi per l'anno da poco iniziato.

Tegra K1 è il nome scelto da NVIDIA per annunciare quello che tutti attendevano essere Tegra 5, cioè la prossima generazione di architettura SoC che NVIDIA renderà disponibile sul mercato. Sino ad oggi questa soluzione è stata indicata da NVIDIA con il nome in codice di Logan.

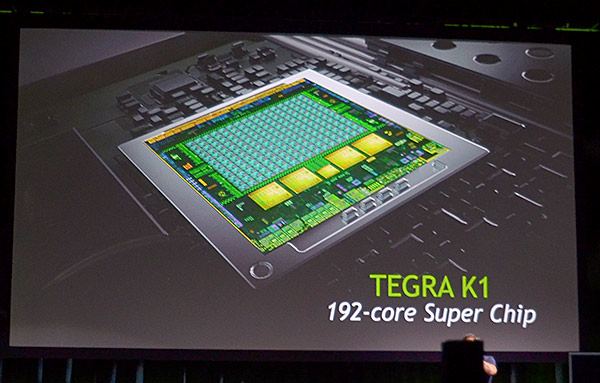

Si tratta del primo chip che, come chiaramente rimarcato dal CEO di NVIDIA Jen-Hsun Huang, integra al proprio interno un'architettura di GPU della famiglia Kepler. Da questo la scelta del nome Tegra K1, volendo chiaramente indicare il passaggio evolutivo rispetto all'architettura Tegra di precedente generazione.

Tegra K1 integra al proprio interno 192 CUDA cores, lo stesso quantitativo che NVIDIA integra in un singolo modulo SMX presente all'interno delle GPU Kepler attualmente in commercio. E' proprio l'integrazione dell'architettura Kepler all'interno della famiglia Tegra che permette ad NVIDIA di poter affermare come vi sia stata una unificazione tra le piattaforme PC, console e mobile verso un'unica architettura e un singolo engine.

A testimoniare la radicalità di questo approccio NVIDIA cita Tim Sweeney, fondatore di Epic Games e uno dei più quotati e rispettati sviluppatori nel mondo dei videogiochi. Per Sweeney è al momento possibile qualsiasi tipo di applicazione grafica che venga eseguita da un PC o da una delle nuove console di fascia alta e fare in modo che questo venga eseguito anche da un dispositivo dotato di SoC Tegra K1. Questo risultato è per certi versi impensabile per Sweeney, che riteneva raggiungibile un obiettivo di questo tipo non prima di 3 o 4 anni da oggi.

Quali sono le potenzialità di questo prodotto? NVIDIA ha scelto di mostrare un confronto con Playstation 3 e Xbox 360, quindi le due console di precedente generazione, segnalando come Tegra K1 vanti una potenza di elaborazione superiore con un livello di TDP che è pari a 1/20, passando dai 100 Watt delle due console ai 5 Watt della nuova proposta NVIDIA. Nel confronto con il SoC Apple A7, utilizzato in iPad Mini con Display Retina, iPhone 5S e iPad Air, le prestazioni di Tegra K1 sono ben più elevate, con un dato che è più di 2 volte quello registrato dal SoC A7 nel test GFXBench 3.0 Manhattan.

NVIDIA renderà disponibili al debutto due distinte versioni di chip Tegra K1. La prima prevede l'abbinamento con una componente CPU dual core basata su architettura Denver di NVIDIA. La seconda sarà invece costruita integrando chip quad core basati su architettura Cortex A15s. La prima è dotata di supporto ai 64bit, in quanto basata sul set di istruzioni ARMv8 64bit; la seconda è invece una tradizionale a 32bit.

Entrambe di tipo Superscalare, nel primo caso a 7 vie e nel secondo sino a 3 vie, con frequenze di clock massime pari rispettivamente a 2,5 GHz e 2,3 GHz. Significative differenze anche per quanto riguarda la cache L1: due blocchi da 32 Kbytes ciascuno per dati e istruzioni per la soluzione Quad A15 contro i 128 Kbytes per dati e 64Kbytes per le istruzioni implementati in Tegra K1 con core CPU Denver. La prima versione di Tegra K1 attesa al debutto sarà quella con core Cortex A15 prevista per la prima metà del 2014, mentre per la declinazione a 64bit con core Denver dovremo attendere la seconda metà del 2014.

La nuova architettura Tegra K1 troverà spazio anche nel mondo delle automobili: NVIDIA ha sin d'oggi indicato quello che sarà il chip destinato ai propri partner presenti nel mondo automotive con, con il nome di Tegra K1 VCM. E' evidente come questo sia un mercato potenzialmente molto interessante per l'azienda americana che del resto già con un paio di precedenti generazioni di SoC Tegra è riuscita a ben proporsi nel segmento.

L'importanza di poter disporre di un processore molto potente in un'automobile assume una certa importanza se si pensa al numero di sensori che vi si trovano integrati, ma anche in riferimento a quelli che verranno (fra pochissimo): sono stati citati ad esempio il riconoscimento automatico dei cartelli stradali, il calcolo delle distanze e velocità dei veicoli che si trovano nelle vicinanze della propria vettura, la valutazione di rischio per quanto riguarda i pedoni e molto altro ancora.

L'annuncio odierno del nuovo SoC Tegra K1 apre spazio, quantomeno sulla carta, a numerosi nuovi prodotti che verranno presentati dai partner NVIDIA nel corso dell'anno. Riteniamo che il Mobile World Congress di Barcellona, evento che aprirà i battenti il prossimo 24 Febbraio, sarà una sede nella quale NVIDIA anticiperà ulteriori informazioni sui propri prodotti della serie Tegra K1 oltre a fornire nuovi dettagli architetturali su Denver, la propria CPU con supporto ai 64bit che verrà resa disponibile nella prima declinazione proprio in Tegra K1.

Lenovo Legion Go 2: Ryzen Z2 Extreme e OLED 8,8'' per spingere gli handheld gaming PC al massimo

Lenovo Legion Go 2: Ryzen Z2 Extreme e OLED 8,8'' per spingere gli handheld gaming PC al massimo AWS re:Invent 2025: inizia l'era dell'AI-as-a-Service con al centro gli agenti

AWS re:Invent 2025: inizia l'era dell'AI-as-a-Service con al centro gli agenti Cos'è la bolla dell'IA e perché se ne parla

Cos'è la bolla dell'IA e perché se ne parla SpaceX: un satellite ha fotografato il satellite Starlink 35956 danneggiato in orbita mostrando le sue condizioni

SpaceX: un satellite ha fotografato il satellite Starlink 35956 danneggiato in orbita mostrando le sue condizioni 36 idee regalo con offerte Amazon sotto i 50€, arrivano prima di Natale (controllate ad una ad una)

36 idee regalo con offerte Amazon sotto i 50€, arrivano prima di Natale (controllate ad una ad una) Sony assume il controllo dei Peanuts: Snoopy diventa giapponese

Sony assume il controllo dei Peanuts: Snoopy diventa giapponese DJI Neo scende a 149€ su Amazon, in versione Combo con accessori e 3 batterie a 259€ ma solo fino a mezzanotte

DJI Neo scende a 149€ su Amazon, in versione Combo con accessori e 3 batterie a 259€ ma solo fino a mezzanotte Scoperto un nuovo esopianeta che orbita intorno a due stelle, come Tatooine di Star Wars

Scoperto un nuovo esopianeta che orbita intorno a due stelle, come Tatooine di Star Wars Blue Origin NS-37: successo per la missione con un passeggero in sedia a rotelle oltre la linea di Kármán

Blue Origin NS-37: successo per la missione con un passeggero in sedia a rotelle oltre la linea di Kármán Potrebbe essere stata rilevata una superkilonova: doppia, potente esplosione, spaziale

Potrebbe essere stata rilevata una superkilonova: doppia, potente esplosione, spaziale La cometa interstellare 3I/ATLAS è nel punto più vicino alla Terra a 269 milioni di chilometri

La cometa interstellare 3I/ATLAS è nel punto più vicino alla Terra a 269 milioni di chilometri Xiaomi 17 Ultra: l'autonomia non sarà un problema

Xiaomi 17 Ultra: l'autonomia non sarà un problema Il processo produttivo a 2 nm di TSMC è già sold out

Il processo produttivo a 2 nm di TSMC è già sold out The Elder Scrolls VI nel 2029 e Fallout 5 non prima del 2030? Nuove voci sulla roadmap di Bethesda

The Elder Scrolls VI nel 2029 e Fallout 5 non prima del 2030? Nuove voci sulla roadmap di Bethesda Il Ryzen 7 9850X3D appare nel catalogo di alcuni rivenditori online, ma rimane il dubbio sul prezzo

Il Ryzen 7 9850X3D appare nel catalogo di alcuni rivenditori online, ma rimane il dubbio sul prezzo Weekend pre natalizio Amazon, ecco tutte le offerte attive con novità e sorprese

Weekend pre natalizio Amazon, ecco tutte le offerte attive con novità e sorprese

32 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoE cosa ancora piu strabiliante, credo che in 3-4 anni, supereranno la ps4 e xboxone...che invece dovranno durare altri 3-4 anni (in piu). Penso che sarà l'ultima generazione delle console, come le conosciamo. Non ha piu senso avere scatole che non possono aggiornarsi per oltre 8 anni...

E cosa ancora piu strabiliante, credo che in 3-4 anni, supereranno la ps4 e xboxone...che invece dovranno durare altri 3-4 anni (in piu). Penso che sarà l'ultima generazione delle console, come le conosciamo. Non ha piu senso avere scatole che non possono aggiornarsi per oltre 8 anni...

A leggere sommariamente la news in effetti é tanta roba, ma mi sfugge come possa ARM compensare tutte le istruzioni che normalmente sono a carico della CPU ( ad esempio la parte relativa all'intelligenta artificiale ) rispetto appunto ai processori che montano PS3 e Xbox.

Di primo acchitto direi che hanno fatto un bel salto in avanti in termini di GPU su SOC ARM, ma tanto dello sviluppo fatto per i giochi é ancora CPU oriented e li Intel con x86 la fà ancora da padrone.

Condivido pienamente, già Tegra 4 è ai livelli del Qualcomm 805 con consumi persino inferiori, ma credo che siano solo questioni di tempi, occorre aspettare la scadenza dei contratti, che la Qualcomm ha fatto con i top di gamma di vari brand.

Dal punto di vista puramente teorico anche meno, però un Android non ha le performance del Linux Oriented del SO di PS4 e del Windows di X1, inoltre c'è tutto il resto, oltre alla CPU/GPU c'è il fatto che le DDR3 o le GDDR5 sono più preformanti delle LPDDR3. Tuttavia condivido che questa generazione di console sarà anche l'ultima e che diventerà di dominio pubblico un sistema PC SetTopBox-Linux oriented, dove Valve è all'avanguardia con le Steam Machine, ma non è detto che alla fine saranno le più diffuse, sicuramente Apple e Sony faranno i loro sistemi (hanno già un so Linux Oriented), mentre Microsoft potrebbe farà la stessa cosa ma con una sorta di "Windows for Games" basato su Windows 8/9, e non è detto che EA e Ubisoft non faranno la loro. Ovviamente il porting fra SteamOS, quello di Apple derivato da OSx e quello di Sony, aggiornamento di quello montato su PS4, sarà veloce, semplice e con costi quasi azzerati essendo tutti delle distribuzioni Linux sulla stessa architettura.

Il SetTopBox di Microsoft potrebbe addirittura non esserci: Si ritroverebbe svantaggiata proprio per avere un SO completamente differente dai concorrenti, e farebbe la fine di Nintendo, inoltre Microsoft vuole vendere il settore videoludico. Fra 10 anni gran parte dei videogiochi ad alto livello gireranno su Linux/x86, se andiamo a vedere tutti i videogiochi, compresi quelli di cellulari e tablet, è già così.

Poi mi piacerebbe capire come tutta questa potenza grafica sarà sfruttata coi budget dei giochi da smartphone. Su console abbiamo visto che la grafica HD ha portato a budget milionari.

Poi mi piacerebbe capire come tutta questa potenza grafica sarà sfruttata coi budget dei giochi da smartphone. Su console abbiamo visto che la grafica HD ha portato a budget milionari.

Batteria quì, batteria là, conta solo quello vero ?

Se la batteria non è sufficiente non castri l'HW, aumenti la capacità della batteria ! Anzichè tenere quei giocattolini che ti infilano nei tablet di bassa lega esistono ben altre batterie da tablet che arrivano tranquillamente 4800-5000mAh, capaci di far durare un core i5 sulle 8 ore di media.

Le prestazioni sono la prima cosa in un evoluzione e poi da quando siamo tutti in gita nel deserto ? Tu durante la giornata solitamente ti capita di non passare mai in nessun edificio dotato di presa ? Non passi mai in un ufficio o altro edificio lavorativo o presso casa tua o di un conoscente ? Se sei fuori 24/24h ?

Se la batteria non è sufficiente non castri l'HW, aumenti la capacità della batteria.

Inoltre il Tegra consuma meno dei Qualcomm, tuttavia, il consumo di un SoC è indirettamente proporzionale alla dimensione dell'architettura, e arrivati sotto i 10nm si è ai limiti del Silicio, quindi per aumentare le capacità computazionali occorrerà ingrandire i chip, ma il rapporto prestazioni/potenza assorbita rimarrà sempre uguale. Con i desktop o con le console è una cosa che puoi permetterti, non con il reparto Mobile, quindi fra una decina d'anni o si useranno materiali differenti dal Silicio o la legge di Moore sarà solo un ricordo...

Per chi lavora in ufficio non è mai stato un problema la batteria, tanto lo tieni attaccato alla porta USB del PC tutto il tempo, io per lavoro giro, e in macchina è sempre attaccato all'accendi sigari, ma per lo studente è un po differente, a scuola non può caricarlo, va in giro con lo scuoter o con i mezzi pubblici e lo usa molto di più per giocarci. Per uno studente arrivare a fine giornata con lo SP ancora carico è davvero dura.

Il grafene è già pronto da anni sia per la realizzazione di micro-circuiti elettronici che per la creazione di batterie nettamente più capienti ( che dovrebbero servire più che nell'informatica nel mercato automobilistico futuro ma che ancora oggi non si decidono per via degli interessi sul petrolio ).

Anzi è già pronto pure il "grafine", un materiale sintetico superiore al grafene.

Se la batteria non è sufficiente non castri l'HW, aumenti la capacità della batteria ! Anzichè tenere quei giocattolini che ti infilano nei tablet di bassa lega esistono ben altre batterie da tablet che arrivano tranquillamente 4800-5000mAh, capaci di far durare un core i5 sulle 8 ore di media.

Le prestazioni sono la prima cosa in un evoluzione e poi da quando siamo tutti in gita nel deserto ? Tu durante la giornata solitamente ti capita di non passare mai in nessun edificio dotato di presa ? Non passi mai in un ufficio o altro edificio lavorativo o presso casa tua o di un conoscente ? Se sei fuori 24/24h ?

Vada pure per un 5000mah in un tablet, ma in uno smartphone? Ho i miei dubbi che sarebbe possibile fare qualcosa di tascabile con quella capacità.

E vabbè che ormai vanno di moda gli smartphone sempre più grossi che sono tutt'altro che tascabili (e ho l'impressione che la cosa sia parzialmente dovuta alla necessità di infilarci batterie sempre più grandi), ma credo che ci sia un limite che su tablet può anche non esserci.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".