AMD sulla buona strada per migliorare l'efficienza energetica di 100 volte entro il 2027

Lisa Su, CEO di AMD, ha parlato delle sfide energetiche dell'intelligenza artificiale e degli sforzi che AMD sta facendo a tutto tondo, insieme all'ecosistema hardware, per non rimanere travolti dall'immensa richiesta di energia necessaria per addestrare modelli sempre più evoluti e complessi.

di Manolo De Agostini pubblicata il 24 Maggio 2024, alle 09:11 nel canale ProcessoriThreadripperEPYCInstinctRyzenRadeonAMD

In occasione dell'ITF World di Anversa, l'amministratore delegato di AMD Lisa Su ha ricevuto il premio IMEC Innovation Award per il suo contributo alla promozione dell'innovazione nel settore dell'elaborazione adattiva ad alte prestazioni.

Nel corso dell'evento, Su ha tenuto un intervento dal titolo "Looking Beyond the Silicon Horizon, Breaking Barriers in AI Performance and Efficiency", concentrandosi sul modo in cui AMD sta perseguendo una progettazione olistica per guidare l'innovazione in termini di prestazioni ed efficienza.

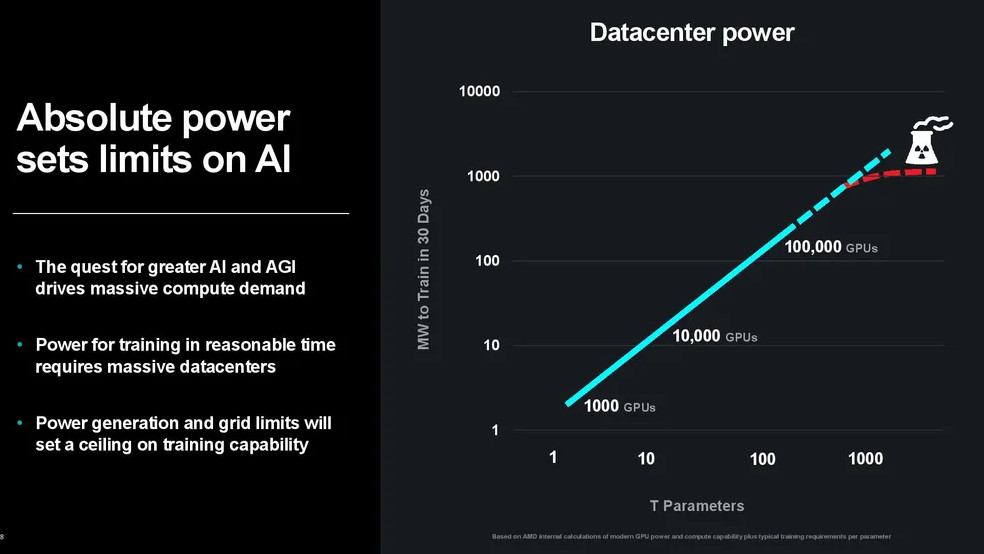

La manager ha illustrato i crescenti vincoli energetici dei datacenter causati dalla crescita nella domanda di calcolo generata dall'intelligenza artificiale, segnalando che i limiti legati alla generazione di energia e alla rete elettrica rappresentano un tetto alla capacità di addestramento dell'IA.

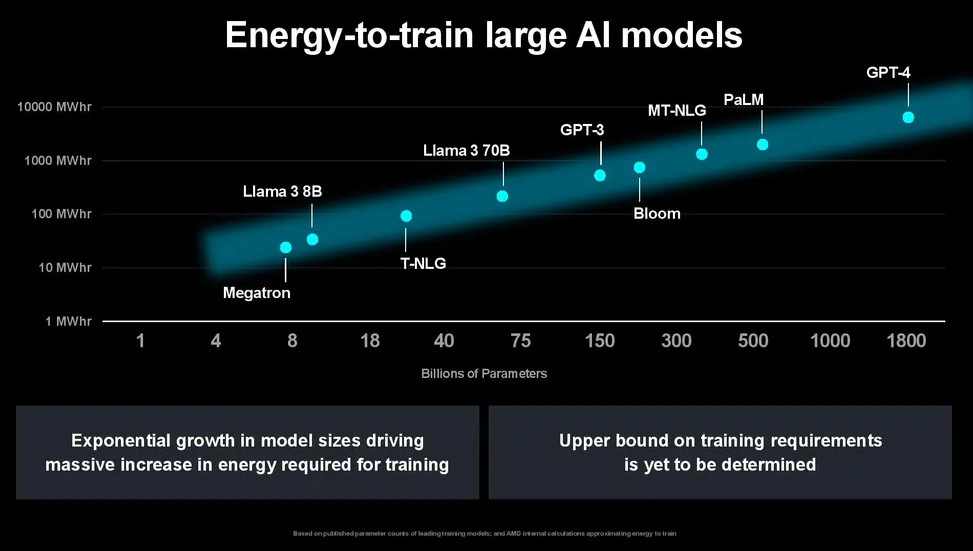

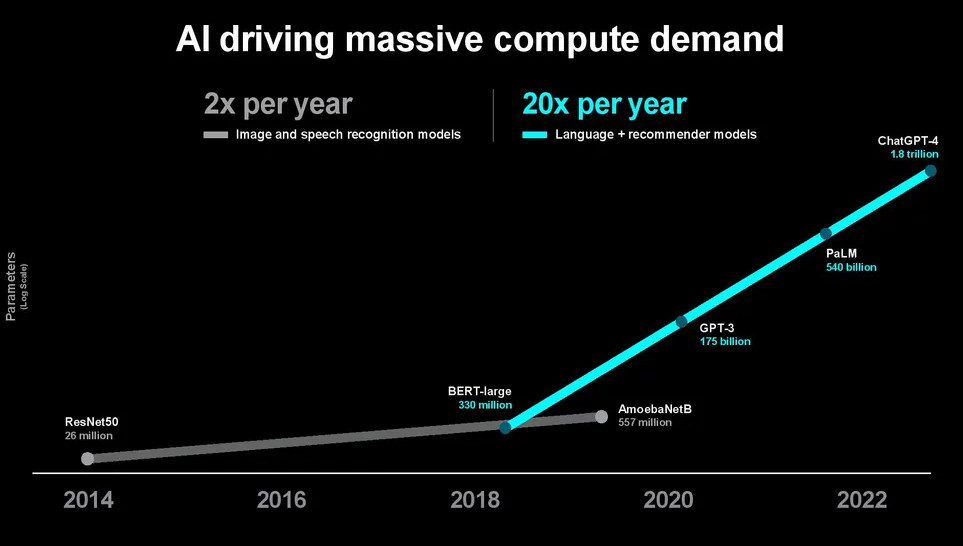

Lisa Su ha rilevato che l'intelligenza artificiale sta determinando una crescita esponenziale della domanda di calcolo e del relativo consumo energetico. Al crescere delle dimensioni dei modelli, aumentano anche i requisiti energetici per addestrarli. Per questo motivo, raggiungeremo i limiti pratici imposti dalla rete elettrica e dalla capacità di generazione delle centrali. Tant'è vero che sempre più spesso si pensa a piccoli reattori nucleari da installare direttamente accanto ai grandi datacenter.

Le dimensioni dei modelli di IA generativa crescono di 20 volte all'anno e vengono addestrati su decine di migliaia di GPU che consumano fino a decine di migliaia di megawattora. Secondo Su, la rapida espansione delle dimensioni dei modelli potrebbe richiedere presto fino a centinaia di migliaia di GPU per l'addestramento, forse con diversi gigawatt di potenza per addestrare un singolo modello. Numeri che non sono certo sostenibili.

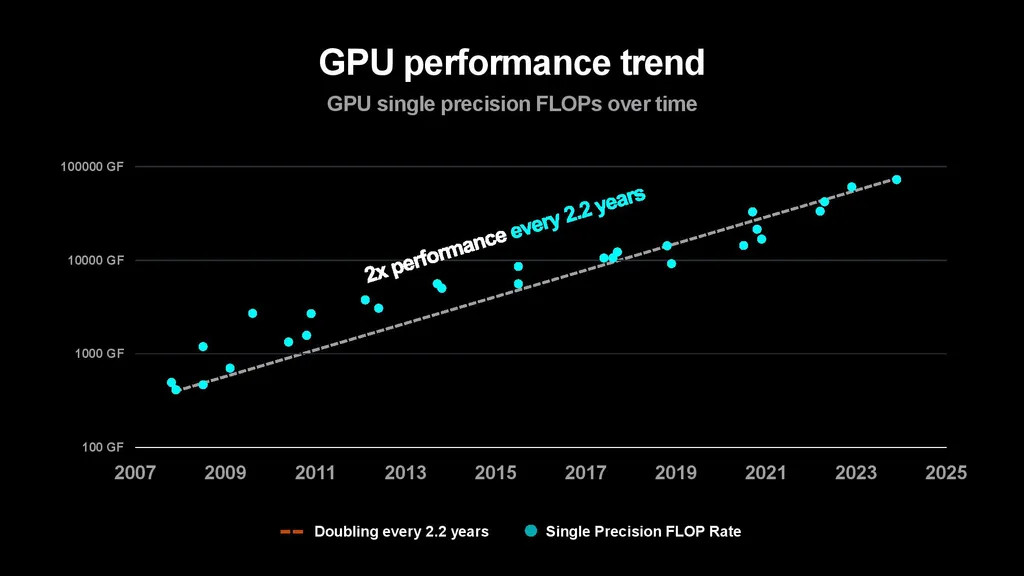

Per soddisfare la crescente domanda di calcolo per l'IA sarà necessaria un'innovazione globale e una profonda collaborazione a livello industriale che comprenda nuove architetture, processi produttivi, packaging avanzato, co-progettazione di software e hardware e molto altro ancora.

Il massimo dirigente di AMD ritiene che il miglioramento dell'efficienza richieda ottimizzazioni che vadano oltre il livello del dispositivo e del processore ma che investano l'intero sistema - è necessario quindi un approccio olistico - globale, non confinato a un singolo ambito - alla progettazione.

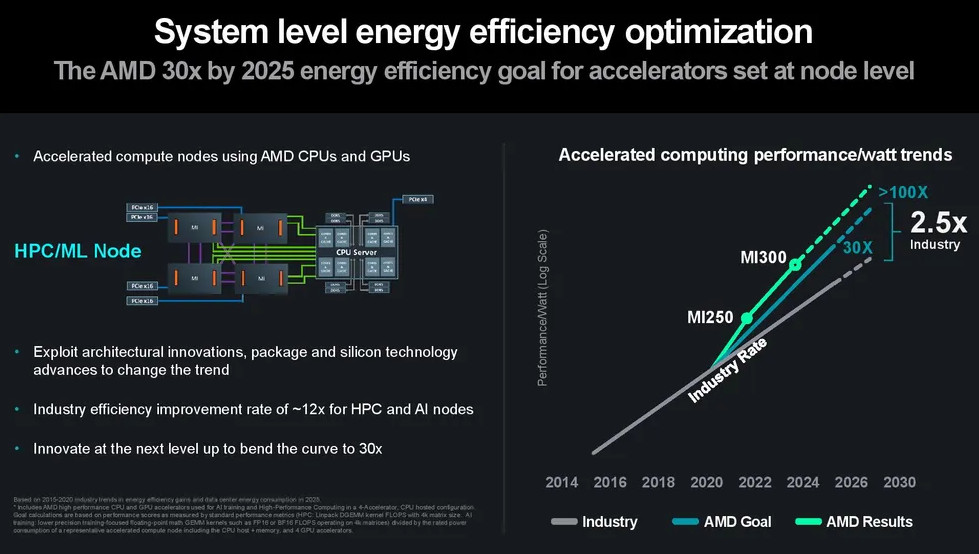

Da tempo AMD persegue un costante progresso dell'efficienza: l'iniziativa 30x25 punta a migliorare l'efficienza energetica dei nodi di calcolo accelerati costituiti da CPU EPYC e GPU Instinct di 30 volte entro il 2025 (30x25) rispetto al 2020. Su ha annunciato che AMD non solo è sulla buona strada per raggiungere questo obiettivo, ma vede anche un percorso per un miglioramento di oltre 100 volte entro il 2026-2027.

In realtà, l'impegno di AMD risale al 2014, quando l'obiettivo era quello di migliorare l'efficienza delle APU di 25 volte entro il 2020: il target non solo è stato centrato, ma anche superato con un progresso di 31,7 volte.

DJI Mavic 4 Pro: sblocca un nuovo livello per le riprese aeree

DJI Mavic 4 Pro: sblocca un nuovo livello per le riprese aeree Idrogeno verde in Europa: nuovi studi prevedono costi ben superiori alle aspettative

Idrogeno verde in Europa: nuovi studi prevedono costi ben superiori alle aspettative Mario Kart World lancia Switch 2: la magia Nintendo ora in 4K

Mario Kart World lancia Switch 2: la magia Nintendo ora in 4K Scambio di chiavi quantistico via satellite: Colt, Honeywell e Nokia ci provano. Ma ha senso?

Scambio di chiavi quantistico via satellite: Colt, Honeywell e Nokia ci provano. Ma ha senso? HONOR 400 è un successo! Forte slancio nelle vendite con un +400%

HONOR 400 è un successo! Forte slancio nelle vendite con un +400% Redmi Pad 2, i nuovi tablet Xiaomi costano a partire da 200 euro: ecco le novità

Redmi Pad 2, i nuovi tablet Xiaomi costano a partire da 200 euro: ecco le novità All'aeroporto di Fiumicino il più grande sistema di accumulo italiano con batterie EV usate

All'aeroporto di Fiumicino il più grande sistema di accumulo italiano con batterie EV usate HONOR 400 vs HONOR 400 Pro: tutte le differenze, le specifiche e i punti di forza a confronto

HONOR 400 vs HONOR 400 Pro: tutte le differenze, le specifiche e i punti di forza a confronto Nintendo Switch 2 debutta oggi nei negozi! Prezzo e dettagli

Nintendo Switch 2 debutta oggi nei negozi! Prezzo e dettagli Samsung Galaxy S25 Edge è disponibile in Italia! Lo smartphone sottile, potente e intelligente come mai prima

Samsung Galaxy S25 Edge è disponibile in Italia! Lo smartphone sottile, potente e intelligente come mai prima  Nothing presenterà le sue prime cuffie over-ear il prossimo 1° luglio insieme a Phone(3)

Nothing presenterà le sue prime cuffie over-ear il prossimo 1° luglio insieme a Phone(3)  Le nuove soluzioni Lenovo per lo storage e oltre: ThinkAgile, ThinkSystem e gli AI Starter Kit

Le nuove soluzioni Lenovo per lo storage e oltre: ThinkAgile, ThinkSystem e gli AI Starter Kit Netatmo presenta la nuova Stazione Meteo ORIGINAL: aggiornata, potenziata con misurazione pollini e UV

Netatmo presenta la nuova Stazione Meteo ORIGINAL: aggiornata, potenziata con misurazione pollini e UV Cybersecurity: Fortinet rende disponibile Workspace Security Suite e aggiorna FortiDLP

Cybersecurity: Fortinet rende disponibile Workspace Security Suite e aggiorna FortiDLP Netatmo Stazione Meteo ORIGINAL: il ritorno di un’icona, più smart che mai

Netatmo Stazione Meteo ORIGINAL: il ritorno di un’icona, più smart che mai Il meglio dello State of Play, dal nuovo titolo di Suda51 alla collezione più completa di Mortal Kombat

Il meglio dello State of Play, dal nuovo titolo di Suda51 alla collezione più completa di Mortal Kombat Homematic IP: nuova app per ottimizzare i flussi energetici della casa

Homematic IP: nuova app per ottimizzare i flussi energetici della casa

8 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoconcordo.

ma la riflessione è più ampia: l'industria informatica e sw NON vuole affatto efficienza... i prodotti sono inefficienti-per-design, come ogni versione di Windows/Office (fanno sempre le stesse cose usando x10 volte le risorse delle vers precedenti) dimostra in modo lapalissiano da decenni. E questo per la gioia dei produttori hw.

sempre più spesso si pensa a piccoli reattori nucleari da installare direttamente accanto ai grandi datacenter.

così in caso di "problemi" si torna davvero al medioevo: si friggono in un solo colpo la realtà del mondo e il virtuale dei dati

concordo, ma nella stesa catgoria potrebbe ricadere anche il giocare ad un videogioco a 40 anni, o usare un telefonino per chattare.

l'efficienza è efficienza, ossia fare lo stesso lavoro spendendo meno energia; che poi questo lavoro sia lodevole o solo uno svago non è competenza giudicarlo a chi si prodiga per fare le cose più efficienti; loro le fanno e basta, al di là dell'uso che ne fa la gente.

quello che dovrebbe peroccupare la gente non è quanta energia consumano le AI e non è se queste vengono usate per generare foto di gattini cicciolosi, ma se qualcuno le usa per generare finte notizie che destabilizzano il mondo, come è successo con la foto dell'attacco terroristico al Pentagono di pochi giorni fa, diffusa attraverso un account verificato.

dopo che hai fatto miliardi facendo un colpo del genere, destabilizzando i mercati anche solo per 5 minuti, se ti dicono che sei "brutto e cattivo" non credo che ti interessi più di tanto, se ti mettono in galera per un tempo proporzionato al disturbo che hai provocato, allora ci pensi.

quindi servono regole per l'uso delle AI...

ogni immagine generata da una AI dovrebbe avere una filigrana e essere riconoscibile da chiunque, come tutti i testi che vengono generati.

persone cieche.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".