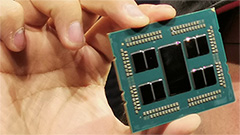

AMD Ryzen Threadripper 3990X: la prima CPU desktop a 64 core

E' il primo processore per sistemi desktop dotato al proprio interno di 64 core e rappresenta quanto di più veloce sia al momento disponibile in commercio. Richiede però applicazioni che siano in grado di sfruttarne il così elevato numero di core presenti per dare il meglio. Non è quindi per tutti, a partire dal prezzo: ben 3.999 dollari.

di Paolo Corsini pubblicato il 07 Febbraio 2020 nel canale ProcessoriThreadripperRyzenAMD

AMD Ryzen Threadripper 3960X: 24 core di terza generazione

AMD Ryzen Threadripper 3960X: 24 core di terza generazione AMD Ryzen Threadripper 3970X: 32 core che ora vanno al massimo

AMD Ryzen Threadripper 3970X: 32 core che ora vanno al massimo Lenovo Legion Go 2: Ryzen Z2 Extreme e OLED 8,8'' per spingere gli handheld gaming PC al massimo

Lenovo Legion Go 2: Ryzen Z2 Extreme e OLED 8,8'' per spingere gli handheld gaming PC al massimo AWS re:Invent 2025: inizia l'era dell'AI-as-a-Service con al centro gli agenti

AWS re:Invent 2025: inizia l'era dell'AI-as-a-Service con al centro gli agenti Cos'è la bolla dell'IA e perché se ne parla

Cos'è la bolla dell'IA e perché se ne parla Cloud sovrano: l'approccio di Broadcom con VMware Sovereign Cloud

Cloud sovrano: l'approccio di Broadcom con VMware Sovereign Cloud HONOR conferma l'arrivo in Italia di Magic 8 Pro e lancia una campagna natalizia dedicata alla fotografia AI

HONOR conferma l'arrivo in Italia di Magic 8 Pro e lancia una campagna natalizia dedicata alla fotografia AI La Cina sotto pressione impone maniglie meccaniche per le portiere. L'Europa copierà?

La Cina sotto pressione impone maniglie meccaniche per le portiere. L'Europa copierà? OpenAI integra le app in ChatGPT per trasformare le chat in azioni

OpenAI integra le app in ChatGPT per trasformare le chat in azioni NVIDIA sarebbe pronta a tagliare la produzione: le GPU consumer diventeranno merce rara?

NVIDIA sarebbe pronta a tagliare la produzione: le GPU consumer diventeranno merce rara? Prezzo minimo storico per iPhone 16 Pro: modello di punta Apple che scende a 911€ su Amazon

Prezzo minimo storico per iPhone 16 Pro: modello di punta Apple che scende a 911€ su Amazon Riot Games scopre una falla nei BIOS che favoriva i cheater su PC

Riot Games scopre una falla nei BIOS che favoriva i cheater su PC Beats in super offerta su Amazon: auricolari e cuffie iconiche ai prezzi più bassi del momento

Beats in super offerta su Amazon: auricolari e cuffie iconiche ai prezzi più bassi del momento Batterie elettriche, Samsung SDI e Stellantis pronte ad avviare la produzione negli USA: ecco cosa uscirà dallo stabilimento StarPlus Energy

Batterie elettriche, Samsung SDI e Stellantis pronte ad avviare la produzione negli USA: ecco cosa uscirà dallo stabilimento StarPlus Energy Clivet presenta Fullness, la pompa di calore che fa tutto, senza unità esterna

Clivet presenta Fullness, la pompa di calore che fa tutto, senza unità esterna SpaceX lancerà 167 razzi spaziali Falcon 9 nel 2025, un nuovo record per la società di Elon Musk

SpaceX lancerà 167 razzi spaziali Falcon 9 nel 2025, un nuovo record per la società di Elon Musk Yakuza Kiwami 3 e Dark Ties protagonisti del nuovo Direct di Ryu Ga Gotoku del 22 dicembre

Yakuza Kiwami 3 e Dark Ties protagonisti del nuovo Direct di Ryu Ga Gotoku del 22 dicembre Privacy a rischio: ecco la VPN che registra tutto ciò che dici all’intelligenza artificiale

Privacy a rischio: ecco la VPN che registra tutto ciò che dici all’intelligenza artificiale SpaceX ha annunciato che un satellite Starlink ha avuto un problema in orbita, cause ancora da chiarire

SpaceX ha annunciato che un satellite Starlink ha avuto un problema in orbita, cause ancora da chiarire

102 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoLasciata a stock si raggiungono livelli di efficienza assurdi: 64 core in 200w

https://www.anandtech.com/show/1548...-3990x-review/2

280w non 200w

grazie

Si e no. Le GPU sono in evoluzione proprio per soddisfare le necessità di GP ( general purpose computing, da cui deriva il famoso acronimo GPGPU ).

Considera che le GPU iniziarono la loro vita come acceleratori grafici a pipeline fissa. Cioè non erano nemmeno programmabili! Niente shader.

Hanno implementato pipeline programmabili in tempi relativamente recenti.

Da qualche anno sono state aggiunte le istruzioni di branching ( i salti condizionati e non ). Senza la possibilità di saltare, è difficile realizzare programmi di ogni tipo.

La memoria è l'altra questione. Ma è meramente tecnica e di opportunità. Da un lato è vero che le latenze delle gddr sono più elevate rispetto alle ddr, ma è pur vero che la banda passante è molto molto maggiore. E parlando di programmi che fanno tanti calcoli, la banda serve.

Sempre sulla memoria, ad oggi le gpu s'interfacciano con le loro memorie, presenti sulla scheda grafica. La comunicazione con la ram avviene via DMA. E la gddr non si può espandere! Ovvio che è una questione di opportunità, Cioè nessuno ti costringe a creare una scheda grafica dove non si possa aggiungere memoria. Ma per i casi d'uso attuali sarebbe inutile.

E infine c'è la questione delle ISA. E' vero che storicamente le ISA delle GPU sono state create per manipolare numeri reali e vettori. Ma il deep learning sta rapidamente cambiando la situazione. Le GPU moderne supportano interi a 8 bit!!!

Altra questione è la memoria virtuale. Gli interrupt. Tutte cose che sono arrivate o stanno arrivando su gpu. Ma storicamente non c'erano.

E c'è ovviamente il software x86, che richiederebbe tempo e denaro portare. E a che pro? Le aziende non spendono soldi per niente.

E su quali architetture di gpu? Non c'è un'unica architettura lato gpu. E nemmeno delle virtual machine tipo quella di .NET o Java.

E infine i singoli core delle gpu sono più lenti di quelli delle cpu. Questo impatterebbe sui programmi single thread e la reattività.

come lo si raffredda una robo da 700watt?

700w è un'assurdità in overclock, però prendendo i 280w che fa da stock ho visto che sono molto più facili da raffreddare dei 140w del 3950x.

Non pensavo che la dimensione fisica della cpu incidesse così tanto sulla prestazione termica

è appunto quello il motivo per cui mi chiedevo quanto spazio ci sia per Cpu di questo tipo, visto che negli ultimi anni si è spinto molto sulle gpgpu

Occhio che quello è il consumo dell'intero sistema, non del solo processore.

Processori del genere sono overkill anche per pilotare flotte di GPU messe in gpcomputing

E' impossibile prevedere come andrà a finire.

Per ora il legacy c'è ed è forte. E riscrivere vagonate di software non credo sia fattibile. Se si parlasse dei Rome, parleremmo di hpc, e quindi scarsa presa del legacy. Ma trattandosi di workstation, non credo che il dominio delle cpu x86 verrà scalfito a breve-medio termine.

C'e un sacco di spazio per queste cpu.

Vero il fatto che le GPU sono scresciute allargando la quantità di istruzioni che possono eseguire proprio in termini di uso general purpose. Ma siamo ben lontani dal general purpose inteso per una CPU.

Sono due tipologie di core totalemte differenti, come totalemte differente è il set di istruzioni per cui sono pensate ed ottimizzate.

Quindi se una determinata operazione calza bene con il calcolo GPU bene. Vai come un treno.

Ma se questo non succede (e "non succede" spesso) allora la risorsa è solo la CPU. E quindi vedi bene che una cpu potente fa la differenza.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".