Arriva la GeForce RTX 4070 e AMD ricorda: la memoria sulle schede video conta

AMD ha pubblicato un post sul proprio blog in cui ricorda l'importanza di avere molta memoria a bordo delle schede video per giocare al meglio. Il tutto a poche ore dal debutto della GeForce RTX 4070 con 12 GB di VRAM.

di Manolo De Agostini pubblicata il 12 Aprile 2023, alle 09:01 nel canale Schede VideoGeForceRadeonAMDNVIDIA

In prossimità del debutto delle GeForce RTX 4070, la nuova scheda di NVIDIA sorella minore del modello RTX 4070 Ti, AMD sembra voler dare una stilettata alla rivale e, in particolare, alla quantità di VRAM a bordo della nuova soluzione. La GeForce RTX 4070 si presenta infatti con la stessa memoria del modello 4070 Ti, ovvero 12 GB di memoria GDDR6X, un quantitativo che secondo AMD non è adeguato, almeno in quella di fascia di prestazioni e prezzo.

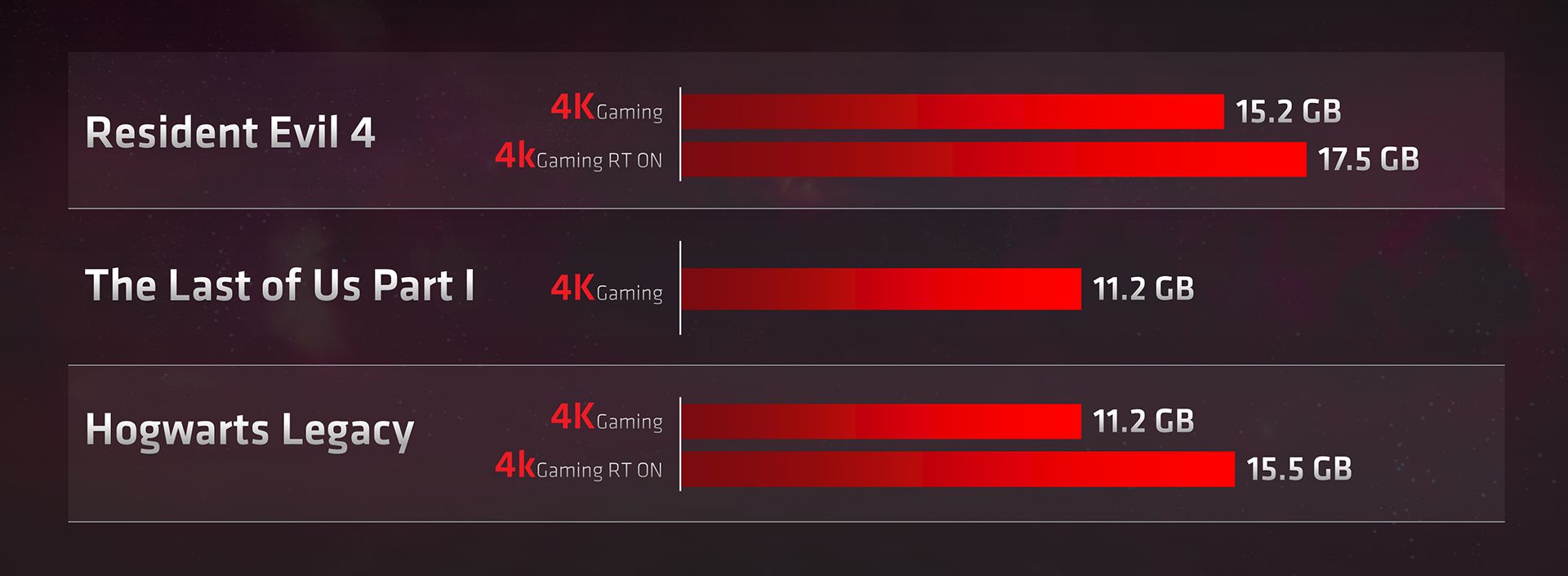

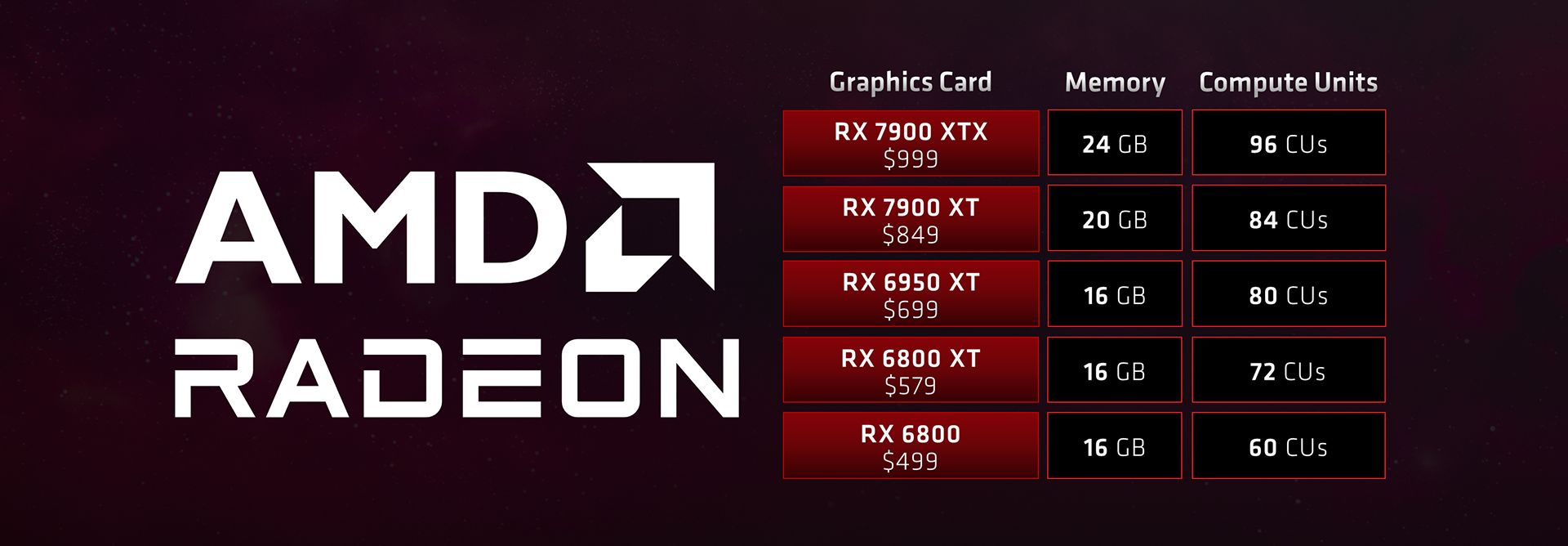

Con la GeForce RTX 4070 in predicato di partire da 599 dollari esentasse, AMD fa notare sul proprio blog come a quel livello le proprie soluzioni oggi sul mercato, come la Radeon RX 6800 XT, offrano almeno 16 GB. La società ha condiviso alcuni test, evidenziando come l'attivazione del ray tracing impatti in modo marcato sulla VRAM richiesta in 4K.

Ed è proprio qui che scatta il velato consiglio di AMD: acquistare una Radeon RX 6800 o 6800 XT per giocare in 4K, proprio in virtù della maggiore quantità di VRAM rispetto alla GeForce RTX 4070 (che non viene mai citata, va detto). AMD, infatti, suggerisce di comprare una scheda con 12 GB di memoria per giocare a 1440p, ovvero una Radeon RX 6700 XT / 6750 XT, soluzioni che però dovrebbero essere inferiori alla nuova proposta di NVIDIA.

La RTX 4070, stando alle indiscrezioni, dovrebbe avere prestazioni in linea con la GeForce RTX 3080, offrendo però pieno supporto al DLSS 3 e garantendo consumi ben inferiori. Il suo target, per quanto sia effettivamente quello del 1440p (senza DLSS 3), la vede però nell'intorno della 6800 / 6800 XT, quindi l'accento sulla VRAM di AMD fa sottintendere una frecciata nei confronti della nuova proposta di NVIDIA.

"Le software house stanno lanciando nuovi titoli che sfruttano appieno l'hardware moderno. Questo cambiamento nel settore migliora la tua esperienza con texture di qualità cinematografica, shader complessi e output a risoluzione più elevata, ma questi nuovi progressi richiedono un'ampia memoria video per garantire che i tuoi giochi funzionino senza intoppi. Se stai costruendo un sistema da gioco di prim'ordine per 1440p o 4K, vuoi che la tua scheda sia dotata di memoria video sufficiente per supportare non solo i titoli più recenti ma anche i giochi futuri".

"Senza un quantitativo di memoria video sufficiente, la tua esperienza potrebbe risentirne, con FPS più bassi nei momenti chiave, pop-in delle texture più frequenti o, nei casi peggiori, arresti anomali del gioco. Puoi sempre ottimizzare le impostazioni grafiche per trovare il giusto equilibrio prestazionale, ma con più memoria video è meno probabile che tu debba scendere a questi compromessi. Per una build da appassionato, consigliamo schede video con almeno 16 GB di memoria per giocare al massimo a 1440p e 4K. Per una grafica più di fascia media che punta al 1440p, AMD offre GPU da 12 GB che sono eccellenti per i display QHD", spiega la società.

Mettendo da parte la maliziosità nel vedere azioni di disturbo dove potrebbero non essercene, è bene ricordare che AMD storicamente dota le sue proposte con una grande quantità di memoria video, in genere più alta rispetto alle concorrenti di NVIDIA. Non è la prima volta che AMD sfrutta questo argomento contro l'avversaria, ma proprio lo scorso anno questa strategia le si rivoltò contro in occasione del lancio della sfortunata RX 6500 XT.

La rivoluzione dei dati in tempo reale è in arrivo. Un assaggio a Confluent Current 2025

La rivoluzione dei dati in tempo reale è in arrivo. Un assaggio a Confluent Current 2025 SAP Sapphire 2025: con Joule l'intelligenza artificiale guida app, dati e decisioni

SAP Sapphire 2025: con Joule l'intelligenza artificiale guida app, dati e decisioni Dalle radio a transistor ai Micro LED: il viaggio di Hisense da Qingdao al mondo intero

Dalle radio a transistor ai Micro LED: il viaggio di Hisense da Qingdao al mondo intero Una domenica bestiale Amazon: LG OLED, super portatile Lenovo, iPhone 16 Pro e Pro Max, robot e altri super sconti

Una domenica bestiale Amazon: LG OLED, super portatile Lenovo, iPhone 16 Pro e Pro Max, robot e altri super sconti DJI Mini 4 Pro Fly More Combo: drone leggero che non richiede il patentino oggi in offerta super su Amazon

DJI Mini 4 Pro Fly More Combo: drone leggero che non richiede il patentino oggi in offerta super su Amazon realme GT 7T: display da 6000 nit, potentissimo, 7000 mAh, quasi un top di gamma a metà del prezzo che ti aspetti

realme GT 7T: display da 6000 nit, potentissimo, 7000 mAh, quasi un top di gamma a metà del prezzo che ti aspetti Ancora qualche pezzo per il portatile Lenovo con Core i7, 40GB RAM e 1TB SSD: va sempre a ruba

Ancora qualche pezzo per il portatile Lenovo con Core i7, 40GB RAM e 1TB SSD: va sempre a ruba TV OLED LG Serie C4 2024: immagini da cinema e 4K a 144Hz in sconto su Amazon

TV OLED LG Serie C4 2024: immagini da cinema e 4K a 144Hz in sconto su Amazon Smartwatch Amazfit in sconto: Active 2 a 97€, ma ci sono offerte su tutta la gamma

Smartwatch Amazfit in sconto: Active 2 a 97€, ma ci sono offerte su tutta la gamma Router e ripetitori AVM FRITZ! da 30€ su Amazon: ecco tutte le offerte da non perdere

Router e ripetitori AVM FRITZ! da 30€ su Amazon: ecco tutte le offerte da non perdere Adulting 101: i corsi per imparare come era la vita fino a qualche anno fa

Adulting 101: i corsi per imparare come era la vita fino a qualche anno fa Blue Origin ha lanciato con successo la missione suborbitale NS-32 con New Shepard

Blue Origin ha lanciato con successo la missione suborbitale NS-32 con New Shepard L'amministrazione Trump ha ritirato la candidatura di Jared Isaacman come amministratore della NASA

L'amministrazione Trump ha ritirato la candidatura di Jared Isaacman come amministratore della NASA La NASA potrebbe chiudere le missioni OSIRIS-APEX, New Horizons e Juno cancellandone altre per risparmiare soldi

La NASA potrebbe chiudere le missioni OSIRIS-APEX, New Horizons e Juno cancellandone altre per risparmiare soldi Trump vieta anche la vendita di software per la progettazione di chip alle società cinesi

Trump vieta anche la vendita di software per la progettazione di chip alle società cinesi Le migliori offerte del weekend Amazon: portatili, robot, iPhone, Kindle ai prezzi più bassi di sempre

Le migliori offerte del weekend Amazon: portatili, robot, iPhone, Kindle ai prezzi più bassi di sempre Dreame L40 Ultra a 699€, prezzo shock: vale quasi quanto l’X40 Ultra da 999€ (ma costa 300€ in meno!)

Dreame L40 Ultra a 699€, prezzo shock: vale quasi quanto l’X40 Ultra da 999€ (ma costa 300€ in meno!)

29 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infole si rivoltò contro, non le si rivolse (rivolse è passato prossimo di rivolgere).

Però Nvidia può permetterselo,avendo il mercato delle schede video in mano lei.

Dico subito che non sono un fanboy ,ho una 5700 blower,ma non disdegno le soluzioni Intel o Nvidia, però mi pare che Nvidia la abbia fatto fuori dal vasino un po' troppo negli ultimi anni ...

Dlss3 ormai imprescindibile, vedremo passaggi in massa dalle 3090 alla 4070

Navi 32 XT avrà 16 giga, forse la liscia 12 ma è tutto da vedere

La memoria non la puoi aumentare una volta comprata la scheda ti tieni quella e sono €€€. Diversamente AMD deve ancora calare l'asso dell'FSR 3.0.

Certo rimane che il mondo reale e quel che si sente nei canali "d'informazione" specializzati sono due universi paralleli, l'utente medio gioca a dettagli medi in 1080p se va bene, ma loro nel 99% del tempo si concentrano su 4090, dettagli ultra e rtx overdrive

Pensate piuttosto a tirare fuori qualche GPU buona a prezzo decente, e a proporre qualche tecnologia interessante senza dover sempre inseguire Nvidia.

Spero tu abbia ragione

https://www.techpowerup.com/gpu-spe...x-7800-xt.c3839

Certo rimane che il mondo reale e quel che si sente nei canali "d'informazione" specializzati sono due universi paralleli, l'utente medio gioca a dettagli medi in 1080p se va bene, ma loro nel 99% del tempo si concentrano su 4090, dettagli ultra e rtx overdrive

L'utente medio gioca a 1080p dettagli medi perchè le schede video costano un rene... altrimenti sarebbero tutti almeno a 2k dettagli alti come dovrebbe essere nel 2023. Voglio ricordare che la 1080Ti usci a 699, questa 4070 a 599 la 4070Ti a 799... la 1070Ti a 399 e già giocavamo a 2k tutto maxato e avevamo già 8Gb di ram, oggi siamo all'assurdo che una 4070 esce a 200 dollari in più di una 1070Ti e rimani sempre a 2k con la stessa quantita di vram, dopo 6 anni. Se facessimo un discorso al netto della complessità dei videogiochi il miglioramento tra 1070Ti e 4070Ti probabilmente non sarebbe troppo distante da un 10% con un aumento di prezzo del 100%

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".