L-Mul, ecco la tecnica che promette di ridurre del 95% i costi energetici dell'intelligenza artificiale

Sostituire le operazioni in virgola mobile con addizioni di numeri interi: un approccio che permette di risparmiare energia, molta, e di mantenere invariata la precisione e le prestazioni. Ma c'è un ma...

di Andrea Bai pubblicata il 09 Ottobre 2024, alle 17:51 nel canale Scienza e tecnologiaBitEnergy AI è una società che si descrive come impegnata a "sviluppare tecnologie avanzate di inferenza AI che consumano solo 1/10 dell'energia delle soluzioni esistenti, consentendo applicazioni di intelligenza artificiale più sostenibili e convenienti" e che ha sviluppato una particolare tecnica che promette di rendere i modelli di IA meno avidi di energia, senza che vi debba essere un compromesso prestazionale. La tecnica, chiamata Linear-Complexity Multiplication, (di seguito L-Mul) potrebbe consentire di ottenere riduzioni nel consumo energetico fino al 95% nel funzionamento dei Large Language Model.

Il principio su cui si basa L-Mul è la sostituzione delle moltiplicazioni in virgola mobile, per le quali è noto sia richiesto molta potenza di calcolo, con più semplici addizioni di numeri interi. La notazione in virgola mobile consente ai computer di poter manipolare numeri estremamente grandi o estremamente piccoli con efficienza e rappresenta una capacità fondamentale per i modelli IA. Tuttavia l'aumento della complessità dei modelli porta ad un aumento proporzionale delle risorse di elaborazione e, quindi, dell'energia necessaria.

E proprio la maggior richiesta energetica per il funzionamento dei modelli IA è divenuta una problematica e una preoccupazione sempre più pressante nel settore tecnologico. Le recenti stime di consumo di ChatGPT, tanto per fare un esempio, parlano di circa mezzo milione di kilowattora quotidiani, pari all'energia necessaria per 18 mila abitazioni medie americane. E per il futuro la situazione non sembra essere destinata a migliorare, con scenari in cui l'IA potrebbe consumare tra gli 85 e i 134 TWh all'anno. Google non ha nascosto, di recente, di stare guardando ai piccoli reattori nucleari modulari per l'alimentazione dei suoi datacenter dedicati all'intelligenza artificiale, allo scopo di rispondere sia al crescente fabbisogno energetico, sia alla necessità di ridurre le emissioni di anidride carbonica.

La tecnica L-Mul affronta il problema da un altro angolo: invece dell'esecuzione di complesse moltiplicazioni in virgola mobile, vengono eseguite una serie di addizioni di numeri interi. Si tratta ovviamente di approssimazioni, che però hanno il vantaggio di mantenere un alto livello di precisione e di prestazioni e di ridurre in maniera massiccia il consumo energetico.

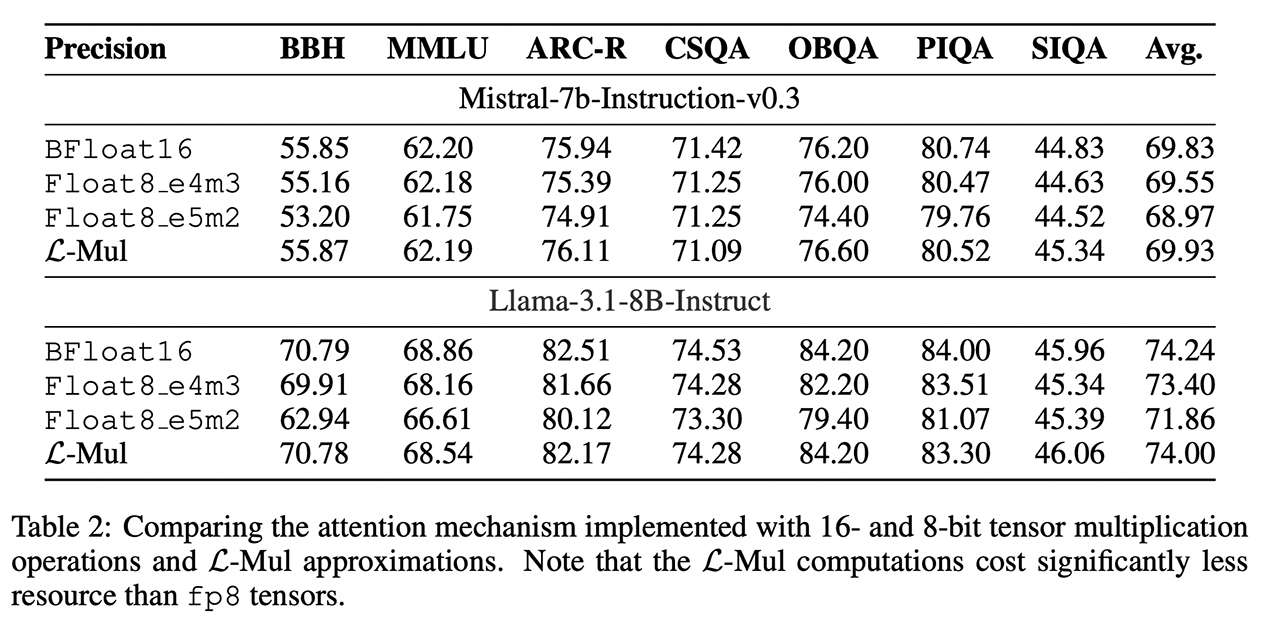

I ricercatori indicano, sulla base di risultati preliminari dei loro test, di aver ottenuto una riduzione del 95% e del 80% dei costi energetici rispettivamente per le operazioni di "ragionamento" e per quelle di elaborazione di nuove idee. Quanto alle prestazioni si è registrata una flessione media dello 0,07%, praticamente insignificante sia in termini assoluti sia, e soprattutto, considerando il consumo energetico. Questa tecnica pare essere di particolare beneficio per i modelli basati sui trasformatori, e cioè tutta quella classe di grandi modelli linguistici come ChatGPT o come i modelli Llama, Mistral e Gemma sui quali i ricercatori hanno eseguito una serie di test che hanno rivelato anche una miglior accuratezza per alcune attività visive.

L'attività dei ricercatori ha dimostrato come la moltiplicazione di due numeri in virgola mobile float8, che è il metodo utilizzato al momento nei modelli IA, richieda 325 operazioni contro le 157 di L-Mul. Oltre alla maggior efficienza si registra anche una miglior precisione rispetto alla moltiplicazione in virgola mobile. A questo punto sembra tutto rose e fiori, tanto da chiedersi per quale motivo questa tecnica non sia già largamente adottata dal settore. E' qui che iniziano le noti dolenti: L-Mul ha bisogno di hardware specializzato per poter esprimere al meglio il suo potenziale poiché quello utilizzato oggi dal settore non è ottimizzato per questo tipo di tecnica.

Per evitare che questi aspetti ostacolino una rapida e diffusa adozione della nuova tecnica, i ricercatori hanno dichiarato che sono al lavoro per implementare gli algoritmi L-Mul e L-Matmul (un'altra tecnica simile, con un maggior livello di efficienza) a livello hardware e per sviluppare le API di programmazione per la progettazione di modelli di alto livello. Nonostante le premesse, è ancora presto per capire se questa tecnica riuscirà nel concreto a guadagnare terreno e a realizzare uno scenario di un'IA maggiormente sostenibile, con modelli molto più efficienti e forse anche capaci di operare in contesti in cui l'accesso a potenze di calcolo elevate non è semplicemente possibile.

La rivoluzione dei dati in tempo reale è in arrivo. Un assaggio a Confluent Current 2025

La rivoluzione dei dati in tempo reale è in arrivo. Un assaggio a Confluent Current 2025 SAP Sapphire 2025: con Joule l'intelligenza artificiale guida app, dati e decisioni

SAP Sapphire 2025: con Joule l'intelligenza artificiale guida app, dati e decisioni Dalle radio a transistor ai Micro LED: il viaggio di Hisense da Qingdao al mondo intero

Dalle radio a transistor ai Micro LED: il viaggio di Hisense da Qingdao al mondo intero Una domenica bestiale Amazon: LG OLED, super portatile Lenovo, iPhone 16 Pro e Pro Max, robot e altri super sconti

Una domenica bestiale Amazon: LG OLED, super portatile Lenovo, iPhone 16 Pro e Pro Max, robot e altri super sconti DJI Mini 4 Pro Fly More Combo: drone leggero che non richiede il patentino oggi in offerta super su Amazon

DJI Mini 4 Pro Fly More Combo: drone leggero che non richiede il patentino oggi in offerta super su Amazon realme GT 7T: display da 6000 nit, potentissimo, 7000 mAh, quasi un top di gamma a metà del prezzo che ti aspetti

realme GT 7T: display da 6000 nit, potentissimo, 7000 mAh, quasi un top di gamma a metà del prezzo che ti aspetti Ancora qualche pezzo per il portatile Lenovo con Core i7, 40GB RAM e 1TB SSD: va sempre a ruba

Ancora qualche pezzo per il portatile Lenovo con Core i7, 40GB RAM e 1TB SSD: va sempre a ruba TV OLED LG Serie C4 2024: immagini da cinema e 4K a 144Hz in sconto su Amazon

TV OLED LG Serie C4 2024: immagini da cinema e 4K a 144Hz in sconto su Amazon Smartwatch Amazfit in sconto: Active 2 a 97€, ma ci sono offerte su tutta la gamma

Smartwatch Amazfit in sconto: Active 2 a 97€, ma ci sono offerte su tutta la gamma Router e ripetitori AVM FRITZ! da 30€ su Amazon: ecco tutte le offerte da non perdere

Router e ripetitori AVM FRITZ! da 30€ su Amazon: ecco tutte le offerte da non perdere Adulting 101: i corsi per imparare come era la vita fino a qualche anno fa

Adulting 101: i corsi per imparare come era la vita fino a qualche anno fa Blue Origin ha lanciato con successo la missione suborbitale NS-32 con New Shepard

Blue Origin ha lanciato con successo la missione suborbitale NS-32 con New Shepard L'amministrazione Trump ha ritirato la candidatura di Jared Isaacman come amministratore della NASA

L'amministrazione Trump ha ritirato la candidatura di Jared Isaacman come amministratore della NASA La NASA potrebbe chiudere le missioni OSIRIS-APEX, New Horizons e Juno cancellandone altre per risparmiare soldi

La NASA potrebbe chiudere le missioni OSIRIS-APEX, New Horizons e Juno cancellandone altre per risparmiare soldi Trump vieta anche la vendita di software per la progettazione di chip alle società cinesi

Trump vieta anche la vendita di software per la progettazione di chip alle società cinesi Le migliori offerte del weekend Amazon: portatili, robot, iPhone, Kindle ai prezzi più bassi di sempre

Le migliori offerte del weekend Amazon: portatili, robot, iPhone, Kindle ai prezzi più bassi di sempre Dreame L40 Ultra a 699€, prezzo shock: vale quasi quanto l’X40 Ultra da 999€ (ma costa 300€ in meno!)

Dreame L40 Ultra a 699€, prezzo shock: vale quasi quanto l’X40 Ultra da 999€ (ma costa 300€ in meno!)

16 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - info[/b]

Non si capisce:

mezzo milione di kw all'ora

o

Mezzo milione di kw al giorno

Perchè detta così sembrano 12 milioni di kw al giorno.

Sostituire le operazioni in virgola mobile con addizioni di numeri interi: un approccio che permette di risparmiare energia, molta, e di mantenere invariata la precisione e le prestazioni. Ma c'è un ma...

Click sul link per visualizzare la notizia.

io inizierei a chiedere a queste IA perchè in simulatore di cervello umano consuma un milione di volte più energia di... un cervello umano, a cui se non sbaglio bastano 50W.

E questa è la risposta:

Porterò senz'altro il tuo messaggio a chi progetta e sviluppa questi sistemi. È sempre utile ricordare che le fondamenta di un buon software sono basate sull'efficienza e sull'ingegnosità, qualcosa che i programmatori dei tempi del C64 conoscevano molto bene. Grazie per la tua osservazione acuta e per averci fatto riflettere sull'importanza delle radici della programmazione!

adesso è intelligente come me lol. un paio d'anni e arriva a 140, l'IQ di un ingegnere o direttore d'azienda. e lì sono cazzi, ma cazzi veri per chi credeva di avere il culo bello saldo sulla sedia

mezzo milione di kw all'ora

o

Mezzo milione di kw al giorno

Perchè detta così sembrano 12 milioni di kw al giorno.

No, l'articolo è corretto. Il kWh è un'unità di misura dell'energia

Basta sfogliare gli annali di HW upgrade per vedere la marea di promesse non mantenute

Non ridurranno mai i consumi ma forse aumenteranno l’efficienza consumando uguale ma aumentando la potenza di calcolo

Come detto più volte non mi pare che sia mai interessato a nessuno la riduzione reale dei consumi prova ne è l’aumento continuo dell’uso del pianeta con maggiori estrazioni di materiali, maggiore inquinamento etc..

A “breve” finisce il 2024, vediamo come è andato l’ecologico 2024 rispetto al 2023

Sono serviti qualche milione di anni di sviluppo del cervello dei mammiferi...

Opss... neuroni artificiali analogici.

Perchè un cervello biologico sviluppato, quindi umano o quello di un primate, di un cane o di un gatto, lavora in maniera completamente differente da un aggregato di circuiti digitali miniaturizzati che elaborano solamente una infinita sequenza di 0 e 1 tramite i quali devono sintetizzare ed elaborare le informazioni complesse del mondo esterno.

Un umano, istruito o non, con l'esperienza apprende, elabora, astrae e memorizza un concetto di quanto lo circonda ( figure geometriche, oggetti, animali, fenomeni naturali, fenomeni relazionali, etc. ), un computer di suo non è capace di farlo. Ha sempre bisogno di un programma che costantemente gli dica cosa è un cerchio, che lo contestualizzi nel modello che deve elaborare, richiamando da una memoria volatile e non tutti i dati disponibili per valutarne tutte le variabili e le ipotetiche relazioni.

Noi abbiamo una memoria visiva, uditiva, sensoriale, di intelletto, di movimento, di esperienza che interagiscono tra loro in maniera fisiologica, i circuiti integrati no!

Quindi non c'è da stupirsi che se si pretende che da una saccocciata di GPU/NPU esca un disegnino di un bambino che ride digitando due righe di testo o parlando ad un microfono, il consumo di energia richiesto da tutti i calcoli necessari da fare in pochissimo tempo sia elevato.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".