IDF Fall 2006 day 3, flash memory e HPC

Nel corso dell'ultima giornata dell'Intel Developer Forum di San Francisco vengono trattati alcuni argomenti di carattere tecnico, tra cui le tecniche di programmazione parallela per sfruttare Multi-core e Multithreading. In esposizione alcuni "cimeli" che hanno segnato la storia del computer portatile

di Alessandro Bordin , Andrea Bai pubblicato il 03 Ottobre 2006 nel canale SistemiIntel

HPC, High Processing Computing

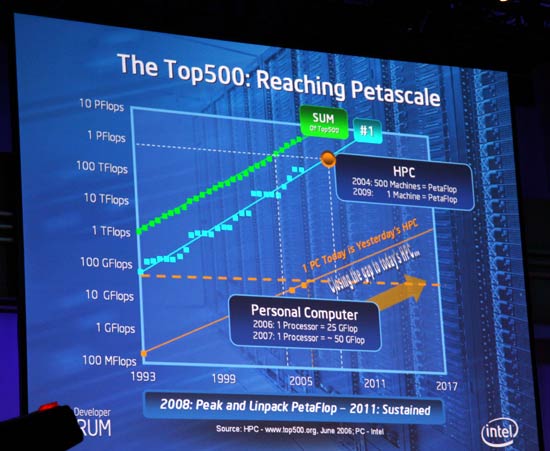

L'ultima giornata prosegue con uno sguardo al mondo dell'HPC, ovvero High Performance Computing, mettendo in mostra i risultati raggiunti e quelli che ci si attende dal futuro. Un processore quad-core del giorno d'oggi può arrivare fino a 25 Gigaflop, ove con tale unità di misura si indica il numero di operazioni in virgola mobile eseguite in un secondo dalla CPU. Tale valore era raggiunto dagli High Performancing PC di una decina di anni fa, a riprova di quali balzi da gigante si siano fatti nel campo dei processori nell'arco di questo tempo.

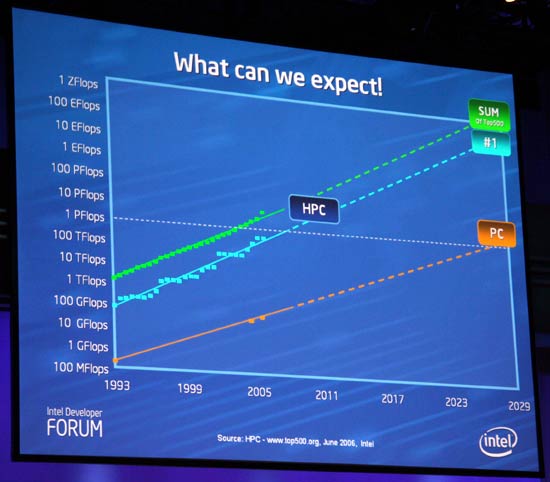

Allo stato attuale la potenza di calcolo raggiunta dagli HPC si aggira intorno al Petaflop (1000 Teraflop), un valore che sarà alla portata dei PC desktop verosimilmente intorno al 2030. In quell'anno in ogni caso i grandi Datacenter avranno a disposizione una tecnologia in grado di garantire una potenza di calcolo intorno allo Zettaflop, ovvero 1000 Esaflop, cioè ben un milione di Petaflop. Queste ovviamente le previsioni, che devono in ogni modo fare i conti con problemi non da poco che andremo a puntutalizzare.

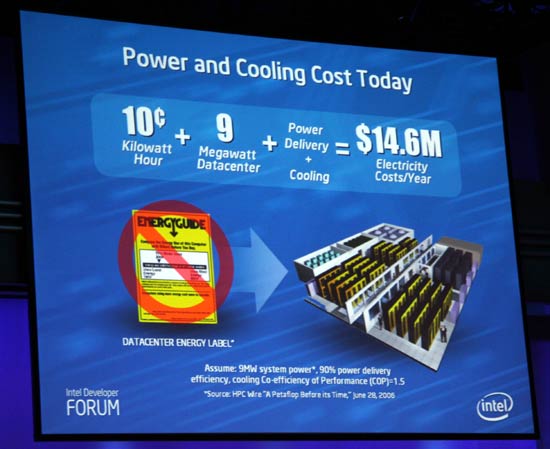

Vi sono infatti due problemi che si frappongono fra le alte prestazioni odierne e quelle future, che prendono il nome di consumo energetico e raffreddamento. Preso in considerazione infatti il prezzo del kilowatt all'ora negli Stati Uniti, che si assesta a 10 centesimi di dollaro, ed appurato che un Datacenter ad elevate prestazioni arriva a consumare fino a 9 Megawatt all'ora (9000 kilowatt all'ora quindi), appare chiaro come in un anno si possa arrivare ad un prezzo per il solo funzionamento delle unità elaborative coinvolte di quasi 8 milioni di dollari all'anno.

Appurato che altrettanto denaro finisce per essere speso per condizionatori e sistemi di raffreddamento adeguati, appare fin troppo chiaro come la creazione di un Datacenter HPC sia ormai divenuto un impegno economico sostenibile solo da cordate di aziende, viste le cifre stratosferiche coinvolte. Ecco quindi l'importanza di ricercare sistemi sempre più potenti ma contemporaneamente meno esosi in termini energetici, ovvero seguendo il trend attuale dei processori più recenti.

Sono in molti a chiedersi a chi serva tutta questa potenza di calcolo, decisamente spropositata rispetto a quella messa a disposizione dai comuni PC domestici. Le applicazioni sono molteplici, che vanno dalla simulazione di modelli matematici per studi aeronautici, biologia molecolare, turbolenze, strutture chimiche. Molte delle scoperte che hanno permesso dei progressi nel nostro stile di vita sono passate attraverso l'intepretazione di questi dati. Si tratta dunque di Datacenter praticamente indispensabili per l'evoluzione della ricerca.

Test ride con Gowow Ori: elettrico e off-road vanno incredibilmente d'accordo

Test ride con Gowow Ori: elettrico e off-road vanno incredibilmente d'accordo Recensione OnePlus 15: potenza da vendere e batteria enorme dentro un nuovo design

Recensione OnePlus 15: potenza da vendere e batteria enorme dentro un nuovo design  AMD Ryzen 5 7500X3D: la nuova CPU da gaming con 3D V-Cache per la fascia media

AMD Ryzen 5 7500X3D: la nuova CPU da gaming con 3D V-Cache per la fascia media Etica e software libero protagonisti a SFSCON 2025

Etica e software libero protagonisti a SFSCON 2025 Il reattore che ricarica le batterie scartate e produce nuovo litio: la rivoluzione di Rice University

Il reattore che ricarica le batterie scartate e produce nuovo litio: la rivoluzione di Rice University AMD FSR Redstone: la nuova tecnologia basata sulle reti neurali esordisce su Call of Duty: Black Ops 7

AMD FSR Redstone: la nuova tecnologia basata sulle reti neurali esordisce su Call of Duty: Black Ops 7 Meta Quest 3S a un prezzo senza precedenti per le offerte Black Friday: realtà mista e bundle esclusivo a soli 249,99€

Meta Quest 3S a un prezzo senza precedenti per le offerte Black Friday: realtà mista e bundle esclusivo a soli 249,99€ Rischio per gli SSD? I driver chipset AMD scrivono continuamente sul drive, ma non è chiaro il perché

Rischio per gli SSD? I driver chipset AMD scrivono continuamente sul drive, ma non è chiaro il perché Quanto sono 'woke' le intelligenze artificiali? Anthropic ha adesso uno strumento per misurarlo

Quanto sono 'woke' le intelligenze artificiali? Anthropic ha adesso uno strumento per misurarlo Rockstar rilancia Red Dead Redemption su PS5, Series X, Switch 2 e smartphone

Rockstar rilancia Red Dead Redemption su PS5, Series X, Switch 2 e smartphone Blue Origin centra l'obiettivo: New Glenn atterra e porta ESCAPADE verso Marte

Blue Origin centra l'obiettivo: New Glenn atterra e porta ESCAPADE verso Marte Regali di Natale spendendo poco con il Black Friday: tante idee mai sopra i 100€

Regali di Natale spendendo poco con il Black Friday: tante idee mai sopra i 100€ Windows 11/10: Microsoft chiude per sempre il metodo di attivazione KMS38 offline

Windows 11/10: Microsoft chiude per sempre il metodo di attivazione KMS38 offline  Speciale CMF Nothing: smartphone, smartwatch e cuffie in offerta, design unico e tecnologia premium a prezzi mai visti

Speciale CMF Nothing: smartphone, smartwatch e cuffie in offerta, design unico e tecnologia premium a prezzi mai visti Cooler Master presenta MasterFrame 400 Mesh: compatto, modulare e super ventilato

Cooler Master presenta MasterFrame 400 Mesh: compatto, modulare e super ventilato ChatGPT lancia le chat di gruppo collaborative con l'IA integrata: come funzionano

ChatGPT lancia le chat di gruppo collaborative con l'IA integrata: come funzionano Galaxy S25 Ultra a un prezzo pazzesco: il modello da 512 GB crolla a 899€, occasione imperdibile

Galaxy S25 Ultra a un prezzo pazzesco: il modello da 512 GB crolla a 899€, occasione imperdibile