Intel Xeon Scalable: tra terza generazione e Sapphire Rapids

La gamma di processori Intel Xeon è sempre più ricca, con ben 57 versioni che compongono la terza generazione della piattaforma Xeon Scalable. Tra tecnologia produttiva a 10 nanometri e proposte per sistemi server sino a 8 socket, scopriamo quale sia l'approccio Intel per rivaleggiare con i processori AMD EPYC nel mercato dei datacenter

di Manolo De Agostini , Paolo Corsini pubblicato il 26 Ottobre 2021 nel canale ProcessoriIntelXeon

Il marchio Xeon ha da sempre contraddistinto la famiglia dei processori Intel destinata agli ambiti di utilizzo più gravosi, quelli nei datacenter. Parliamo di sistemi che devono coniugare la necessità di elaborare il più rapidamente possibile una elevata mole di dati, eseguendo questo costantemente nel tempo così da garantire le indispensabili condizioni di stabilità di funzionamento.

L'approccio di Intel rivolto al mondo dei datacenter non è però basato unicamente sui processori. Questi sono il cuore di un ecosistema più ampio, che vede memoria e soluzioni di storage affiancate quali elementi fondamentali per assicurare quella velocità di elaborazione e gestione dei dati che è imprescindibile in ambito datacenter. Troviamo quindi accanto a Xeon anche il brand Optane, adottato tanto per le soluzioni di storage con Optane SSD quanto per la memoria di sistema con Optane Persistent Memory.

La gamma di processori Intel Xeon Scalable è giunta alla terza generazione, con proposte che spaziano dai server rack a singolo socket sino alle configurazioni server più complesse dotate di un massimo di 8 socket al proprio interno. Il mercato dei datacenter si è evoluto nel corso degli ultimi anni sempre più nella direzione di utilizzare sistemi a singolo e due socket per la maggior parte degli utilizzi: la disponibilità di un numero di core sempre più elevato, unita all'utilizzo in cluster di più server paralleli, non richiede per molti scenari di utilizzo tipici di adottare server monolitici nei quali siano integrati più di 2 socket. Tali sistemi continuano ad essere sviluppati ma sono sempre più rivolti ad una nicchia molto specialistica del mercato.

Xeon, un futuro di intelligenza artificiale e grandi cambiamenti

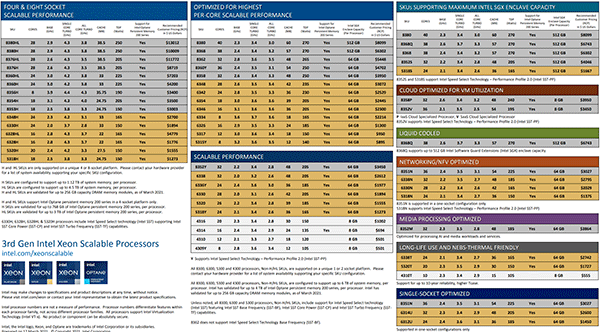

I processori Intel Xeon Scalable di terza generazione fanno da cappello a due architetture, altrettanti processi produttivi e si suddividono in quattro famiglie che rispondono ai nomi Bronze, Silver, Gold e Platinum. I nomi permettono di meglio segmentare l'offerta, aiutando l'utente a scegliere processori con caratteristiche tecniche progressivamnte sempre più complesse ed elaborate a seconda delle proprie necessità.

Due architetture e due processi produttivi perché Intel ha dapprima introdotto le soluzioni Cooper Lake realizzate con tecnologia a 14 nanometri e successivamente le CPU Ice Lake a 10 nanometri. Le proposte Cooper Lake sono compatibili con la piattaforma Cedar Island per server a 4-8 socket, mentre quelle Ice Lake si installano sulla piattaforma Whitley e si rivolgono ai sistemi con 1-2 socket.

Xeon Scalable di terza generazione, intelligenza artificiale al potere

Intel ha capito da tempo che l'intelligenza artificiale sarà il motore trainante nei prossimi decenni nel settore del calcolo e per questo ha deciso non solo di creare prodotti specializzati per questo tipo di elaborazioni, ma anche di adattare i propri progetti alla gestione di questo tipo di operazioni direttamente nei microprocessori.

Secondo una stima di IDC, nel 2025 un quarto dei dati sarà creato in tempo reale, con la necessità di un'analisi rapida ed efficace: inserire tutto ciò che serve a farlo direttamente sul processore conferisce a Intel un vantaggio competitivo.

I processori Xeon Scalable di terza generazione compiono un ulteriore passo in tale direzione: sotto il nome commerciale Deep Learning Boost (DL Boost), Intel raccoglie un ampio insieme di tecnologie dedicate proprio ad accelerare le operazioni alla base dell'intelligenza artificiale.

Cooper Lake per piattaforme a quattro e otto socket

Le CPU "Cooper Lake" sono state le prime a integrare il supporto al formato in virgola mobile bfloat16, pensato per facilitare l'inferenza e l'allenamento di reti neurali destinate all'intelligenza artificiale direttamente sulle CPU. Tra le applicazioni che beneficiano di bfloat16 troviamo la classificazione delle immagini, il riconoscimento vocale e l'analisi di dati complessi, solo per fare alcuni esempi.

Il formato bloaf16 si affianca alle Vector Neural Network Instructions (VNNI) e usa metà dei bit dell'attuale formato FP32 ma raggiunge un'accuratezza comparabile, con cambiamenti nulli o minimi al software, velocizzando così l'addestramento di modelli di IA e inferenza usando la CPU.

Come già scritto, gli Intel Xeon Scalable di terza generazione sono destinati a piattaforme server con quattro od otto socket, e contemplano una serie di modelli a 14 nanometri che vanno dai 16 core / 32 thread fino ai 28 core / 56 thread con TDP da 150 a 250 watt.

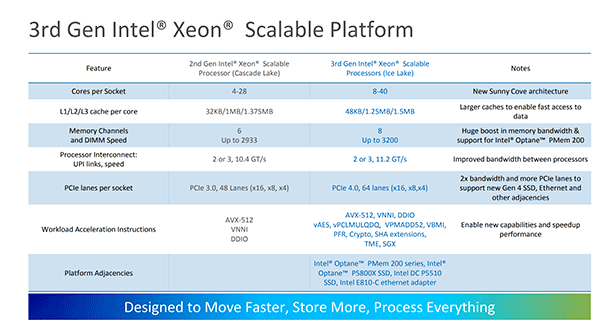

Ogni processore offre fino a 48 linee PCI Express 3.0 e sei canali di memoria con supporto DDR4 a 3200 MT/s nel caso di una DIMM per canale o 2933 MT/s con l'installazione di 2 DIMM per canale. Complessivamente ogni socket può supportare fino a 256 GB di memoria DDR4. Poiché la piattaforma supporta anche Optane Persistent Memory (OPmem), ci sono modelli di CPU che possono interfacciarsi con un massimo di 4,5 TB di memoria: ogni socket supporta un modulo OPmem per canale, per un massimo di 3 TB di capacità, a cui si può aggiungere 1,5 TB di memoria DDR4. Per la comunicazione tra le CPU, Intel ha dotato i chip Cooper Lake di sei collegamenti UPI (Ultra Path Interconnect).

Ice Lake per server a singolo o doppio socket

A presidiare il mercato dei server a singolo e doppio socket Intel ha posizionato la sua prima CPU server a 10 nanometri, nome in codice Ice Lake. Basata sui core Sunny Cove, l'offerta contempla CPU da 8 fino a 40 core, quindi più core della precedente versione e anche più efficienti: l'architettura Sunny Cove è in grado di aumentare le prestazioni del 20%, non solo per le migliorie apportate da Intel ma anche per la cache più capienti che permettono alle unità di elaborazione di avere i dati a portata di mano.

Abbiamo incontrato l'architettura Sunny Cove già in precedenza nei processori Core di undicesima generazione per sistemi desktop, ma in questa implementazione vi sono alcune significative differenze legate all'ambito di utilizzo di riferimento dei processori Xeon. In generale segnaliamo cache di secondo livello più ampia, migliorie nel front-end, buffer più ampi e un approccio in termini di design del core che tiene conto dello scenario di utilizzo tipico delle cpu Xeon nei datacenter.

Intel ha inoltre implementato un nuovo controller di memoria che passa da 6 a 8 canali, incrementando la bandwidth a disposizione del sistema, unitamente ad affinamenti che ne migliorano l'efficienza complessiva. Cambia anche il tipo di memoria supportata, DDR4-3200, mentre il controller PCI Express integrato è in versione 4.0 con un totale di 64 linee contro le 48 di tipo PCIe 3.0 delle CPU Xeon di precedente generazione. Il collegamento tra i due socket avviene attraverso tecnologia Ultra Path Interconnect (UPI), la stessa adottata con la precedente generazione di processori Intel Xeon ma qui con velocità di trasmissione incrementata da 10,4GT/s a 11,2GT/s.

Le nuove CPU Xeon Scalable Ice Lake offrono inoltre un supporto più esteso per quanto le istruzioni legate ai carichi di IA e crittografia, e alzano la posta in termini di sicurezza con Intel SGX - Intel Software Guard Extension - che offre un'enclave sicura fino a 512 GB di capacità per processore (o 1 TB in server 2P) per la gestione sicura di dati altamente sensibili. Anche l'interconnessione UPI che collega due CPU è stata migliorata, per uno scambio dati più rapido.

Il TDP varia a seconda delle frequenze, della configurazione e del numero di core, ma il limite massimo indicato da Intel è pari a 270W. Nelle tabelle sono riportate tutte le differenti versioni di processore Intel Xeon Scalable di terza generazione, divise in funzione degli ambiti di utilizzo di riferimento.

Tutto questo ha permesso di ottenere significativi incrementi nelle prestazioni complessive passando dal precedente top di gamma Xeon Platinum 8280 all'attuale Xeon Platinum 8380. In parte queste variazioni sono legate alle migliorie architetturali, in parte al maggior numero di core a disposizione (40 vs 28), pur se con una frequenza di clock Turbo massima che in virtù del maggior numero di core si riduce (3,4GHz contro 4GHz) pur con un TDP che passa dai precedenti 205 Watt agli attuali 270 Watt.

Una piattaforma rack Ice Lake

Un sistema server basato su processori Xeon Scalable di terza generazione è configurato in modo speculare alla piattaforma reference sviluppata da Intel: questo server non è disponibile in vendita ma può rappresentare un valido riferimento per i partner produttori di server per la configurazione dei propri sistemi.

Caratterizzato da un form factor rack a due unità, questo sistema ospita due processori Xeon, ciascuno abbinato a 8 slot per moduli memoria DDR4, montati su scheda madre Intel Coyote Pass. Il design interno prevede un sistema di raffreddamento che aspira aria dalla parte frontale, nella quale si trovano i cassettini per le unità di storage, spingendola lungo tutto l'interno dello chassis così che possa entrare a diretto contatto con i dissipatori di calore del processore. Il flusso d'aria viene in questo modo direzionato verso la parte posteriore dello chassis, così che venga espulso all'esterno nell'armadio.

Non manca la possibilità di installare schede PCI Express, che vanno ad espandere la serie di funzionalità integrate nella scheda madre; pensiamo ad esempio a schede video utilizzate per calcoli paralleli non grafici che affiancano nelle elaborazioni i processori Xeon. L'alimentazione, infine, è ovviamente di tipo ridondato con due unità hot plug montate sui due lati così che l'eventuale malfunzionamento.

memoria Intel Optane sopra; memoria DDR4 sotto

Un sistema di questo tipo è pensato per abbinare ai processori Xeon un elevato quantitativo di memoria di sistema che può essere tanto di tipo DDR4 standard come quella Optane Memory; nel primo caso sono presenti moduli da 32GB ciascuno, che diventano da 128GB nel caso delle soluzioni Optane Memory.

Sapphire Rapids, il futuro dei server secondo Intel

Il futuro prossimo di Intel nel settore server si chiama Sapphire Rapids. Ancora non conosciamo tutti i dettagli della prossima generazione di Xeon Scalable, ma l'azienda ci ha spiegato che si tratterà di un progetto totalmente nuovo in tutti i suoi aspetti.

Per iniziare il processo produttivo chiamato Intel 7 (ex 10nm Enhanced SuperFin), più maturo rispetto a quello usato per Ice Lake. In seconda battuta, Sapphire Rapids si basa su un'architettura totalmente inedita basata su un core chiamato Golden Cove: non solo dobbiamo attenderci un maggior numero di core, ma questi saranno in grado di restituire maggiori prestazioni anche grazie a diversi engine per l'accelerazione di funzioni specifiche con l'IA.

Sapphire Rapids metterà a disposizione dei carichi di lavoro una cache LLC condivisa di poco inferiore ai 100 MB e quattro controller di memoria per gestire otto canali di memoria DDR5. Il supporto all'ultimo standard di memoria, introdotto per la prima volta su una CPU server, si affianca alla prossima generazione di Optane e alla connettività PCI Express 5.0, CLX 1.1 e UPI 2.0. Vi saranno inoltre processori Sapphire Rapids con memoria HBM per carichi che richiedono una bandwidth elevata. Insomma, un'offerta vasta e completa che vuole adattarsi alle necessità di ealborazione specifiche dei clienti.

Ancora più interessante è come Intel darà forma alle future CPU Xeon: ci troveremo davanti a un SoC modulare pensato per garantire scaling tra socket, nodi e datacenter. L'elemento fondamentale di questa rivoluzione nel design dei processori server Intel prende il nome di EMIB, sigla di Embedded Multi-Die Interconnect Bridge.

Visto da fuori EMIB non è altro che un pezzettino di silicio simile a un granello di riso, ma è un componente fondamentale che, posto in un substrato, fa da ponte favorendo il passaggio avanti e indietro di grandi quantità di dati a velocità di diversi gigabyte al secondo. EMIB serve quindi a collegare orizzontalmente due chiplet posti a breve distanza e creare così un processore composto da più moduli (tile) su un unico package.

Intel assicura che ogni thread in Sapphire Rapids ha pieno accesso a tutte le risorse presenti su tutte le tile, anche la cache, la memoria e l'I/O, garantendo così una latenza sempre ridotta e una bandwidth elevata sull'intero SoC. In termini di engine di accelerazione troviamo Intel Accelerator Interfacing Architecture (AIA), Intel Advanced Matrix Extensions (AMX) e Data Streaming Accelerator (DSA), insieme a nuove istruzioni rilevanti per il mondo datacenter.

AIA supporta comunicazione, sincronizzazione e signaling efficiente verso acceleratori e dispositivi, mentre AMX è un nuovo engine che a detta di Intel garantisce un deciso aumento prestazionale nell'accelerazione di carichi al centro degli algoritmi di deep learning. Può fornire infatti capacità di calcolo maggiori con 2K INT8 e 1K BFP16 operazioni per ciclo.

Nei test interni sui sample di pre-produzione Sapphire Rapids si è dimostrato oltre 7 volte più veloce con Intel AMX rispetto alle istruzioni Intel AVX-512 VNNI, restituendo così grandi miglioramenti prestazionali tra i carichi di IA sia per l'addestramento che l'inferenza.

DSA serve invece a scaricare le più comuni attività di migrazione dei dati che causano overhead nelle implementazioni su scala di data center. Intel DSA migliora l'elaborazione di queste attività per garantire prestazioni complessivamente migliori e può spostare i dati tra CPU, memoria e cache, nonché tutta la memoria collegata, l'archiviazione e i dispositivi di rete.

Avvicinandoci alla data del debutto Intel diffonderà maggiori dettagli, dalla configurazione dei singoli modelli ai prezzi, nonché test prestazionali che aiuteranno a farsi un'idea dalla competitività della nuova gamma.

Sony Alpha 7 V, anteprima e novità della nuova 30fps, che tende la mano anche ai creator

Sony Alpha 7 V, anteprima e novità della nuova 30fps, che tende la mano anche ai creator realme GT 8 Pro Dream Edition: prestazioni da flagship e anima racing da F1

realme GT 8 Pro Dream Edition: prestazioni da flagship e anima racing da F1 OVHcloud Summit 2025: le novità del cloud europeo tra sovranità, IA e quantum

OVHcloud Summit 2025: le novità del cloud europeo tra sovranità, IA e quantum ROG Matrix RTX 5090: la GPU gaming più costosa al mondo ha problemi di qualità, ASUS la rimanda

ROG Matrix RTX 5090: la GPU gaming più costosa al mondo ha problemi di qualità, ASUS la rimanda AMD, Cisco e HUMAIN: una joint venture per realizzare un'infrastruttura IA da 1 GW in Arabia Saudita

AMD, Cisco e HUMAIN: una joint venture per realizzare un'infrastruttura IA da 1 GW in Arabia Saudita Una bottiglia d'acqua si rovescia nell'auto elettrica e causa danni per migliaia di euro

Una bottiglia d'acqua si rovescia nell'auto elettrica e causa danni per migliaia di euro Blink Mini quasi regalate: videocamere di sicurezza a partire da 14,99€ su Amazon

Blink Mini quasi regalate: videocamere di sicurezza a partire da 14,99€ su Amazon NASA OSIRIS-REx: trovati ribosio e glucosio nei campioni dell'asteroide Bennu

NASA OSIRIS-REx: trovati ribosio e glucosio nei campioni dell'asteroide Bennu Una delle figure più rilevanti del team di Baldur's Gate 3 è passata a CD Projekt RED: The Witcher 4 nel mirino?

Una delle figure più rilevanti del team di Baldur's Gate 3 è passata a CD Projekt RED: The Witcher 4 nel mirino? Auto elettriche al 27% in Europa: Tesla Model Y al primo posto, ma attenzione alla BYD Seal U

Auto elettriche al 27% in Europa: Tesla Model Y al primo posto, ma attenzione alla BYD Seal U Il CEO di Reddit dice che r/popular 'fa schifo' e sarà sostituito da contenuti personalizzati

Il CEO di Reddit dice che r/popular 'fa schifo' e sarà sostituito da contenuti personalizzati Spende 1.200 dollari per una RTX 5080 e riceve dei sassi: il rivenditore non vuole risarcirlo

Spende 1.200 dollari per una RTX 5080 e riceve dei sassi: il rivenditore non vuole risarcirlo Datacenter AI, reti elettriche... ecco perché il rame può diventare il nuovo petrolio

Datacenter AI, reti elettriche... ecco perché il rame può diventare il nuovo petrolio Super offerta Dyson: la V8 Absolute a 299€ è la scopa elettrica da battere

Super offerta Dyson: la V8 Absolute a 299€ è la scopa elettrica da battere Continua l'odissea di Horses: il gioco italiano è stato bandito anche dall'Humble Store

Continua l'odissea di Horses: il gioco italiano è stato bandito anche dall'Humble Store Vuoi rivedere una scena specifica di un film? Basta chiederlo ad Alexa+: descrivila e l'IA farà il resto

Vuoi rivedere una scena specifica di un film? Basta chiederlo ad Alexa+: descrivila e l'IA farà il resto Windows 11, attenzione: la lista delle CPU Intel supportate è cambiata (ed è più confusionaria)

Windows 11, attenzione: la lista delle CPU Intel supportate è cambiata (ed è più confusionaria)

5 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoLa flotta di server ARM sia su Azure che AWS che altri cloud providers si espande sempre piu.

L'm1 max nel prossimo macbook pro a 60W offre prestazioni simili in situazioni di workload come rendering simili ad un threadripper da 32 core che ne consuma 280?

In situazioni dove la latenza e' piu importante, come in server classici penso che ARM prendera' sempre piu il volo.

La piattaforma x86 e' terribilmente indietro a livello tecnologico e ormai non competitiva su laptop paragonata all'offerta ARM (almeno quella di Apple).

Sia AMD che Intel devono darsi una mossa nell'evolvere questa tecnologia o fra dieci anni sara' un ricordo.

La flotta di server ARM sia su Azure che AWS che altri cloud providers si espande sempre piu.

L'm1 max nel prossimo macbook pro a 60W offre prestazioni simili in situazioni di workload come rendering simili ad un threadripper da 32 core che ne consuma 280?

In situazioni dove la latenza e' piu importante, come in server classici penso che ARM prendera' sempre piu il volo.

La piattaforma x86 e' terribilmente indietro a livello tecnologico e ormai non competitiva su laptop paragonata all'offerta ARM (almeno quella di Apple).

Sia AMD che Intel devono darsi una mossa nell'evolvere questa tecnologia o fra dieci anni sara' un ricordo.

"L'm1 max nel prossimo macbook pro a 60W offre prestazioni simili in situazioni di workload come rendering simili ad un threadripper da 32 core che ne consuma 280?" ma è una domanda o un'affermazione? se è una domanda, è alquanto fumosa, carichi simili tra una cpu desktop e una server, come minimo occorre fare un bel discorso uslle app utilizzate per il confronto... al momento arm su server è una nicchia, in crescita ma sempre nicchia... intel domina il mercato, anche se amd sta piano piano prendendo piede. certo è che nel mercato server i ricambi avvengono più lentamente rispetto al mercato desktop, e i big player tendono a cercare di mantenere i grossi clienti con offerte ad hoc, sia in termini di volumi che in termini di progettazione, integrando on demand caratteristiche dedicate al cliente specifico... per cui i confronti poi su questo tipo di offerte diventano difficili da eseguire...

parole parole parole

seempre la stessa minestra da intel: solo chiacchiere e distintivo.. gold lake zio bello lake e nel frattempo, in sordina, i cinesi sfornano lo Yitian 710 , che è la vera innovazione , e secondo te hw upgrade ci fa un articolo? oops nulla da riportare paro paro dal comunicato stampa, troppo difficile, ci vorrebbe un articolista vero! questo ci ho messo più io a leggerlo che voi a scriverlo, che perdita di tempo...Innovativa quella cpu cinese? In cosa il numero dei core? Abbiamo un diverso concetto di innovazione

È molto più innovativa questa nuova serie di cpu Intel che quella che citi visto, sia per prestazioni , campi di usabilità e compatibilità con i framework più importanti.

Inoltre i dati di prestazioni dichiarati da Intel sono da verificare, sono partigianissimi (per loro l'X56 andava di più dell'Epyc X64).

Bisogna vedere il tutto in pratica. Intel è molto markettara nell'illustrare le sue offerte, speriamo che il fumo non superi l'arrosto.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".