Nvidia Grace, CPU ARM per datacenter IA e HPC in arrivo nel 2023: la sfida ai chip x86 è lanciata

Arriverà nel 2023 Nvidia Grace, la prima CPU per datacenter dell'azienda statunitense. Dopo le GPU e le DPU, Nvidia entra quindi un nuovo settore con l'obiettivo di accelerare, tremendamente, i calcoli legati a intelligenza artificiale e HPC.

di Manolo De Agostini pubblicata il 12 Aprile 2021, alle 21:01 nel canale ProcessoriNVIDIAGrace

Nvidia entra (o forse sarebbe meglio dire rientra se pensiamo a Project Denver) nel mondo delle CPU, anche se per ora solo quelle destinate ai datacenter e non prima del 2023. Grace, questo il nome del progetto, è un omaggio a Grace Murray Hopper, pioniera statunitense della programmazione informatica. Nvidia Grace è un processore basato su core ARM (non sappiamo ancora il numero, ma si parla di future versioni del core Neoverse) che punta a offrire prestazioni 10 volte superiori rispetto ai server attuali più veloci nei carichi di lavoro legati all'intelligenza artificiale (IA) e al calcolo generico (HPC).

Frutto di un lavoro ingegneristico quantificato in oltre 10.000 anni, Nvidia Grace combina i core ARM (azienda che Nvidia vuole acquistare per 40 miliardi di dollari) a un "innovativo sottosistema di memoria a basso consumo" per offrire alte prestazioni e, parimenti, un'efficienza superiore. Jensen Huang, fondatore e CEO di Nvidia, ha dichiarato nel corso di un keynote dalla sua cucina (ormai un must in epoca pandemica) che la CPU Grace - insieme a GPU e DPU - rende Nvidia "un'azienda fondata su tre chip". Tre gambe quindi, per un'azienda nata nel 1993 con un sogno: farci giocare meglio.

Grace è un processore altamente specializzato che si rivolge a carichi di lavoro "come l'addestramento di modelli NLP (Natural Language Processing) di prossima generazione con oltre 1 trilione di parametri" e che, quando accoppiato alle GPU Nvidia, offrirà "prestazioni 10 volte più veloci rispetto ai migliori sistemi Nvidia DGX basati su CPU x86" attuali.

L'azienda statunitense ribadisce che Grace "servirà un segmento di nicchia del computing" e tra le prime istituzioni pronte a realizzare supercomputer (a occuparsene sarà Hewlett Packard Enterprise, HPE) per la ricerca scientifica troviamo lo Swiss National Supercomputing Centre (CSCS) e il Los Alamos National Laboratory del Dipartimento dell'Energia statunitense: saranno "accesi" proprio nel 2023.

La CPU Nvidia Grace viene annunciata in un momento in cui il volume dei dati e la dimensione dei modelli di IA stanno crescendo esponenzialmente. I modelli più grandi includono miliardi di parametri e raddoppiano di dimensione ogni due mesi e mezzo. "L'addestramento di questi modelli", afferma Nvidia, "richiede una nuova CPU che può essere strettamente accoppiata con una GPU per eliminare i colli di bottiglia del sistema".

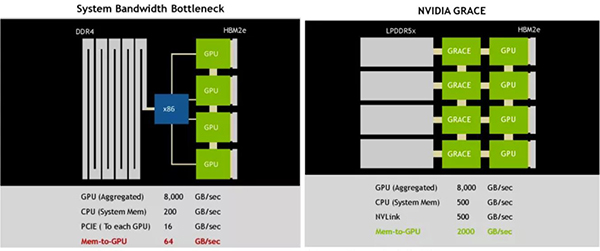

A garantire queste prestazioni sarà la quarta generazione dell'interconnessione Nvidia NVLink, che permetterà alla CPU Grace e alle GPU Nvidia collegate di "parlarsi" a 900 GB/s, ossia con una bandwidth aggregata 30 volte maggiore rispetto ai server di punta attuali. Si parla anche di 600 GB/s tra diverse CPU Grace. La CPU si avvarrà inoltre di un sottosistema di memoria LPDDR5x ECC in grado di fornire il doppio della bandwidth (almeno 500 GB/s) e un'efficienza energetica 10 volte migliore rispetto all'attuale memoria DDR4.

A completare il quadro tecnico una coerenza della cache con un singolo indirizzamento di memoria, in modo da combinare la memoria di sistema con quella HBM (High Memory Bandwidth) della GPU per semplificare la programmabilità. La CPU Grace sarà pienamente supportata dall'SDK Nvidia HPC e dalle librerie CUDA e CUDA-X per l'accelerazione delle operazioni mediante la GPU.

Perché Grace, perché ora?

"Nvidia vuole fare la guerra a Intel e AMD", sarebbe facile liquidare così il progetto Grace. E anche se indubbiamente questa svolta porterà ulteriore competizione in un settore già infuocato, con Grace l'obiettivo di Nvidia è quello di coprire un fronte scoperto della propria offerta e migliorare ulteriormente l'ecosistema a sostegno delle proprie GPU.

Infatti, se da una parte le GPU Nvidia sono ottime per determinati carichi di deep learning, ci sono casi in cui le CPU giocano un ruolo e, spesso e volentieri, rappresentano un freno. A fronte di prestazioni "general purpose" ottimali, né gli Xeon di Intel né gli EPYC di AMD sono in grado di offrire le prestazioni di I/O e le ottimizzazioni per il deep learning di cui Nvidia ha bisogno. Il problema, in particolare, è l'uso del PCI Express per la connettività tra CPU e GPU; se da una parte le GPU sono in grado di parlarsi rapidamente tra loro grazie a NVLink, la stessa cosa non avviene con la CPU.

La soluzione è quindi quella di portare in scena NVLink anche per la gestione delle comunicazioni tra CPU e GPU. Nvidia ci ha già provato in passato siglando una partnership con IBM e le sue CPU Power9, ma quello sforzo è naufragato. Nvidia ha quindi preso in parola il motto "chi fa da sé fa per tre" e ha progettato Grace, che vede a bordo di una singola scheda una GPU, una CPU e la relativa memoria. I moduli Grace saranno disponibili anche per l'uso su schede HGX e, per estensione, li vedremo sulle future versioni di DGX e gli altri sistemi.

Visto che manca ancora molto al debutto, l'azienda non ha rivelato tutte le informazioni tecniche, ma ha parlato di core capaci di superare 300 punti nel benchmark SPECrate2017_int_base, un valore simile agli AMD EPYC di seconda generazione a 64 core (Rome). Nvidia ha inoltre aggiunto che un sistema DGX con otto GPU è in grado di scalare linearmente raggiungendo un punteggio di 2400 nel test SPECrate_2017_int_base, a fronte di una configurazione DGX odierna simile che raggiunge un punteggio di 450. L'azienda, infine, ha anticipato configurazioni in grado di ridurre i tempi di addestramento di modelli da 1 trilione di parametri da un mese a soli tre giorni.

ASUS Expertbook PM3: il notebook robusto per le aziende

ASUS Expertbook PM3: il notebook robusto per le aziende Test ride con Gowow Ori: elettrico e off-road vanno incredibilmente d'accordo

Test ride con Gowow Ori: elettrico e off-road vanno incredibilmente d'accordo Recensione OnePlus 15: potenza da vendere e batteria enorme dentro un nuovo design

Recensione OnePlus 15: potenza da vendere e batteria enorme dentro un nuovo design  Tesla si accorda ancora una volta in una causa per incidente con Autopilot

Tesla si accorda ancora una volta in una causa per incidente con Autopilot Game Awards 2025: annunciati i candidati al GOTY, sfida senza esclusione di colpi

Game Awards 2025: annunciati i candidati al GOTY, sfida senza esclusione di colpi Scegliere il monitor giusto: dalla produttività quotidiana alla precisione professionale c'è un monitor ASUS per tutte le esigenze

Scegliere il monitor giusto: dalla produttività quotidiana alla precisione professionale c'è un monitor ASUS per tutte le esigenze Super sconto sulla GoPro HERO13 Black: il bundle completo crolla a 306,90€ su Amazon con coupon attivabile (prezzo di listino 519,99€)

Super sconto sulla GoPro HERO13 Black: il bundle completo crolla a 306,90€ su Amazon con coupon attivabile (prezzo di listino 519,99€) Nintendo: ecco le prime immagini del film live-action di The Legend of Zelda

Nintendo: ecco le prime immagini del film live-action di The Legend of Zelda NIO ha una super batteria da 1.000 km, ma nessuno la vuole. Produzione già interrotta

NIO ha una super batteria da 1.000 km, ma nessuno la vuole. Produzione già interrotta Primo crollo di prezzo: iPhone 17 Pro Max finalmente in sconto su Amazon a 1.409€ (-80€ rispetto al listino)

Primo crollo di prezzo: iPhone 17 Pro Max finalmente in sconto su Amazon a 1.409€ (-80€ rispetto al listino) Una super offerta su Amazon: la scopa elettrica Mova S2 cala a soli 159€ con potenza da 36.000Pa

Una super offerta su Amazon: la scopa elettrica Mova S2 cala a soli 159€ con potenza da 36.000Pa Xiaomi 15 Ultra crolla di prezzo su Amazon: lo smartphone premium con fotocamere Leica ora a meno di 1000€, con uno sconto di 300€

Xiaomi 15 Ultra crolla di prezzo su Amazon: lo smartphone premium con fotocamere Leica ora a meno di 1000€, con uno sconto di 300€ Disney punta sull'IA? L'animatrice di The Owl House - Aspirante strega invita gli utenti a piratare la serie

Disney punta sull'IA? L'animatrice di The Owl House - Aspirante strega invita gli utenti a piratare la serie Il processo produttivo a 2 nanometri di Samsung offrirà solo miglioramenti marginali rispetto a 3 nanometri

Il processo produttivo a 2 nanometri di Samsung offrirà solo miglioramenti marginali rispetto a 3 nanometri Su Amazon DREAME e MOVA Ultra fanno pazzie per allinearsi alla concorrenza: sconti mai visti prima e tecnologia al top fino a 30.000 Pa

Su Amazon DREAME e MOVA Ultra fanno pazzie per allinearsi alla concorrenza: sconti mai visti prima e tecnologia al top fino a 30.000 Pa GlobalFoundries fa shopping a Singapore e scommette tutto sulla fotonica

GlobalFoundries fa shopping a Singapore e scommette tutto sulla fotonica 3 smartphone in sconto Black Friday, Xiaomi e POCO, da 149€ a 179€: super batteria o fotocamera da 108Mpixel OIS?

3 smartphone in sconto Black Friday, Xiaomi e POCO, da 149€ a 179€: super batteria o fotocamera da 108Mpixel OIS?

12 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoNessuno mai userà una scheda simile per minare, non sono fatte per quello è non serve nessuna cpu potente per farlo ti basta un i3 di 10 anni fa

"Nvidia entra (o forse sarebbe meglio dire rientra se pensiamo a Project Denver) "

Ma i vari soc Tegra usciti negli ultimi anni non sono proprio basati su CPU ARM prodotte da Nvidia?

Tra l'altro leggo su wikipedia che giutsto ieri ne è stata annunciata una nuova versione

Atlan

Nvidia announced the next-gen SoC codename Atlan on April 12, 2021 at GPU Technology Conference 2

https://en.wikipedia.org/wiki/Tegra

"Frutto di un lavoro ingegneristico quantificato in oltre 10.000 anni"

Da ignorante suppongo che quei 10 mila anni siano una stima del tempo necessario se i calcoli fossero stati fatti con sistemi tradizionali e non con computer quantistici... però resta che scritto così mi pare una super cazzola, cioè sembra dire che gli ingegneri di Nvidia abbiano cominciato a lavorarci migliaia di anni prima che in Egitto sorgessero le piramidi, magari sulla mitica isola di Atlantide?

Da ignorante suppongo che quei 10 mila anni siano una stima del tempo necessario se i calcoli fossero stati fatti con sistemi tradizionali e non con computer quantistici... però resta che scritto così mi pare una super cazzola, cioè sembra dire che gli ingegneri di Nvidia abbiano cominciato a lavorarci migliaia di anni prima che in Egitto sorgessero le piramidi, magari sulla mitica isola di Atlantide?

si calcolo in anni uomo

Non è proprio così, se ogni GPU ha la sua CPU e una RAM velocissima l'hash rate aumenta, poi la sinergia che avrà e volutamente studiata per il Mining.

Che un x86 con 200Mhz e 5 schede video sia nettamente meno performante di 5xARM con 5xSchede Video lo sono, inoltre e un archittettura che slega dalla CPU centralizzata, in pratica a differenza di come e oggi ad ogni modulo la velocità aumenta linearmente e non con una curva tendente alla limitazione del BUS PCI-E, Saturata la banda passante di questo, hai voglia di mettere ulteriori schede video, si metteranno in coda, è il limite dell'x86 in cui due schede in nVlink sono come 1,75 schede in risultato.

... neppure le RTX 3090 sono fatte per quello, in teoria gli ASICS esistono anche per Ethereum, ma di fatto visto il Boom usciranno altre 100 Criptomonete, alcume useranno anche il tostapane smart.... pur di minare e gli ASICS non si riciclano dopo.

Che un x86 con 200Mhz e 5 schede video sia nettamente meno performante di 5xARM con 5xSchede Video lo sono, inoltre e un archittettura che slega dalla CPU centralizzata, in pratica a differenza di come e oggi ad ogni modulo la velocità aumenta linearmente e non con una curva tendente alla limitazione del BUS PCI-E, Saturata la banda passante di questo, hai voglia di mettere ulteriori schede video, si metteranno in coda, è il limite dell'x86 in cui due schede in nVlink sono come 1,75 schede in risultato.

... neppure le RTX 3090 sono fatte per quello, in teoria gli ASICS esistono anche per Ethereum, ma di fatto visto il Boom usciranno altre 100 Criptomonete, alcume useranno anche il tostapane smart.... pur di minare e gli ASICS non si riciclano dopo.

per minare ti basta una cpu antica (celetron per esempio) non fa nulla la cpu durante l'elaborazione e le schede basta collegarle a un PCI Express 1. Per la ram ti basta 4GB di ram , non viene usata nessuna banda

Una stazione di mining di 8 3090 le fai con 1 singolo connettore pcie a 16 linee a versione 3 e ti basterebbe il 2

Questa

www.amazon.it/dp/B08YN2VLF7/?tag=rpr08-21

e la tipica scheda usata per minare con le gpu ed è l'esatto opposto di quello che hai descritto è super vecchia super lenta e super poco espandibile eppure è fra la è piu utilizzata

Oppure una B250 Mining Expert che è una scheda professionale per il mining e ha 18 PCIe x1 e viene normalmente utilizzata con cpu celeron e 8GB di ram (bastano 4 ma spesso costano di piu quindi si passa a 8)

A quando il computer quantistico? se lo ha fatto IBM...

Ma il pp? frequenze? IPC? core count? no perché alla fine si parla di questo, altrimenti non hanno più valore dello "slide marketing" tanto odiato di amd dal 2010 al 2016

E' un concetto di computazione parallela che in giro di 5 anni se prende piede farà sparire anche le GPU perchè diventeranno dei moduli tutto in uno con all'interno un arrai di core ibridi CPU-ARG-GPU-CUDAx e fisicamente non esisterà piu il PC come lo conosciamo, quindi anche il modo di minare si adeguerà a quel concetto.

Quando usciranno vedremo 2023 ne passa di acqua sotto il PonteVecchio......

.....magari per guerre tra superpotenze mondiali scoppiate per chissà che cosa o varianti virali che ammazzano il 90% della popolazione potrebbe anche essere che l'elaboratore più potente sarà un Pallottoliere...

....Come detto si mina anche con il GameBoy.

Lo ha già fatto, il 13 settembre 2020, per 40 miliardi di dollari.

https://nvidianews.nvidia.com/news/nvidia-to-acquire-arm-for-40-billion-creating-worlds-premier-computing-company-for-the-age-of-ai

Buona giornata.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".