Da Fermi ad Ampere, 10 anni di GPU Nvidia GeForce: 44 modelli alla prova

Dalla GTX 480 alla RTX 3090, come si sono evolute le prestazioni delle schede video Nvidia GeForce negli ultimi 10 anni? Abbiamo provato 44 modelli di schede, dall'architettura Fermi fino alla più recente Ampere, per scoprirlo: da quando il Full HD sembrava la risoluzione principe fino all'odierno 4K.

di Manolo De Agostini pubblicato il 30 Aprile 2021 nel canale Schede VideoGeForceTuringAmpereRTXNVIDIAPascal

Dopo aver testato le CPU Ryzen dai modelli 1000 ai 5000, ci abbiamo preso gusto. In questo articolo - altri ne seguiranno - vediamo come sono cambiate le prestazioni delle GPU Nvidia negli ultimi 10 anni circa, dal 2010 al 2020, dall'architettura Fermi della serie GeForce GTX 400 (un prodotto caldo, in tutti i sensi, dell'epoca) all'attuale gamma Ampere. I test sono stati svolti su una piattaforma con CPU Ryzen 9 5900X e 16 GB di RAM, usando un totale di sei test - quattro giochi e due sintetici (Unigine Valley e 3DMark Fire Strike).

Per quanto concerne i giochi, certamente la parte più interessante dell'articolo, abbiamo selezionato Metro Exodus (2019), Shadow of the Tomb Raider (2018), Borderlands 3 (2019) e Far Cry 5 (2018). Abbiamo scelto dei titoli non troppo vecchi e per certi versi attuali per far sì che il carico fosse rilevante anche per le ultime GPU di Nvidia, andando però a scegliere l'impostazione di dettaglio media in modo da non mettere in ginocchio le GPU più vecchie più di quanto già non lo fossero.

Un'altra cosa che dovete sapere è che le schede video più datate ci hanno restituito dei crash eseguendo alcuni di questi giochi in DirectX 12, quindi abbiamo dovuto svolgere i benchmark optando per le DirectX 11. Poco male, l'importante era avere lo stesso campo da gioco. Per quanto concerne le risoluzioni invece, tutte le schede sono state provate in Full HD, un numero più ristretto anche in WQHD e una manciata anche in 4K.

Infine, i driver. Per le GPU GeForce GTX 400 e 500 abbiamo usato gli ultimi driver compatibili sul sito Nvidia, i 391.35, che peraltro nelle note di rilascio aggiungono ottimizzazioni proprio per Far Cry 5. Il resto delle schede video, dalla serie 600 in poi, è stata provata con i 461.40, salvo l'ultima RTX 3060 12GB provata con i primi driver compatibili, i 461.72. Volete vedere i test? Certo, potete scorrere più in basso e vederli subito, ma se un po' amate il mondo delle schede video allora continuate a leggere perché vogliamo parlarvi a grandi linee dell'evoluzione delle GPU Nvidia, magari alcune delle GPU che citeremo le avete acquistate o magari le avete solo sognate, ma certamente qualcosa vi tornerà alla memoria. Partiamo!

GeForce GTX 400: architettura Fermi

Il nostro viaggio nel mondo Nvidia parte dall'architettura Fermi, chiamata così in onore del fisico italiano. Avevamo a disposizione tre schede video dell'epoca per la nostra prova: GTX 460, GTX 470 e GTX 480. La prima basata su una GPU GF104 con 1,95 miliardi di transistor su un'area di 332 mm2. All'epoca Nvidia si servì del processo produttivo a 40 nanometri di TSMC per realizzare il chip.

La GPU in questione mette a disposizione 336 CUDA core (7 streaming multiprocessor con 48 core ciascuno), 56 TMU e 32 ROPs. Le unità a funzione fissa operano a 675 MHz, mentre gli shader operano a 1350 MHz. Accanto alla GPU, collegata tramite un bus a 256 bit, 1 GB di memoria GDDR5 a 3600 MHz per una bandwidth di 115,2 GB/s. Le altre due schede, GeForce GTX 470 e 480, si basano invece sulla più potente GPU GF100. Potente sì, ma anche molto calda: ce lo ricordavamo da allora e possiamo confermarlo anche oggi dopo i test, sul dissipatore metallico esterno della GTX 480 è possibile cuocere un uovo!

| GPU | CUDA core | Bus | Memoria | |

| GeForce GTX 480 | GF100 | 480 | 384 bit | 1,5 GB GDDR5 |

| GeForce GTX 470 | GF100 | 448 | 320 bit | 1,28 GB GDDR5 |

| GeForce GTX 460 | GF104 | 336 | 256 bit | 1 GB MB GDDR5 |

GF100 è una bestia differente rispetto a GF104. Anch'esso realizzata a 40 nanometri da TSMC, integra 3,1 miliardi di transistor su 529 mm2. In questo caso abbiamo 32 core per SM: sulla GTX 470 si contano 14 SM per un totale di 448 CUDA core, mentre sulla GTX 480 c'è un SM in più che permette di avere 480 CUDA core. Differenze anche per le altre unità (56 TMU e 40 ROPs sulla GTX 470 e 60 TMU e 48 ROPs sulla 480). Frequenze a parte, le due schede hanno 1,5 GB di memoria GDDR5 su bus a 320 e 384 bit.

GeForce GTX 500: architettura Fermi 2.0

Conscia dei problemi della serie precedente, Nvidia corse ai ripari nell'ultima parte del 2010 con la serie di schede video GeForce GTX 500. L'architettura era sempre quella Fermi, ma l'azienda fece alcune modifiche per estrarre maggiori prestazioni e allo stesso tempo ridurre persino temperature e consumi, senza però passare a un processo produttivo più evoluto. In questo articolo abbiamo quattro cinque modelli di quella gamma: GTX 550 Ti, GTX 560 Ti, GTX 570, GTX 580 e GTX 590.

La GeForce GTX 550 Ti è basata su una GPU GF116 (40 nm - 1,17 miliardi di transistor - 238 mm2) al cui interno ci sono 192 CUDA core, 32 TMU e 24 ROPs. Accanto al chip grafico trova spazio 1 GB di memoria GDDR5 su bus a 192 bit. Nel modello GeForce GTX 560 Ti troviamo una GPU diversa chiamata GF114 (40 nm - 1,95 miliardi di transistor - 332 mm2) che mette a disposizione 384 CUDA core, 64 TMU e 32 ROPs. Anche in questo caso troviamo 1 GB di memoria GDDR5, ma collegata a bus più ampio di 256 bit.

| GPU | CUDA core | Bus | Memoria | |

| GeForce GTX 590 | GF110 x 2 | 512 x 2 | 384 bit x 2 | 1,5 GB GDDR5 x 2 |

| GeForce GTX 580 | GF110 | 512 | 384 bit | 1,5 GB GDDR5 |

| GeForce GTX 570 | GF110 | 480 | 320 bit | 1,28 GB GDDR5 |

| GeForce GTX 560 Ti | GF114 | 348 | 256 bit | 1 GB GDDR5 |

| GeForce GTX 550 Ti | GF116 | 192 | 192 bit | 1 GB GDDR5 |

Come i modelli predecessori della serie GTX 400, anche le schede GeForce GTX 570 e GTX 580 condividono la medesima GPU, in questo caso il chip GF110 (40 nm - 3 miliardi di transistor - 520 mm2) ma ovviamente con un differente numero di unità abilitate. Nel caso della GTX 570 abbiamo 480 CUDA core, 60 TMU e 40 ROPs, mentre la GTX 580 vanta 512 CUDA core, 64 TMU, 48 ROPs. Il modello 70 è accompagnato da 1,2 GB di memoria GDDR5 su bus a 320 bit, mentre il fratello maggiore da 1,5 GB di memoria GDDR5 su bus a 384 bit.

Con la GeForce GTX 590 facciamo davvero un tuffo nel passato perché si parla di una scheda video con due GPU sullo stesso PCB. Pensate a una "GTX 580 x 2", con due GPU GF110 con 512 unità ciascuna, il suo bus e la propria memoria. Raddoppierà le prestazioni della GTX 580 nei nostri test? Molti di voi già conoscono la risposta.

GeForce GTX 600: architettura Kepler e 28 nanometri

La gamma di schede video Nvidia GeForce GTX 600 è arrivata nel 2012 e segna il passaggio a una nuova architettura chiamata Kepler e a un processo produttivo più avanzato, quello a 28 nanometri. Certo, alcuni modelli di fascia bassa o per OEM usavano ancora delle GPU Fermi, ma in generale la maggior parte delle schede erano basate su Kepler. Anche per questa serie siamo riusciti a recuperare cinque modelli: GTX 650 Ti, GTX 650 Ti Boost, GTX 670, GTX 680 e GTX 690.

Kepler rappresenta un passo avanti importante rispetto a Fermi, e lo vedrete anche nei test. Basta guardare i numeri dei CUDA core per capire che Nvidia voleva farsi perdonare le due serie precedenti non così esaltanti. Kepler era un'ottima architettura, per l'epoca, in termini di rapporto tra prestazioni e consumi. È proprio con questa architettura che Nvidia introdusse i GPC, al cui interno c'era un rinnovato Streaming Multiprocessor. Un'altra novità fu il Boost Clock, termine che oggi non ha bisogno di spiegazioni ma che allora rappresentava una grande novità, perché vedeva la GPU alzare la propria frequenza operativa in cerca di maggiori prestazioni in base al budget termico e di consumo. Infine, Kepler fu la prima architettura Nvidia a supportare il TXAA e ad avere un encoder H.264 - NVENC - dedicato, sgravando così i CUDA core da tale compito.

| GPU | CUDA core | Bus | Memoria | |

| GeForce GTX 690 | GK104 x 2 | 1536 x 2 | 256 bit x 2 | 2 GB GDDR5 x 2 |

| GeForce GTX 680 | GK104 | 1536 | 256 bit | 2 GB GDDR5 |

| GeForce GTX 670 | GK104 | 1344 | 256 bit | 2 GB GDDR5 |

| GeForce GTX 650 Ti Boost | GK106 | 768 | 192 bit | 2 GB GDDR5 |

| GeForce GTX 650 Ti | GK106 | 768 | 128 bit | 1 GB GDDR5 |

Veniamo alle caratteristiche delle GPU, andando però alla rovescia e quindi partendo quindi dalla GTX 690. Come la GTX 590, questa scheda è una dual GPU, basata nel caso specifico sul chip GK104 (28 nm - 3,54 miliardi di transistor - 294 mm2) con ben 1536 CUDA core (tre volte in più rispetto a quelli del chip GF110!), 128 TMU e 32 ROPs. Ciascuna GPU ha accesso a 2 GB di memoria GDDR5 su bus a 256 bit. La GTX 680 è la metà di una GTX 690, quindi non ci ripetiamo, mentre la GTX 670 ha la stessa GPU "castrata", con 1344 CUDA core, 112 TMU e 32 ROPs.

GeForce GTX 650 Ti e GTX 650 Ti Boost chiudono il quadro. Queste due soluzioni sono basate su una GPU chiamata GK106 (28 nm - 2,54 miliardi di transistor - 221 mm2) con 768 CUDA core, 64 TMU e 16 ROPs. Il modello GTX 650 Ti ha 1 GB di memoria GDDR5 su bus a 128 bit, mentre la variante Boost ha 2 GB su bus a 192 bit.

GeForce GTX 700: Kepler ma non solo

La serie di schede video GeForce GTX 700 che iniziò a fare capolino nel 2013, se vista nel complesso, è composta da tre architetture: Kepler, Fermi e Maxwell (sì, il successore di Kepler). Di questa gamma abbiamo recuperato sei modelli: GTX 750 Ti, GTX 760, GTX 770 e GTX 780 e GTX 780 Ti. E proprio la prima di queste schede è interessante, perché sebbene chiamata GTX 750 Ti, è basata su una GPU Maxwell GM107 realizzata a 28 nanometri.

Nel 2014 Nvidia decise infatti di introdurre l'architettura Maxwell partendo dal basso, presentando un progetto che puntava molto sull'efficienza. L'azienda statunitense intervenne sugli Streaming Multiprocessor implementando diverse migliorie e aumentò la cache L2 da 256 KB a ben 2 MB. Il risultato furono degli SM nettamente più piccoli in termini di superficie occupata rispetto a Kepler, pur offrendo circa il 90% della potenza di elaborazione. La riduzione nella superficie di ogni SM permise a Nvidia di integrarne un numero maggiore in ogni GPU a parità di dimensione, ottenendo più potenza e consumi in calo.

Cuore della GTX 750 Ti è come abbiamo anticipato il chip grafico GM107 (28 nm - 1,87 miliardi di transistor - 148 mm2) con 640 CUDA core, 40 TMU e 16 ROPs. A bordo della scheda 2 GB di memoria GDDR5 su bus a 128 bit. La GTX 760, invece, sfruttava una GPU GK104 - già a bordo delle GTX 670/680 precedenti - con 1152 CUDA core attivi, 96 ROPS e 32 ROPs. Sulla scheda ecco 2 GB di memoria GDDR5 collegati tramite un bus a 256 bit.

| GPU | CUDA core | Bus | Memoria | |

| GeForce GTX 780 Ti | GK110 | 2880 | 384 bit | 3 GB GDDR5 |

| GeForce GTX 780 | GK110 | 2304 | 384 bit | 3 GB GDDR5 |

| GeForce GTX 770 | GK104 | 1536 | 256 bit | 2 GB GDDR5 |

| GeForce GTX 760 | GK104 | 1152 | 256 bit | 2 GB GDDR5 |

| GeForce GTX 750 Ti | GM107 | 640 | 128 bit | 2 GB GDDR5 |

Stesso chip grafico per la GTX 770, ma con 1536 CUDA core, 128 TMU e 32 ROPs come la precedente GTX 680. Accanto alla GPU ecco 2 GB di memoria GDDR5 su bus a 256 bit. Per spingersi oltre in modo netto rispetto alle prestazioni della serie 600, Nvidia progettò per le schede GTX 780 e GTX 780 Ti una GPU Kepler chiamata GK110, sempre a 28 nanometri ma di un'altra caratura grazie a 7,08 miliardi di transistor su un'area di 561 mm2. La GTX 780 offre 2304 CUDA core, 192 TMU e 48 ROPs, affiancati da 3 GB di memoria GDDR5 su bus a 384 bit. La GTX 780 Ti vedeva aumentare il numero di alcune unità all'interno del chip arrivando a 2880 CUDA core, 240 TMU e 48 ROPs.

GeForce GTX 900: Maxwell 2.0

La GTX 750 Ti che introdusse l'architettura Maxwell fu solo una sorta di prova generale prima di portare il progetto in pompa magna sul mercato con la serie GeForce GTX 900 nell'ultima parte del 2014. Di questa famiglia avevamo a disposizione cinque modelli: GTX 950, GTX 960, GTX 970, GTX 980 e GTX 980 Ti. Prima di analizzarli, quando si parla di GeForce GTX 900 non si può glissare su due controversie che - a conti fatti - non ebbero però ripercussioni per il successo di queste video.

La prima, la più famosa, interessò la GeForce GTX 970. La scheda aveva fisicamente 4 GB di memoria, e si comportava bene nei giochi, ma un giorno alcuni utenti notarono che in realtà la memoria usata in game raramente oltrepassava i 3,5 GB. Questo avveniva perché l'architettura di memoria di Maxwell si basava su una tecnica che segmentava la memoria permettendo di dotare anche le schede con configurazioni castrate di maggiore VRAM.

"La GTX 970 è una scheda da 4GB", disse il CEO di Nvidia scusandosi per la scarsa chiarezza. "Tuttavia, gli ultimi 512 MB del gigabyte aggiuntivo è segmentato e con una bandwidth ridotta. Si tratta di un buon progetto perché siamo stati in grado di aggiungere 1 GB in più alla GTX 970 e i nostri ingegneri software possono mantenere i dati usati meno frequentemente nel segmento da 512 MB".

Jonah Alben, allora Senior VP of Hardware Engineering, disse che la scheda funzionava "esattamente per come era stata progettata" e che questo comportamento permetteva alla GTX 970 di avere un bus a 256 bit. Purtroppo per Nvidia, e qui fu l'errore grosso (almeno da un punto di vista legale), è che comunicò dati sbagliati per le ROPs e la cache L2: dai 64 e 2048 KB comunicati inizialmente, l'azienda dovette rivedere le specifiche a 56 e 1792 KB. La spiegazione tecnica non bastò a molti utenti e la polemica montò fino alla class action che, nel 2016, si chiuse con un accordo: Nvidia risarcì gli acquirenti a stelle e strisce della scheda con 30 dollari ciascuno. Il secondo caso, meno spinoso, riguardava il supporto all'Asynchronous Compute delle API DirectX 12, inefficiente nel caso dell'architettura Maxwell, soprattutto se paragonato alle soluzioni GCN di AMD. La funzionalità però non prese grande piede nei giochi di allora, quindi salvo alcune eccezioni come Ashes of the Singularity, le vendite non ne risentirono.

| GPU | CUDA core | Bus | Memoria | |

| GeForce GTX 980 Ti | GM200 | 2816 | 384 bit | 6 GB GDDR5 |

| GeForce GTX 980 | GM204 | 2048 | 256 bit | 4 GB GDDR5 |

| GeForce GTX 970 | GM204 | 1664 | 256 bit | 4 GB GDDR5 |

| GeForce GTX 960 | GM206 | 1024 | 128 bit | 2 GB GDDR5 |

| GeForce GTX 950 | GM206 | 768 | 128 bit | 2 GB GDDR5 |

Parliamo ora delle specifiche delle schede video in nostro possesso. La GTX 950 e la GTX 960 sono basate sul chip grafico GM206 (28 nm - 2,94 miliardi di transistor - 228 mm2), ma con differenti configurazioni. Nel caso della GTX 950 la GPU ha 768 CUDA core, 48 TMU e 32 ROPs, mentre la GTX 960 conta 1024 CUDA core, 64 TMU e 32 ROPs. In termini di memoria entrambe vantano 2 GB di GDDR5 su bus a 128 bit.

Stessa GPU anche per la GTX 970 e la GTX 980, il GM204: realizzato a 28 nanometri, conta 5,2 miliardi di transistor su un die da 398 mm2. La GTX 970 ha 1664 CUDA core, 104 TMU e 56 ROPs, la GTX 980 saliva a 2048 CUDA core, 128 TMU e 64 ROPs. Per entrambe (o forse no?) 4 GB di memoria GDDR5 su bus a 256 bit.

Infine, ecco la "bomba" dell'epoca, la GTX 980 Ti basata su GPU GM200, oggettivamente un passo avanti rispetto al GM204 grazie a 8 miliardi di transistor in un die da 601 mm2. La GTX 980 Ti conta 2816 CUDA core, 176 TMU, 96 ROPs e 6 GB di memoria GDDR5 su bus a 384 bit.

GeForce GTX 1000: Pascal e un nuovo processo produttivo

A metà 2016 abbiamo accolto la famiglia di schede GeForce GTX 1000, importante perché la prima a dire addio al processo produttivo a 28 nanometri per passare ai 16 nanometri di TSMC (o ai 14 nm di Samsung). La nuova architettura Pascal portava alcune migliorie rispetto a Maxwell, ma soprattutto godeva di tecniche di compressione dei dati più avanzate.

Le prime schede della serie ad arrivare sul mercato furono la GTX 1070 e la GTX 1080, e partiamo proprio da quei modelli, entrambi basati su una GPU chiamata GP104 (16 nm - 7,2 miliardi di transistor - 314 mm2). La GTX 1070 offre 1920 CUDA core, 120 TMU e 64 ROPs, affiancati da 8 GB di memoria GDDR5 su bus a 256 bit. La GTX 1080, invece, conta 2560 CUDA core, 160 TMU e 64 ROPs. La differenza tra le due schede riguarda l'uso della memoria GDDR5X sulla GTX 1080, sempre 8 GB su bus a 256 bit, in grado di garantire un raddoppio della bandwidth a parità di frequenza di clock nominale della memoria rispetto alla GDDR5.

La GTX 1080 Ti, da par suo, monta una GPU GP102 (16 nm - 11,8 miliardi di transistor - 471 mm2) con oltre 1000 CUDA core in più rispetto alla GTX 1080: al suo interno ha 3584 CUDA core, 224 TMU e 88 ROPs, affiancati da 11 GB di memoria GDDR5X su bus a 352 bit.

| GPU | CUDA core | Bus | Memoria | |

| GeForce GTX 1080 Ti | GP102 | 3584 | 352 bit | 11 GB GDDR5X |

| GeForce GTX 1080 | GP104 | 2560 | 256 bit | 8 GB GDDR5X |

| GeForce GTX 1070 | GP104 | 1920 | 256 bit | 8 GB GDDR5 |

| GeForce GTX 1060 6GB | GP106 | 1280 | 192 bit | 6 GB GDDR5 |

| GeForce GT 1030 | GP108 | 384 | 64 bit | 2 GB GDDR5 |

Vi abbiamo parlato delle ammiraglie, ma la gamma GTX 1000 ha visto una scheda molto popolare, la GTX 1060 6GB, che ovviamente avevamo ancora nelle nostre segrete stanze per metterla alla prova. La GPU GP106 a bordo di questa scheda è realizzata a 16 nanometri e figura 4,4 miliardi di transistor su un'area di 200 mm2. Il conto dei CUDA core si ferma 1280, mentre TMU e ROPs sono rispettivamente 80 e 48. La scheda vanta 6 GB di memoria GDDR5 su bus a 192 bit.

Infine, abbiamo pescato in un cassetto la GT 1030, una piccola scheda pensata non certo per giocare, con GPU GP108 prodotta da Samsung a 14 nanometri. Il progetto prevede 1,8 miliardi di transistor su 74 mm2, stiamo parlando quindi di un chip davvero modesto con, nel caso specifico, 384 CUDA core, 24 TMU e 16 ROPs. A bordo, 2 GB di memoria GDDR5 su bus a 64 bit.

GeForce RTX 2000 e GTX 1600, Turing apre l'era del ray tracing

Arriviamo a tempi più recenti (da settembre 2018), con le serie di schede video GeForce RTX 2000 e GeForce GTX 1600. Entrambe introducono l'architettura Turing e il processo produttivo a 12 nanometri. Non ci dilunghiamo troppo a parlare dell'architettura, che conoscete molto bene: Turing è la primache introduce il ray tracing in tempo reale. Certo, solo sulle GPU RTX 2000, ma è questa la grande novità a conti fatti.

Della serie RTX 2000 abbiamo sei modelli: RTX 2060, RTX 2060 Super, RTX 2070 Super, RTX 2080, RTX 2080 Super e RTX 2080 Ti. Oltre ai CUDA core, Turing introduce delle unità chiamate RT Core che servono al calcolo degli effetti di ray tracing in tempo reale. I Tensor core, altra unità specializzata (introdotta da Nvidia con l'architettura Volta dedicata ai datacenter), serve invece per operazioni denoising delle immagini, il DLSS e in generale operazioni di "intelligenza artificiale".

Per quanto riguarda la serie GTX 1600, invece, abbiamo delle schede più tradizionali, prive di unità RT core e Tensor core, che possono eseguire il ray tracing solo tramite sfruttando i CUDA core: l'assenza di un'unità dedicata impatta fortemente sulle prestazioni finali. Di questa serie abbiamo provato cinque GPU: GTX 1650, GTX 1650 SUPER, GTX 1660, GTX 1660 SUPER e GTX 1660 Ti.

Partiamo dalle GeForce RTX 2000. La RTX 2060 rappresenta la porta d'ingresso al ray tracing accelerato in hardware grazie alla GPU TU106 (12 nm - 10,8 miliardi - 445 mm2) con 1920 CUDA core, 120 TMU, 48 ROPs, 240 Tensor core e 30 RT core. Accanto al chip grafico ci sono 6 GB di memoria GDDR6 su bus a 192 bit. La RTX 2060 Super, arrivata un anno dopo, conserva lo stesso chip ma con più unità attive: 2176 CUDA core, 136 TMU e 64 ROPs, insieme a 272 Tensor core e 34 RT core. La scheda si fregia inoltre di 2 GB di memoria in più, per un totale di 8 GB di memoria GDDR6 su bus a 256 bit.

RTX 2070 Super, RTX 2080 e RTX 2080 Super sono invece basate sulla GPU TU104, una soluzione da 545 mm2 con 13,6 miliardi di transistor. Tutte e tre le schede hanno 8 GB di memoria GDDR6 su bus a 256 bit. La 2070 SUPER si presenta con 2560 CUDA core, 160 TMU e 64 ROPs, oltre a 320 Tensor core e 40 RT Core, mentre la RTX 2080 sale a 2944 CUDA core, 184 TMU 64 ROPS, con 368 Tensor core e 46 RT core. Il trio si chiude con la RTX 2080 SUPER, forte della GPU nella sua massima espressione: 3072 CUDA core, 192 TMU, 64 ROPs, 384 Tensor core e 48 RT core.

| GPU | CUDA core | RT core | Tensor core | Bus | Memoria | |

| GeForce RTX 2080 Ti | TU102 | 4352 | 68 | 544 | 352 bit | 11 GB GDDR6 |

| GeForce RTX 2080S | TU104 | 3072 | 48 | 384 | 256 bit | 8 GB GDDR6 |

| GeForce RTX 2080 | TU104 | 2944 | 46 | 368 | 256 bit | 8 GB GDDR6 |

| GeForce RTX 2070S | TU104 | 2560 | 40 | 320 | 256 bit | 8 GB GDDR6 |

| GeForce RTX 2060S | TU106 | 2176 | 34 | 272 | 256 bit | 8 GB GDDR6 |

| GeForce RTX 2060 | TU106 | 1920 | 30 | 240 | 192 bit | 6 GB GDDR6 |

Infine, ecco la top di gamma della serie RTX 2000, la RTX 2080 Ti. L'unico modello basato sulla GPU TU102 figura ben 4352 CUDA core, 272 TMU, 88 ROPs, 544 Tensor Core e 68 RT core. Il chip grafico è un "mostro" da 754 mm2 con 18,6 miliardi di transistor. Sulla scheda trovano posto 11 GB di memoria GDDR6 su bus a 352 bit. E la serie GTX 1600? È basata su due GPU, TU117 (GTX 1650) e TU116 (gli altri quattro modelli). La prima occupa 200 mm2 e integra 4,7 miliardi di transistor, mentre la seconda sale a 284 mm2 e 6,6 miliardi di transistor.

| GPU | CUDA core | Bus | Memoria | |

| GeForce GTX 1660 Ti | TU116 | 1536 | 192 bit | GB GDDR6 |

| GeForce GTX 1660S | TU116 | 1408 | 192 bit | 6 GB GDDR6 |

| GeForce GTX 1660 | TU116 | 1408 | 192 bit | 6 GB GDDR5 |

| GeForce GTX 1650S | TU116 | 1280 | 128 bit | 4 GB GDDR5 |

| GeForce GTX 1650 | TU117 | 896 | 128 bit | 4 GB GDDR5 |

La GTX 1650 si è presentata sul mercato con un chip dotato di 896 CUDA core, 56 TMU e 32 ROPs, affiancato da 4 GB di memoria GDDR5 su bus a 128 bit. La sorella maggiore SUPER, forte della GPU differente, conta 1280 CUDA core, 80 TMU e 32 ROPs: bus e quantità di VRAM sono gli stessi, ma cambia il tipo, con il passaggio alla GDDR6. La GTX 1660 e GTX 1660 SUPER sono praticamente identiche, cambia il tipo di memoria, da GDDR5 a GDDR6: la GPU offre 1408 CUDA core, 88 TMU e 48 ROPS. Il bus di memoria è a 192 bit. Infine, la GTX 1660 Ti vanta 1536 CUDA core, 96 TMU e 48 ROPs, sempre con 6 GB di memoria GDDR6 a 192 bit.

GeForce RTX 3000, con Ampere ecco il ray tracing di seconda generazione

L'architettura Ampere, che potete approfondire in questo articolo, è l'ultimo progetto di Nvidia, introdotto verso la fine 2020 per spingere molto più in alto le prestazioni di calcolo e in particolare migliorare la gestione del ray tracing. Risultato raggiunto, grazie a un rinnovamento profondo di tutte le unità di calcolo alla base delle GPU: shader, RT core e Tensor core. Gli ultimi due, in particolare, sono molto più efficienti e potenti e questo ha permesso a Nvidia di inserirne di meno per SM. Da Turing ad Ampere è inoltre cambiato il processo produttivo, con il salto dai 12 nm di TSMC agli 8 nm custom di Samsung.

Nvidia ha introdotto finora cinque modelli di GeForce RTX 3000 basati su tre differenti GPU: GA102 per RTX 3090 e 3080, GA104 per RTX 3070 e RTX 3060 Ti e infine GA106 per l'ultima RTX 3060 12GB. Il GA102 è un chip che in un'area di 628 mm2 ospita 28,3 miliardi di transistor. Né la RTX 3090 né tantomeno la RTX 3080 adottano la configurazione completa di questo chip. La RTX 3090 conta su 10496 CUDA core, 329 TMU, 112 ROPS, 328 Tensor Core e 82 RT core. La scheda, maggiormente votata a chi fa rendering e ha bisogno di molta memoria, offre 24 GB di GDDR6X su bus a 384 bit.

La RTX 3080 ha specifiche decisamente inferiori alla 3090, ma in gaming la differenza tra le due schede è più contenuta di quanto possiate pensare. La 3080 ha 8704 CUDA core, 272 TMU e 96 ROPs, mentre Tensor core e RT core scendono rispettivamente 272 e 68 unità. La scheda ha inoltre "solo" 10 GB di memoria GDDR6X su bus a 320 bit.

| GPU | CUDA core | RT core | Tensor Core | Bus | Memoria | |

| GeForce RTX 3090 | GA102 | 10496 | 82 | 328 | 384 bit | 24 GB GDDR6X |

| GeForce RTX 3080 | GA102 | 8704 | 68 | 272 | 320 bit | 10 GB GDDR6X |

| GeForce RTX 3070 | GA104 | 5888 | 46 | 184 | 256 bit | 8 GB GDDR6 |

| GeForce RTX 3060 Ti | GA104 | 4864 | 38 | 152 | 256 bit | 8 GB GDDR6 |

| GeForce RTX 3060 | GA106 | 3584 | 28 | 112 | 192 bit | 12 GB GDDR6 |

La RTX 3070 è attualmente la scheda più potente basata su GPU GA104, ma anche in questo caso il chip - che occupa un'area di 392 mm2 e al suo interno ha 17,4 miliardi di transistor - non è sfruttato al massimo delle sue risorse. La versione a bordo della scheda ha 5888 CUDA core attivi, 184 TMU, 96 ROPs, 184 Tensor core e 46 RT core, mentre la memoria è pari a 8 GB GDDR6 su bus a 256 bit.

La RTX 3060 Ti è "castrata" ulteriormente e figura 4864 CUDA core, 152 TMU e 80 ROPs, insieme a 152 Tensor core e 38 RT core. La configurazione di memoria è invece invariata. La RTX 3060 è basata su un chip chiamato GA106 con 12 miliardi di transistor (276 mm2) che prevede 3584 CUDA core, 112 TMU e 48 ROPs. Anche il numero di Tensor core e RT core è decisamente inferiore a quello della RTX 3060 Ti, fermandosi rispettivamente a 112 e 28. La scheda è stata dotata da Nvidia con 12 GB di memoria GDDR6 su bus a 192 bit. Una scelta, quella dei 12 GB, che Nvidia non ha spiegato fino in fondo se non rendere la scheda polivalente anche per chi fa il creator, ma in realtà ha un valore principalmente competitivo rispetto alle schede di prossima uscita di AMD.

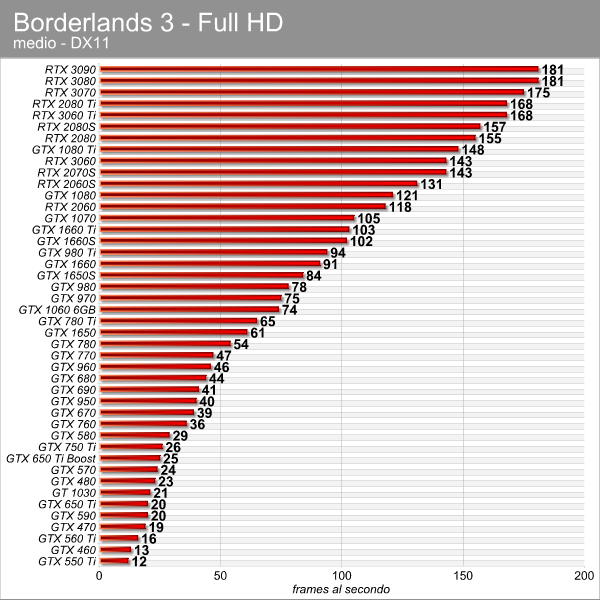

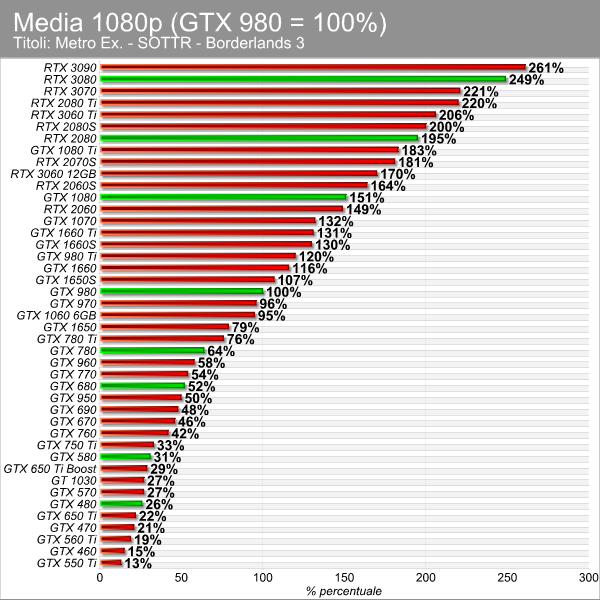

Prestazioni 1080p

Iniziamo questo viaggio nel tempo osservando le prestazioni in Full HD con Borderlands 3, dove vediamo subito il duo che chiuderà quasi tutte le classifiche, stiamo parlando della GTX 550 Ti e della GTX 460. Possiamo notare come la dual-GPU GTX 590 si comporti piuttosto male nonostante il potenziale tecnico a sua disposizione, a dimostrazione che lo SLI necessitava di un supporto sia lato driver che da parte del gioco per restituire i risultati ottimali. Maluccio anche la GTX 690, sempre con due GPU su un unico PCB.

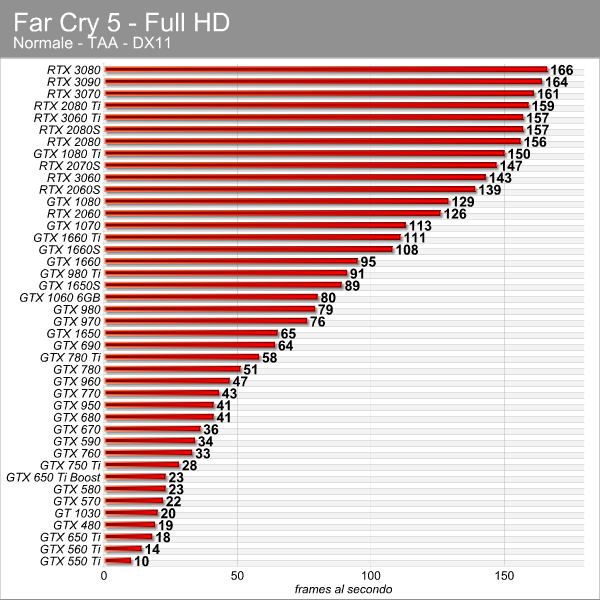

È interessante vedere la GTX 1650 Turing piazzarsi poco sopra la GTX 780, una delle schede top di gamma del 2013, con la variante SUPER al livello della GTX 980 Ti. Per il resto, non ci sono grandissime sorprese, almeno per chi segue il mercato delle GPU da diversi anni: la GTX 1060 al livello della GTX 970, la GTX 1080 e la RTX 2060 praticamente affiancate. Di fatto in 10 anni siamo passati da 12 a 180 fps circa, un boost prestazionale di quasi il 1400%! Passiamo a Far Cry 5.

In questo caso dobbiamo segnalare l'assenza di due modelli tra i più vecchi, la GTX 460 e la GTX 470, ai quali per qualche ragione è risultato indigesto Far Cry 5. In ultima posizione troviamo quindi la GTX 550 Ti con 10 fps, mentre al vertice c'è la RTX 3080/3090 (164 e 166 fps sono differenze intestabili alle singole run, vanno uguali) per un boost prestazionale superiore al 1500%. Da rilevare in questo titolo il buon comportamento delle schede dual-GPU, la GTX 590 e la GTX 690, che superano nettamente le rispettive varianti a singola GPU.

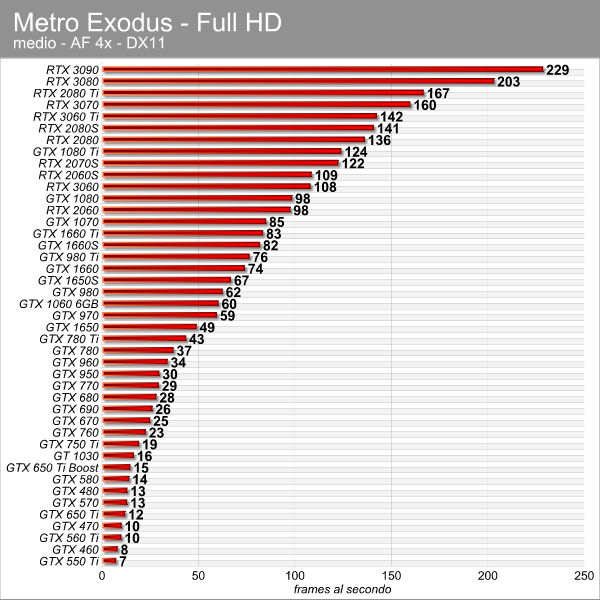

In Metro Exodus l'unica scheda che non siamo riusciti a testare è stata quella GeForce GTX 590. Trattandosi di un gioco ancora più probante rispetto ai precedenti, il titolo di 4A Games vede tra l'ultima scheda e la prima una differenza superiore al 3000%. Qui la RTX 3090 stacca la RTX 3080 del 12% circa, e la RTX 2080 Ti riesce a mettere il naso sopra la RTX 3070.

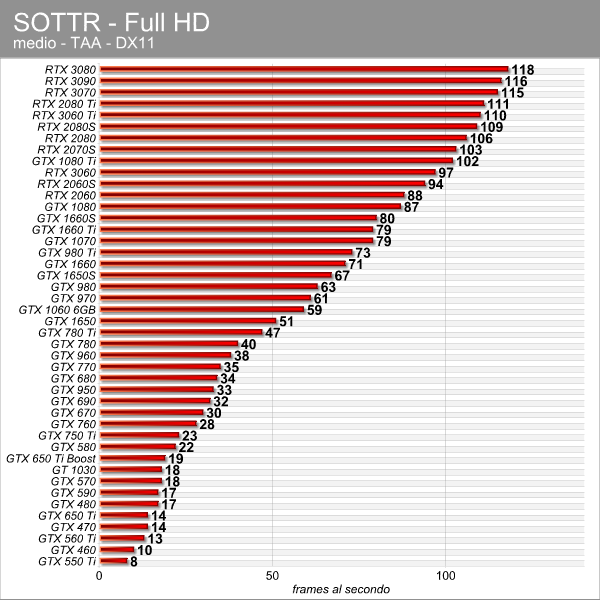

Chiudiamo i test in Full HD con Shadow of the Tomb Raider, dove il gap tra prima e ultima è di oltre il 1300%. La situazione è simile a quella vista in Borderlands 3 e Far Cry 5, con le schede dalla GTX 1080 Ti a salire con prestazioni che non scalano più così tanto.

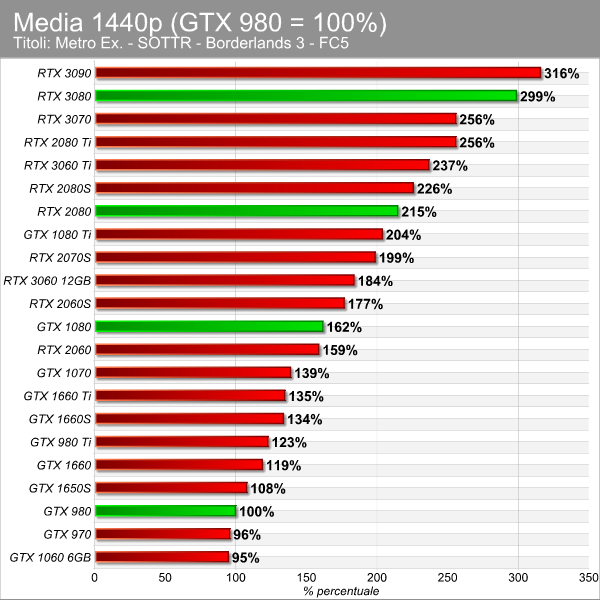

Prestazioni 1440p

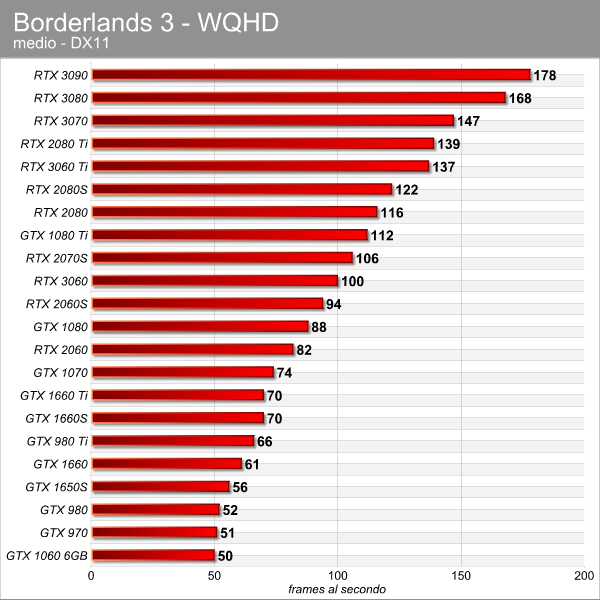

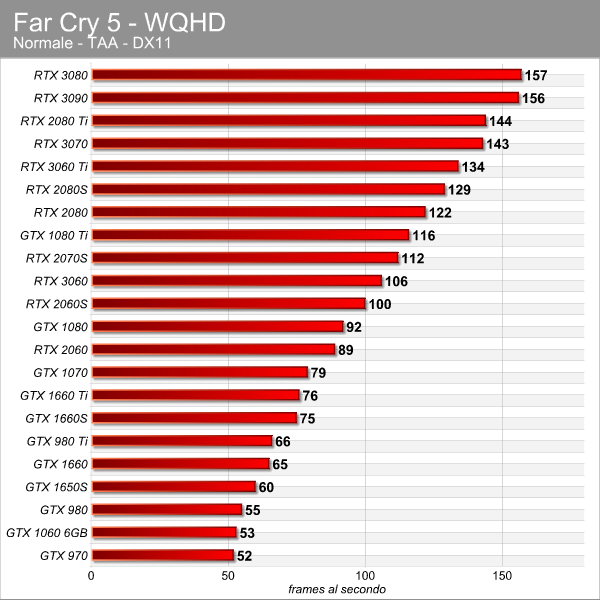

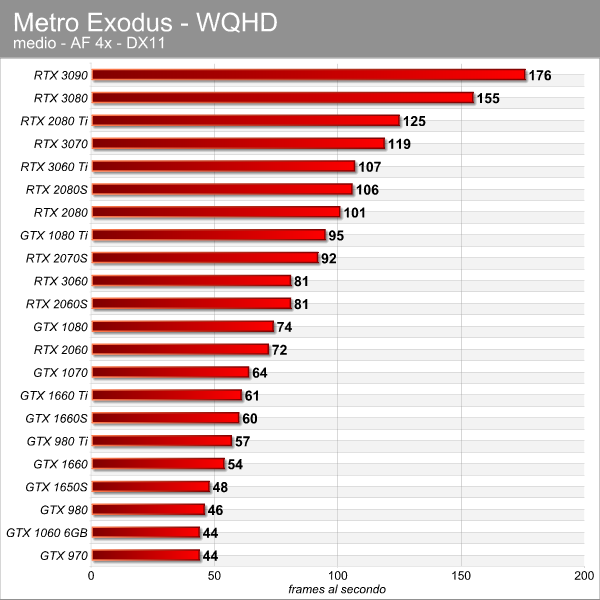

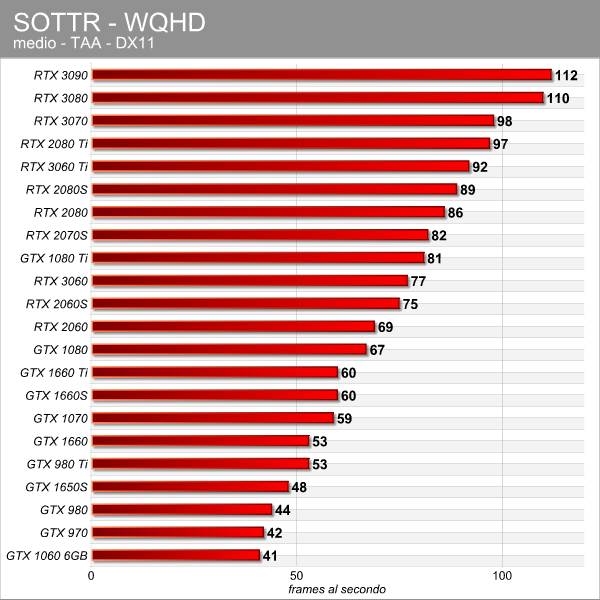

Le prove in WQHD prevedono una schiera minore di schede: se in Full HD aveva senso testarle tutte sia perché si tratta della risoluzione più diffusa, sia per avere un quadro dei progressi negli ultimi 10 anni, con il 1440p siamo partiti dalla GeForce GTX 970 per arrivare ai modelli dei giorni nostri.

In Borderlands 3 vediamo tre schede video appaiate sul fondo della classifica - GTX 1060, GTX 970 e GTX 980. Tra la GeForce GTX 1060 e l'attuale top di gamma RTX 3090 osserviamo un balzo prestazionale del 250% circa, che scende al 200% per quanto riguarda Far Cry 5.

In Metro Exodus il gap prestazionale tra la prima e ultima soluzione sale al 300%, da 44 a 176 fps. La GTX 980 Ti, portabandiera dell'era Maxwell, è tra la GTX 1660 e la GTX 1660 SUPER, le schede Turing di scorsa generazione prive di unità per accelerare il ray tracing. La GTX 1080 Ti, invece, si posizionata tra la RTX 2070 SUPER e la RTX 2080.

Chiudiamo come sempre con Shadow of the Tomb Raider, dove osserviamo un andamento peggiore di alcune GPU basate su architettura Pascal. Il gap tra la prima e l'ultima soluzione in classifica si assesta intorno al 173%.

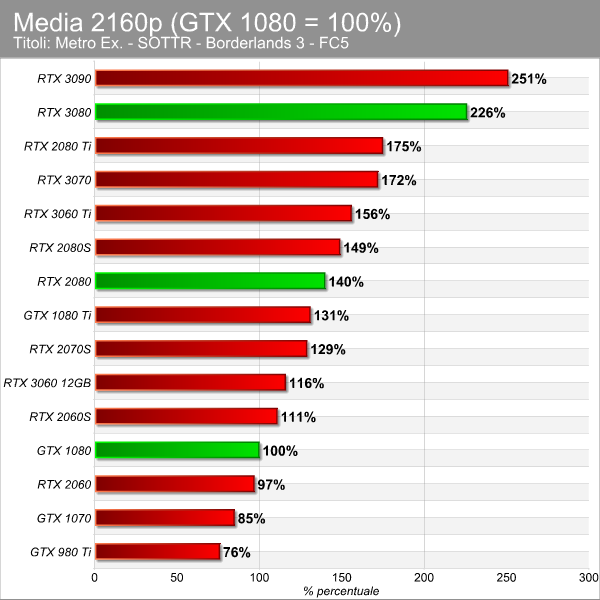

Prestazioni 4K

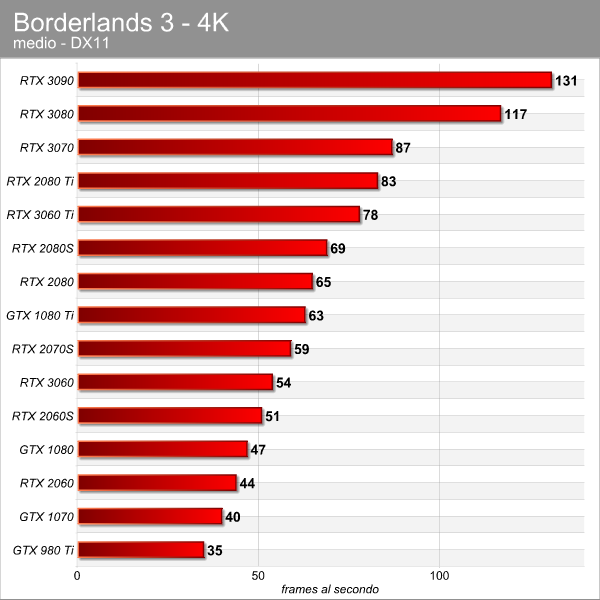

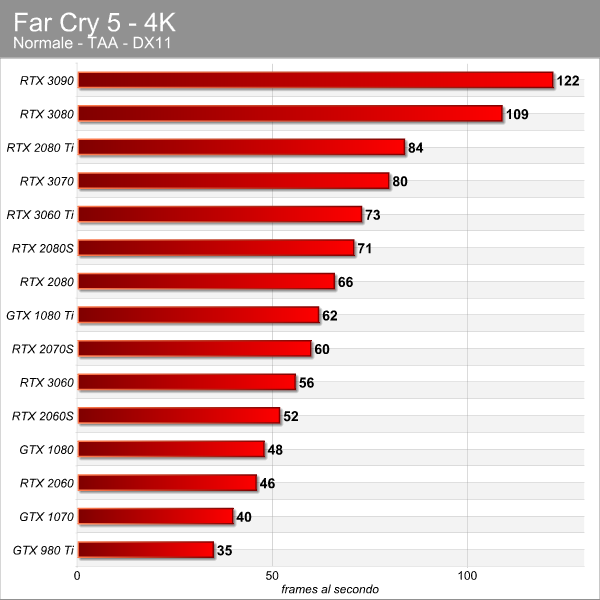

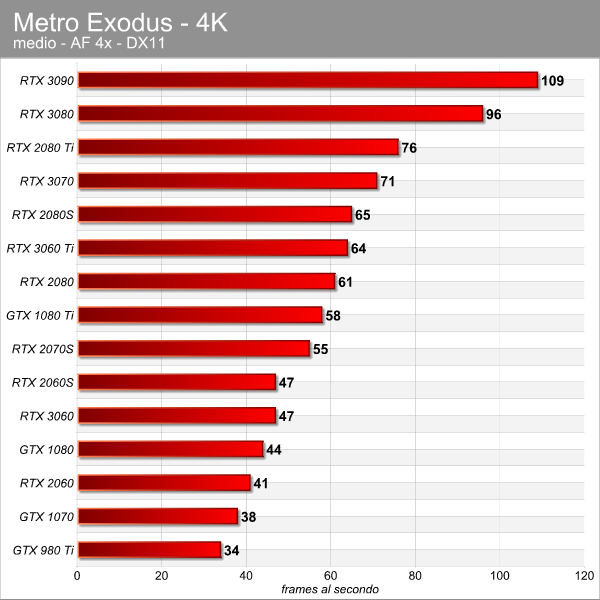

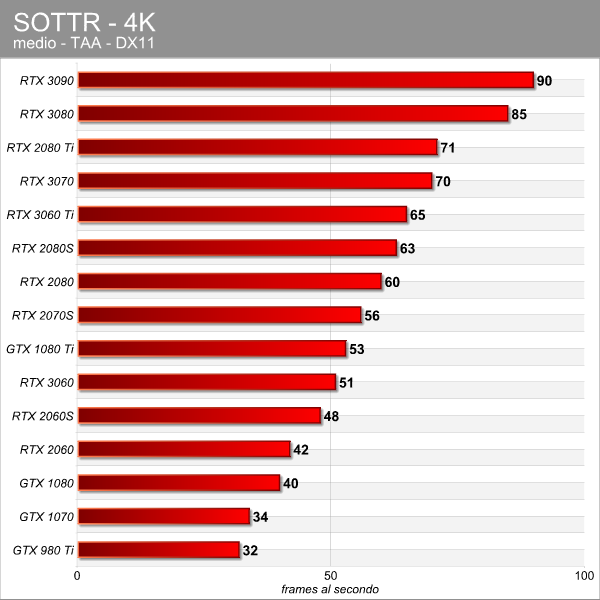

Arriviamo al 4K, risoluzione dove la gamma di schede è ancora più limitata. In questo caso partiamo dalla GTX 980 Ti, portabandiera dell'era Maxwell, per arrivare ai giorni nostri.

In Borderlands 3 le schede fino alla RTX 2070 Super sono sotto i 60 fps. Nel caso della serie RTX 3000, la RTX 3060 Ti offre un livello prestazionale simile a quello delle proposte RTX 2080/2080S, a testimonianza dello scatto in avanti dell'architettura Ampere.

In Far Cry 5 osserviamo un comportamento simile, con la RTX 2080 Ti che sopravanza la RTX 3070, forte probabilmente dei 3 GB di memoria in più che le conferiscono un leggero vantaggio.

In Metro Exodus c'è un distacco del 220% tra la prima e l'ultima scheda in classifica, e anche in questo la top di gamma di precedente generazione si posiziona poco davanti alla RTX 3070. La GTX 1080 Ti, portabandiera dell'era Pascal, si mantiene sopra la RTX 2070 Super.

In Tomb Raider osserviamo una differenza del 180% tra la GTX 980 Ti e la RTX 3090. La RTX 3060 tallona la GTX 1080 Ti, che in questo caso è dietro la RTX 2070 Super, dimostrando che il titolo di Square Enix gradisce leggermente di più le architetture più recenti.

Sintetici

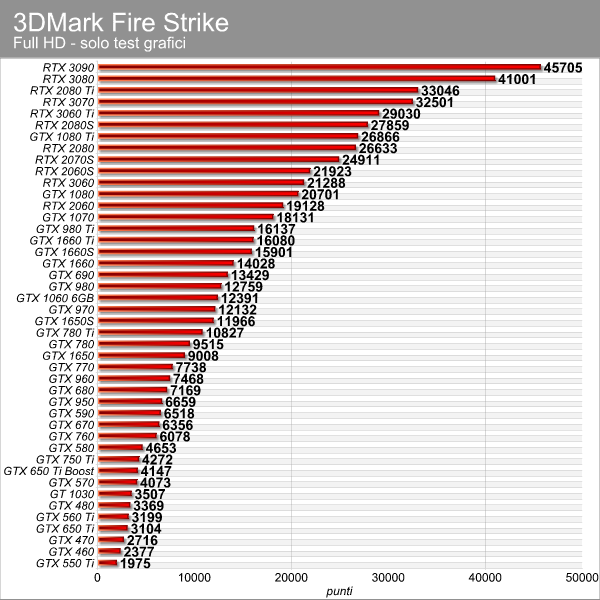

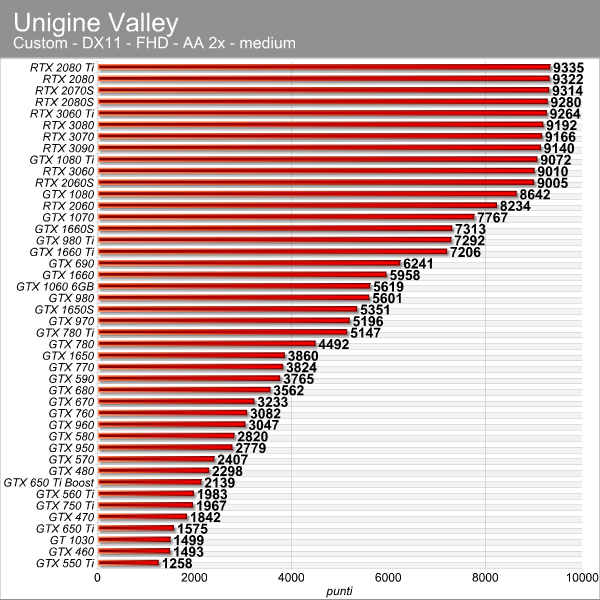

Non vi nascondiamo che eravamo un po' combattuti alla fine dei test se pubblicare anche i dati raccolti nei benchmark sintetici, ma alla fine abbiamo deciso di procedere lo stesso più che altro per mostrarvi due punti fondamentali: testare una scheda video con test troppo vecchi, come Unigine Valley, a un certo punto non restituisce più uno scaling prestazionale, anzi abbiamo registrato risultati evidentemente sballati che vedono le più potenti schede video Ampere arretrare e raggiungere valori inconsistenti. Per quanto riguarda il benchmark 3DMark, invece, è utile soprattutto per vedere le potenzialità delle due dual-GPU GTX 590 e 690: avrebbero potuto dare molto di più, se solo lo SLI fosse stato supportato a dovere dall'intera comunità del gaming.

Evoluzione prestazioni serie 60

Dopo i grafici di ogni gioco suddivisi per risoluzione, isoliamo le tre serie caratteristiche di Nvidia in questi 10 anni, ovvero la serie xx60, la xx70 e la xx80. Le schede xx90 sono sporadiche nella nomenclatura di Nvidia, quindi abbiamo optato per lasciare quei modelli da parte. Partiamo per l'appunto dalla serie 60, osservando i miglioramenti compiuti in un decennio per ogni risoluzione. Nel caso della risoluzione Full HD, poiché la GTX 460 che rappresenta la base 100% è andata in crash con FC5, la media è parametrata sui restanti tre test. Si può vedere come dalla GTX 460 all'attuale RTX 3060 Ti le prestazioni siano crescite di quasi il 1400%.

Passando al 1440p (questa volta la media riguarda i quattro giochi) si osserva il balzo del 25% dalla GTX 1060 alla GTX 1660, che sale al 42% per la GTX 1660 Ti. La RTX 3060, che oggi rappresenta la soluzione basate per adottare l'architettura Ampere, è quasi il doppio più veloce della popolare scheda Pascal. Infine, per quanto concerne il 4K, ci siamo limitati a testare dalla RTX 2060 alla RTX 3060 Ti, rilevando un boost del 38%.

| Full HD | 1440p | 4K | |

| GTX 460 - GTX 560 Ti | +26% | ||

| GTX 560 Ti - GTX 760 | +68% | ||

| GTX 760 - GTX 960 | +39% | ||

| GTX 960 - GTX 1060 | +66% | ||

| GTX 1060 - GTX 1660 Ti | +38% | +42% | |

| GTX 1660 Ti - RTX 2060S | +25% | +31% | |

| RTX 2060S - RTX 3060 Ti | +22% | +31% | +17% |

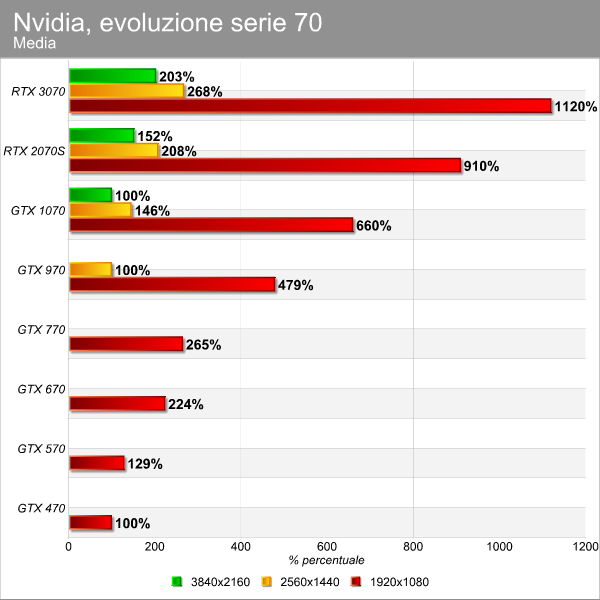

Evoluzione prestazioni serie 70

Passando alla serie 70 e al Full HD, osserviamo come dalla GTX 470 alla GTX 570, entrambe basate su architettura Fermi, Nvidia sia riuscita a migliorare le prestazioni del 29%, segno che i correttivi a Fermi funzionarono. Un balzo in avanti netto lo si vede da Fermi a Kepler (serie 600). Dopodichè osserviamo una progressione con il balzo più deciso dalla GTX 770 alla GTX 970 (Kepler - Maxwell).

Passando alla risoluzione 1440p, vediamo che dalla scheda GeForce GTX 970 Nvidia sia riuscita a incrementare le prestazioni del 46% con la GTX 1070, per arrivare a un +62% con la RTX 3070. Infine, il 4K: qui il lotto di schede provate a tale risoluzione è risicato, con il gap tra la GTX 1070 e la RTX 3070 che tocca un +103%.

| Full HD | 1440p | 4K | |

| GTX 470 - GTX 570 | +29% | ||

| GTX 570 - GTX 670 | +73% | ||

| GTX 670 - GTX 770 | +18% | ||

| GTX 770 - GTX 970 | +80% | ||

| GTX 970 - GTX 1070 | +37% | +46% | |

| GTX 1070 - RTX 2070S | +37% | +43% | +52% |

| RTX 2070S - RTX 3070 | +22% | +29% | +34% |

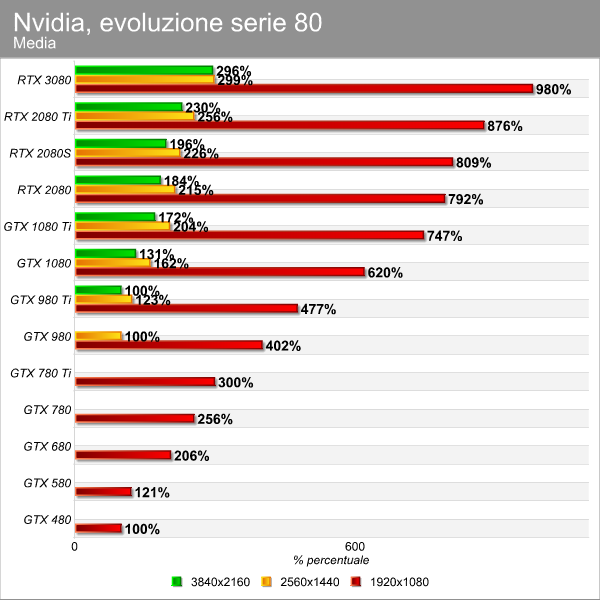

Evoluzione prestazioni serie 80

Avevamo senza dubbio più schede della serie 80 nel nostro laboratorio che versioni 70, quindi ecco un maggior numero di modelli a confronto. Un balzo del 21% tra la GTX 480 e la GTX 580 sembra quasi replicare quello visto tra la GTX 470 e la GTX 570 per quanto riguarda la risoluzione Full HD. Assistiamo un forte passo in avanti delle prestazioni dalla GTX 580 alla GTX 680 e lo stesso possiamo dire tra la GTX 780 Ti e la GTX 980. Anche la GTX 1080 Ti registra un netto incremento rispetto alla GTX 980 Ti. Il balzo è poi decisamente evidente prendendo la RTX 3080 e relazionandola con la RTX 2080 Ti.

I test in 1440p che hanno come base la GTX 980 ci mostrano ancora una volta il perché la serie GTX 1000 sia stata così popolare, con un balzo del 62% dalla 980 alla 1080. E un altro incremento importante lo si nota tra la RTX 2080 Ti e la RTX 3080. Un'altra cosa che emerge, in relazione al 4K, è come la RTX 3080 non sembri per nulla soffrire il cambio di risoluzione a impostazione media, segno delle grandi capacità dell'architettura Ampere nella gestione del 4K, almeno per le proposte top di gamma.

| Full HD | 1440p | 4K | |

| GTX 480 - GTX 580 | +21% | ||

| GTX 580 - GTX 680 | +72% | ||

| GTX 680 - GTX 780 Ti | +45% | ||

| GTX 780 Ti - GTX 980 Ti | +58% | ||

| GTX 980 Ti - GTX 1080 Ti | +56% | +66% | +72% |

| GTX 1080 Ti - RTX 2080 Ti | +16% | +25% | +33% |

| RTX 2080 Ti - RTX 3080 | +10% | +17% | +29% |

Quale generazione ha fatto il salto più grande?

Nvidia afferma che il balzo da Turing ad Ampere rappresenta il passo avanti più importante in termini di prestazionali mai ottenuto da una generazione all'altra, ma è quello che dice Nvidia e certamente non in tutti gli scenari è vero. Bisogna poi sempre determinare quali sono gli effettivi elementi di paragone. L'azienda statunitense dichiara che la "RTX 3080 fornisce fino a due volte le prestazioni della RTX 2080, offrendo il più grande salto generazionale mai realizzato da qualsiasi GPU". Dai grafici e dalle tabelle qui sopra non sembrerebbe proprio, ma si potrebbe obiettare che abbiamo rapportato la 3080 con la 2080 Ti. Mettiamo quindi a confronto i modelli 80 senza "Ti" o altro.

| Full HD | 1440p | 4K | |

| GTX 480 vs GTX 580 | +21% | ||

| GTX 580 vs GTX 680 | +72% | ||

| GTX 680 vs GTX 780 | +24% | ||

| GTX 780 vs GTX 980 | +56% | ||

| GTX 980 vs GTX 1080 | +54% | +62% | - |

| GTX 1080 vs RTX 2080 | +27% | +33% | +40% |

| RTX 2080 vs RTX 3080 | +21% | +39% | +61% |

Finalmente ecco che spunta una vittoria per Ampere, in 4K, con la RTX 3080 che sopravanza la RTX 2080 del 61%. Basta per definirlo "il più grande salto generazionale mai realizzato da qualsiasi GPU"? Per Nvidia sì, e anche per noi potrebbe bastare. Il punto è che Ampere rappresenta un forte passo avanti, senza dubbio, ma dobbiamo anche pensare al fatto che il miglioramento su cui si è concentrata l'azienda è quello relativo alle prestazioni in 4K e con il ray tracing. La tabella più sopra ci mostra un incremento medio delle prestazioni fortissimo nel 4K in test senza ray tracing, e per essere certi di quanto registrato abbiamo preso la nostra solita suite di test e raffrontato le due schede lungo 12 giochi moderni a dettagli Ultra. Ecco cosa abbiamo rilevato, dapprima nei test senza RTX e poi in tre titoli (Contro, Wolfenstein Youngblood e Control) con ray tracing e DLSS attivi:

| Full HD | 1440p | 4K | |

| RTX 2080 vs RTX 3080 (raster) | +44% | +57% | +76% |

| RTX 2080 vs RTX 3080 (RTX + DLSS) | +42% | +64% | +94% |

Questo cosa vuol dire? Semplicemente che ogni architettura è figlia del suo tempo e anche se abbiamo visto incrementi importanti da Fermi a Kepler, o da Maxwell a Pascal, Ampere è senza dubbio quella che ha registrato i passi avanti più grandi in termini di potenza grafica in tutta la storia delle schede video con GPU Nvidia. Non bisogna dimenticare che Nvidia è riuscita a offrire prestazioni nel gaming 4K tradizionale senza precedenti, implementando al tempo stesso un ray tracing efficiente con l'ausilio del DLSS.

DirectX 11 vs 12

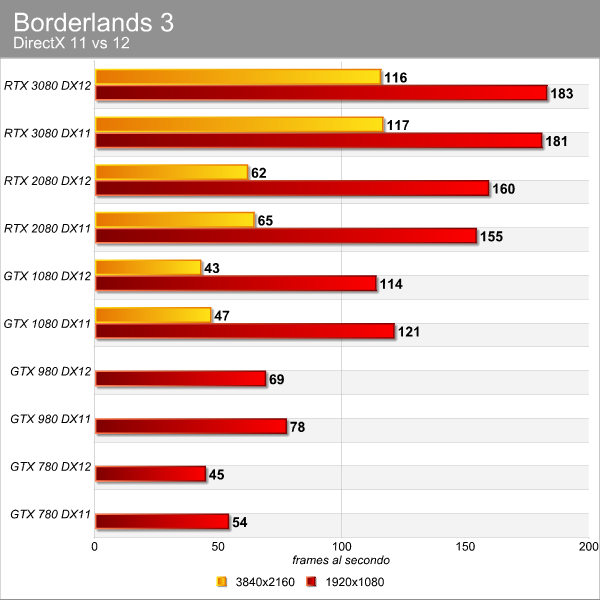

Poiché tutte le prove sono state svolte in DX11 per uniformità tra schede video vecchissime e recenti, abbiamo eseguito anche alcuni test con le DirectX 12 con tre titoli - Borderlands 3, Metro e Shadow of the Tomb Raider (FC5 è DX 11, non consente di cambiare API) - con le ultime cinque generazioni di schede. Una prova in più, per curiosità e completezza. Si può notare come in Borderlands 3 non cambi nulla passando tra le due API con le varie GPU, anche se per quelle più datate si nota un leggero calo passando alle DX12.

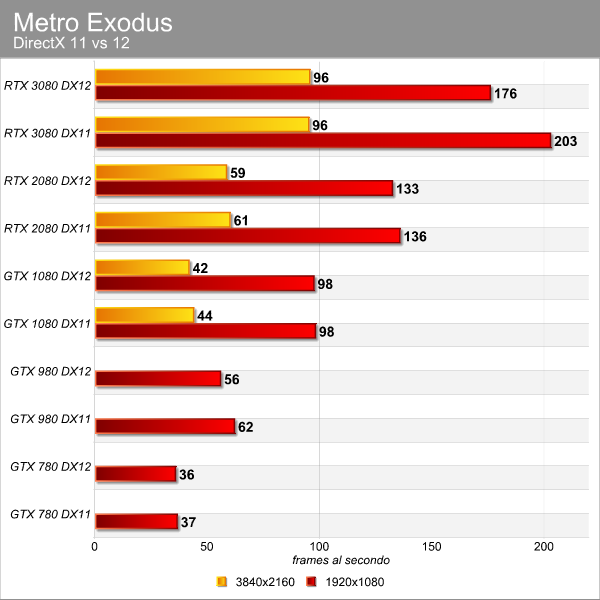

Passando a Metro Exodus, vediamo come in Full HD la RTX 3080 perda molto passando alle API DirectX 12. Un comportamento piuttosto strano, ma chiaramente ogni gioco è realizzato in modo diverso e il titolo di 4A Games reagisce così.

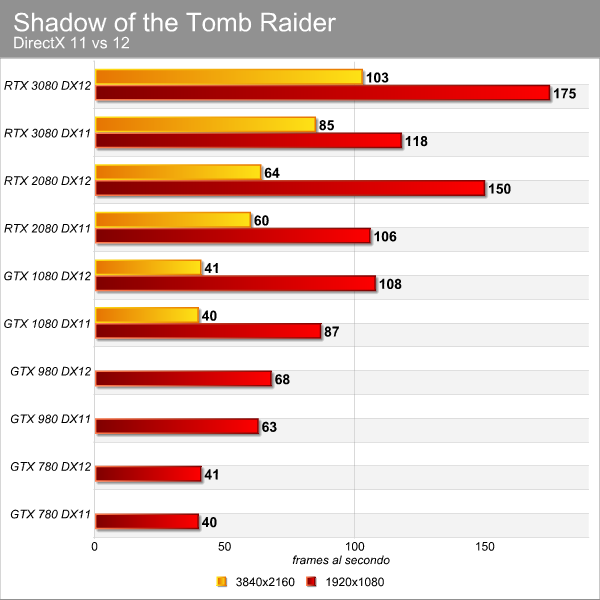

In Shadow of the Tomb Raider vediamo il comportamento esattamente opposto a quello di Metro Exodus, con la RTX 3080 che beneficia enormemente delle API DirectX 12. Lo stesso è vero anche per l'architettura Turing e Pascal, mentre per quanto riguarda Maxwell e Kepler la situazione è di sostanziale parità.

Ray tracing

Chiudiamo i test con un grafico dedicato al ray tracing e al DLSS. Nel 2018 Nvidia ha introdotto queste due tecnologie, al fine di migliorare ulteriormente la grafica su PC. Il ray tracing riproduce in modo fedele ombre, luci, rifrazioni e altri effetti, mentre il DLSS ha il compito di garantire una qualità di immagine del tutto simile a quella richiesta dal giocatore - per esempio 4K, Ultra con RTX attivo - salvaguardando le prestazioni.

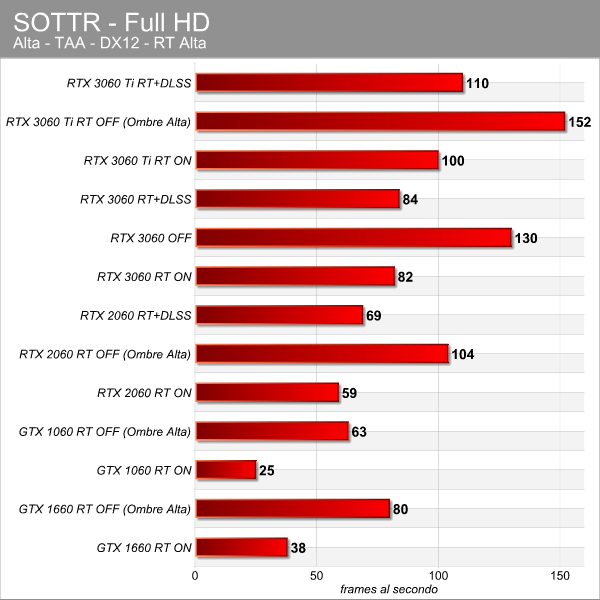

Poiché in questa prova avevamo solo due test con il ray tracing, ma Metro ha un supporto tutto suo all'abilitazione di RTX e DLSS in contemporanea, abbiamo usato Shadow of the Tomb Raider. Non è certo uno dei casi limite d'uso del ray tracing, infatti lo applica alle ombre, ma comunque utile per evidenziare l'impatto del ray tracing su GPU con unità dedicate alla sua accelerazione e modelli privi di qualsiasi unità e che quindi devono ricorrere ai CUDA core per i calcoli.

Il grafico non ha bisogno di commenti: come potete vedere l'impatto dell'abilitazione del ray tracing sulla GTX 1660 e la GTX 1060, rispettivamente una GPU Turing priva di unità dedicate a RT e DLSS e una proposta Pascal precedente, è incredibile. Non ha alcun senso anche solo pensare di attivare il ray tracing su tali GPU, seppur sia possibile. Con la RTX 2060 e le più recenti soluzioni 60 della gamma RTX 3000, vediamo il forte impatto del ray tracing e come l'intervento del DLSS sia salutare. Certo, non è così vero con l'architettura Ampere in quanto probabilmente il gioco non rappresenta un grande carico, ma comunque la RTX 3060 Ti guadagna 10 fps con il DLSS.

Conclusioni

Per riepilogare, chi segue costantemente le nostre recensioni o ha semplicemente letto l'articolo sulle quattro generazioni di Ryzen a confronto, non può far altro che concordare con noi se diciamo che il salto prestazionale garantito da una generazione all'altra di GPU è decisamente superiore a quanto visto nel passaggio da una famiglia di CPU a quella successiva.

Dal 2017, in particolare negli ultimi due anni, AMD ha dato una scossa al settore dei microprocessori rispetto agli anni precedenti, ma il paragone con le architetture grafiche rimane impari. In questi ultimi 10 anni non sempre abbiamo assistito a salti in avanti quantici, ma senza dubbio non c'è di che lamentarsi.

Per questa ragione l'aggiornamento di un PC gaming vede soprattutto nella scheda video il componente sostituito con maggiore frequenza; una volta acquistata una CPU con buone prestazioni in gaming, possono passare anche 5 anni prima di sentire la necessità di un aggiornamento.

Per la GPU è diverso: aggiornarla con una buona cadenza - diciamo ogni 2 - 2,5 anni - restituisce progressi notevoli sotto il profilo delle prestazioni (fps) in relazione alle risoluzioni e al livello di dettaglio. Inoltre, i produttori propongono con maggiore frequenza novità in grado di incidere sull'esperienza finale, come nel caso del ray tracing o della realtà virtuale.

Nel corso dei test abbiamo visto come il Full HD, ormai la risoluzione "di base" per il PC gaming - gestita senza grandi difficoltà da tutta la lineup di Nvidia - risulti mal digerita fino al 2014, ma dalle schede GeForce GTX 900 è stato un crescendo di prestazioni, fino all'ottima gestione del 4K da parte delle attuali RTX 3000 di fascia alta. Nvidia si è addirittura spinta a parlare di 8K, ma come visto in un precedente test è un po' (un bel po') una forzatura.

Abbiamo compilato tre grafici che mostrano le medie ottenute alle varie risoluzioni dalle diverse schede, evidenziando con il colore verde i modelli delle serie 80 per darvi un riferimento visivo su ogni generazione. Nei grafici in Full HD e WQHD il 100% è rappresentato dalla GTX 980, mentre per il 4K la pietra di paragone è la GTX 1080.

A 1080p possiamo vedere che la GTX 480 Fermi una potenza pari al 26% della GTX 980 (Maxwell) e che la GTX 780 si ferma solo al 64%, segnalando quindi il salto tra Kepler e Maxwell. Ancora più netto il balzo tra Maxwell e Pascal (GTX 1080), con salti più o meno simili con Turing e Ampere. A 1440p esce fuori tutta la potenza di Ampere, ma anche il salto tra la GTX 980 e la 1080 è importante. Nel grafico relativo al 4K, le portabandiera della famiglia RTX 3000 volano essendo state specificatamente pensate per questa risoluzione.

Se quindi siete possessori di una scheda video Nvidia GeForce non di ultima generazione avete a disposizione, con i dati di questo articolo, un quadro chiaro di quello che potete ottenere aggiornando la vostra scheda video. E da questo meglio capire se l'investimento richiesto sia o meno sensato.

BOOX Note Air4 C è uno spettacolo: il tablet E Ink con Android per lettura e scrittura

BOOX Note Air4 C è uno spettacolo: il tablet E Ink con Android per lettura e scrittura Recensione Sony Xperia 1 VII: lo smartphone per gli appassionati di fotografia

Recensione Sony Xperia 1 VII: lo smartphone per gli appassionati di fotografia Attenti a Poco F7: può essere il best buy del 2025. Recensione

Attenti a Poco F7: può essere il best buy del 2025. Recensione DJI OSMO Mobile SE a 69€: il gimbal compatto che trasforma i video dello smartphone in riprese da pro

DJI OSMO Mobile SE a 69€: il gimbal compatto che trasforma i video dello smartphone in riprese da pro Scope elettriche da record su Amazon: due modelli potentissimi sotto i 120€, ecco perché piacciono così tanto

Scope elettriche da record su Amazon: due modelli potentissimi sotto i 120€, ecco perché piacciono così tanto GTA 6 a 80 euro? Take-Two frena sul prezzo e punta tutto sul valore percepito

GTA 6 a 80 euro? Take-Two frena sul prezzo e punta tutto sul valore percepito I 3 portatili più convenienti su Amazon: sono 2 tuttofare Lenovo e un HP Victus gaming con RTX 5060

I 3 portatili più convenienti su Amazon: sono 2 tuttofare Lenovo e un HP Victus gaming con RTX 5060 AirPods Pro 2 a soli 199€: su Amazon anche AirPods 4 in sconto, ecco le differenze che contano

AirPods Pro 2 a soli 199€: su Amazon anche AirPods 4 in sconto, ecco le differenze che contano 2 Smart TV 4K Hisense con doppio sconto su Amazon: sono OLED e QLED, 55" e 75", fateci un bel pensierino

2 Smart TV 4K Hisense con doppio sconto su Amazon: sono OLED e QLED, 55" e 75", fateci un bel pensierino Portatili Apple ai minimi: MacBook Pro con chip M4 a 1.648€ e Macbook Air 13 16GB7256GB, sempre M4, a 998€

Portatili Apple ai minimi: MacBook Pro con chip M4 a 1.648€ e Macbook Air 13 16GB7256GB, sempre M4, a 998€ Come mantenere Windows 10 sicuro dopo il 2025: tutto sul programma ESU

Come mantenere Windows 10 sicuro dopo il 2025: tutto sul programma ESU Finalmente è tornato su Amazon l'iPhone 16 128GB a 749€, in tutti i colori, ma ci sono anche i 16e e 16 Pro in offerta

Finalmente è tornato su Amazon l'iPhone 16 128GB a 749€, in tutti i colori, ma ci sono anche i 16e e 16 Pro in offerta Auto nuove? Per il 65% degli italiani sono troppo care, non dovrebbero costare oltre i 20.000 euro

Auto nuove? Per il 65% degli italiani sono troppo care, non dovrebbero costare oltre i 20.000 euro Droni solari Airbus volano nella stratosfera grazie alle nuove batterie al silicio: test riusciti a oltre 20 km di quota

Droni solari Airbus volano nella stratosfera grazie alle nuove batterie al silicio: test riusciti a oltre 20 km di quota Colpo da 15 milioni di dollari: chi ha rubato un carico di prodotti AMD e Apple?

Colpo da 15 milioni di dollari: chi ha rubato un carico di prodotti AMD e Apple? Elon Musk lancia l'allarme su GPT-5: 'OpenAI divorerà Microsoft'. Ma Nadella lo sfida con un sorriso

Elon Musk lancia l'allarme su GPT-5: 'OpenAI divorerà Microsoft'. Ma Nadella lo sfida con un sorriso iPhone 17 Pro sarà più costoso, ma anche più conveniente

iPhone 17 Pro sarà più costoso, ma anche più conveniente

52 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infobellissimo articolo, coi grafici leggibili

mo lo spulcio a modo.

grazie!

Bell'articolo

Concordo confermo e sottoscrivo.

Spesso mi lamento degli articoli modello novella 3000, ma qui un applauso ci sta tutto !

Guardando gli ultimi tre grafici, la vera vincitrice per me e' la 3080, a 4K distanzia nettamente tutte le generazioni precedenti e la 3070 e si avvicina alla 3090. Il costo della 3090 non giustifica l'incremento di prestazioni.

quando ho assemblato il vecchio pc nel 2011 ero indeciso tra una 560 Ti e la 6950 2GB che poi ho comprato.

A quel tempo andavano uguale e costavano più o meno uguale, ma la AMD è invecchiata meglio per via dei 2GB di VRAM rispetto alla controparte verde

Costavano entrambe sui 200-250 euro, adesso non ci prendi neanche una 1050ti

Mi godrò questa interessantissima lettura questa sera!

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".