Intel: i 14nm a partire dal 2013, dal 2015 allo studio i 10 nanometri

Il colosso di Santa Clara delinea la tabella di marcia per i prossimi anni: produzione a 14nm dalla fine del 2013, mentre ricerca e sviluppo per 10, 7 e 5 nanometri a partire dal 2015

di Andrea Bai pubblicata il 15 Settembre 2012, alle 09:31 nel canale ProcessoriIntel

L'annuale appuntamento dell'Intel Developer Forum a San Francisco rappresenta sempre un'interessante occasione per gettare uno sguardo a "ciò che verrà dopo", per provare a leggere come potrà cambiare il palcoscenico della tecnologia nel corso dei prossimi anni.

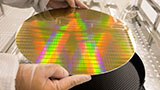

In questa edizione Intel ha rivelato i propri piani per il passaggio alle tecnologie di processo produttivo a 14 nanometri e oltre: il colosso di Santa Clara prevede di avviare la produzione a 14 nanometri di processori e SoC per la fine del 2013 e solo successivamente di avviare le attività di ricerca e sviluppo per i processi più avanzati.

In quest'ottica Intel continuerà a stanziare investimenti per le fabbriche D1X in Oregon, Fab 42 in Arizona e Fab 24 in Irlanda che si dedicheranno proprio alla produzione ai nodi di processo a 14 nanometri, attualmente contrassegnati dai nomi in codice di P1271 e P1273, rispettivamente per CPU e per SoC.

Per quanto concerne invece le attività di sviluppo per i processi produttivi a 10 nanometri, 7 nanometri e 5 nanometri, Intel ha fissato nel 2015 il periodo in cui dare il via ai lavori. Chiaramente si tratta, in questo caso, di una finestra temporale indicativa dal momento che i piani futuri saranno soggetti alle naturali evoluzioni del mercato e dello scenario tecnologico e meglio definiti negli anni a venire.

Ricordiamo che nel corso del mese di maggio 2011 Intel ha annunciato il suo transistor tridimensionale Tri-Gate, un forte elemento di discontinuità con il passato dal momento che questo tipo di transistor consente ai processori di operare a tensioni inferiori e con minor dispersione di corrente, offrendo inoltre migliori prestazioni ed una maggior efficienza energetica. Il debutto dei transistor tri-gate si ebbe con i processori Intel Core basati su architettura Ivy Bridge, la cui produzione in volumi ha preso il via alla fine dello scorso anno.

Attenti a Poco F7: può essere il best buy del 2025. Recensione

Attenti a Poco F7: può essere il best buy del 2025. Recensione Recensione Samsung Galaxy Z Fold7: un grande salto generazionale

Recensione Samsung Galaxy Z Fold7: un grande salto generazionale  The Edge of Fate è Destiny 2.5. E questo è un problema

The Edge of Fate è Destiny 2.5. E questo è un problema TSMC produrrà a 2 nm anche in Arizona come a Taiwan?

TSMC produrrà a 2 nm anche in Arizona come a Taiwan?  Tesla vuole Musk a tutti i costi: proposto un pacchetto azionario da 29 miliardi

Tesla vuole Musk a tutti i costi: proposto un pacchetto azionario da 29 miliardi Spotify aumenta i prezzi: da 10,99 a 11,99 euro per l'abbonamento Premium Individual

Spotify aumenta i prezzi: da 10,99 a 11,99 euro per l'abbonamento Premium Individual Prezzi folli su AliExpress con Choice Day: le 10 offerte assolutamente da non perdere!

Prezzi folli su AliExpress con Choice Day: le 10 offerte assolutamente da non perdere! IA ed etica: Fastweb+Vodafone fra le prime realtà UE a sottoscrivere il Codice di Condotta europeo

IA ed etica: Fastweb+Vodafone fra le prime realtà UE a sottoscrivere il Codice di Condotta europeo Pannelli solari nuovi o riciclati? Questa ricerca dimostra che non ci sono differenze

Pannelli solari nuovi o riciclati? Questa ricerca dimostra che non ci sono differenze Instagram cambia le regole per i Live: non tutti gli account potranno trasmettere in diretta

Instagram cambia le regole per i Live: non tutti gli account potranno trasmettere in diretta Windows 11 SE addio: Microsoft stabilisce la data di fine supporto

Windows 11 SE addio: Microsoft stabilisce la data di fine supporto Kali Linux più facile su macOS grazie al supporto ai container

Kali Linux più facile su macOS grazie al supporto ai container È la fine per le antenne 5G? Al loro posto ci saranno questi dirigibili stratosferici

È la fine per le antenne 5G? Al loro posto ci saranno questi dirigibili stratosferici WhatsApp, una taglia da 1 milione di dollari su exploit zero-click: la sfida del Pwn2Own 2025

WhatsApp, una taglia da 1 milione di dollari su exploit zero-click: la sfida del Pwn2Own 2025 Sembrava spacciato, poi una bici elettrica è piovuta dal cielo e l'ha salvato

Sembrava spacciato, poi una bici elettrica è piovuta dal cielo e l'ha salvato Apple Watch Series 1 diventa obsoleto: attenti a fare confusione, però!

Apple Watch Series 1 diventa obsoleto: attenti a fare confusione, però! ho. Mobile, upgrade a 250 GB senza sovrapprezzo: ecco chi può attivarlo

ho. Mobile, upgrade a 250 GB senza sovrapprezzo: ecco chi può attivarlo

25 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infol'articolo messo cosi mi sembra fuorviante perche non è vero che la ricerca inizia solo nel 2015 sono gia svariati anni che si lavora per questo scopo e mica devono iniciare fra 2 anni, tutte le fasi sono sovrapposte e non si passa da una all'altra ma si parralelizza, quindi oggi che abbiamo cpu a 22nm l'intel ha gia prototipi a 14nm funzionanti cosa che ha gia detto di avere e mostrato e sta gia testando in laboratorio con cpu semplici come memorie sram con litografie < di 14nm.

Per il 10-5 nm serviranno nuove teconologie litografiche basate su EUV che sono in sviluppo perpetuo da quasi 10 anni ma dall'articolo invece sembra che devono appena iniziare, forse la traduzione dall'inglese ha tratto in inganno peche quello che viene scritto va in contrasto con quello che ha detto e mostrato l'intel ai vari IDF degli ultimi anni.

Se l'intel o qualsiasi altra ditta o fonderia inziasse realmente la ricerca solo nel 2015 significherebbe che avremmo il primo prodotto a 10nm molti ma molti anni dopo cosa ovviamente impossibile.

PS

Ho letto una decina di altri articoli della stessa sessione dell'idf è tutto l'hanno descritta in maniera diversa cioè nel 2015 è prevista l'uscita della litografia a 10nm non l'inizio della ricerca quella si è fatto prima e si sta fecendo ora , mi sembrava strano io IMHO correggerei l'articolo perche come ho notato certi utenti non esperti vengono tratti in inganno e si fanno idee sbagliate.

si cambia materiale!

14nm in anticipo del previsto allora?

sarebbe strafigo...

14nm e DDR4

Mi asupico che, per iniziare, si dia il via alla cooperazione, in ambito desktop, fra gpu integrata e discreta.

GPU discreta totalmente disattivata (zero consumi e ventola spenta) in ambito 2d/riproduzione 720p/1080p, ed attivata solo in 3d, il tutto in maniera trasparente per l'utente.

ma se uno non ha particolari esigenze di spazio, un 775 fa praticamente ancora le stesse cose di un 1155 con una manciata di Watt in più..

quindi boh, per gli utlilizzatori normali, ovvero la stragrande maggioranza dei consumatori che hanno un middletower sotto una scrivania, tutte ste innovazioni del processo produttivo (obbligatorie & necessarie all' evoluzione) risultano alla fin della fiera un po' inutili..

ma se uno non ha particolari esigenze di spazio, un 775 fa praticamente ancora le stesse cose di un 1155 con una manciata di Watt in più..

quindi boh, per gli utlilizzatori normali, ovvero la stragrande maggioranza dei consumatori che hanno un middletower sotto una scrivania, tutte ste innovazioni del processo produttivo (obbligatorie & necessarie all' evoluzione) risultano alla fin della fiera un po' inutili..

Appena uscì il 775 molti fecero simili discorsi "ma alla gente basta e avanza il 478, a che serve tutta questa evoluzione? Mha... è il solito marketing..."

Le ricerche continuano anche se agli utilizzatori normali va ancora bene il proprio PC sotto la scrivania.

La tendenza è sempre stata quella di rendere più efficiente l'architettura per realizzare portatili più leggeri, più potenti, e dall'autonomia maggiore di quelli attuali, desktop e server più potenti ed efficienti a parità di spazio.

E in seguito la tendenza sarà sempre questa, fino ai limiti fisici del silicio, per poi passare ad altro.

Pensa se si fermasse tutto: andrei adesso a comprare un PC e trovo roba con il Pentium D 830, 6800GT, 2GB DDR2 667, HD 250GB, che consuma 400W, oppure notebook con il Pentium M da 3Kg che durano massimo 2 ore, per far girare gli stessi programmi e/o gli stessi giochi.

ma se uno non ha particolari esigenze di spazio, un 775 fa praticamente ancora le stesse cose di un 1155 con una manciata di Watt in più..

quindi boh, per gli utlilizzatori normali, ovvero la stragrande maggioranza dei consumatori che hanno un middletower sotto una scrivania, tutte ste innovazioni del processo produttivo (obbligatorie & necessarie all' evoluzione) risultano alla fin della fiera un po' inutili..

Ne dubito.

Passando da 775 (e5200) a 1155 (i3 2120) non solo il consumo è sceso di qualche decina di watt (e, credimi, se in casa hai più di un computer, coi mesi, la differenza sulla bolletta la senti), ma in alcuni task come la compressione x264, il framerate al secondo è quasi raddoppiato (a parità di frequenza fra le due cpu, 3.3ghz), con tempo di encoding quindi quasi dimezzato. In generale, anche in molte altre attività si sente la nuova cpu.

Che poi la ragazzina che naviga su Facebook possa farne a meno, è un altro discorso, ma credo non sia rilevante ai fini dell'evoluzione del mercato. Credo che anche lei, se provasse una cpu di 4/5 anni più vecchia, potrebbe avvertire qualche differenza.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".