OpenAI Codex scrive codice e lo testa da solo: addio ai bug?

OpenAI ha annunciato il lancio di Codex, un nuovo agente AI ottimizzato per il software engineering e integrato in ChatGPT. Alimentato da codex-1 e progettato per lavorare in cloud, Codex può scrivere codice, correggere bug e proporre pull request. È già in uso in aziende come Cisco.

di Manolo De Agostini pubblicata il 17 Maggio 2025, alle 07:01 nel canale WebChatGPTOpenAI

OpenAI ha annunciato l'anteprima di ricerca di Codex, un nuovo agente AI per la programmazione progettato per automatizzare e semplificare le attività di sviluppo software. L'agente è già disponibile per gli abbonati a ChatGPT Pro, Team ed Enterprise, e sarà esteso prossimamente ai piani Plus ed Edu.

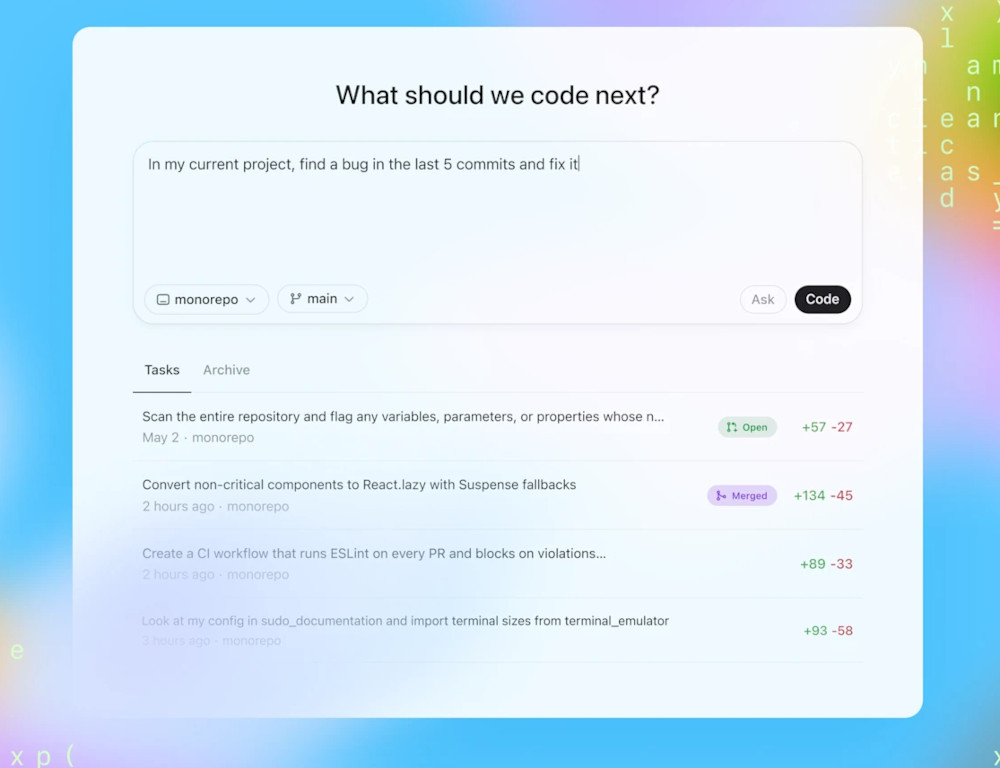

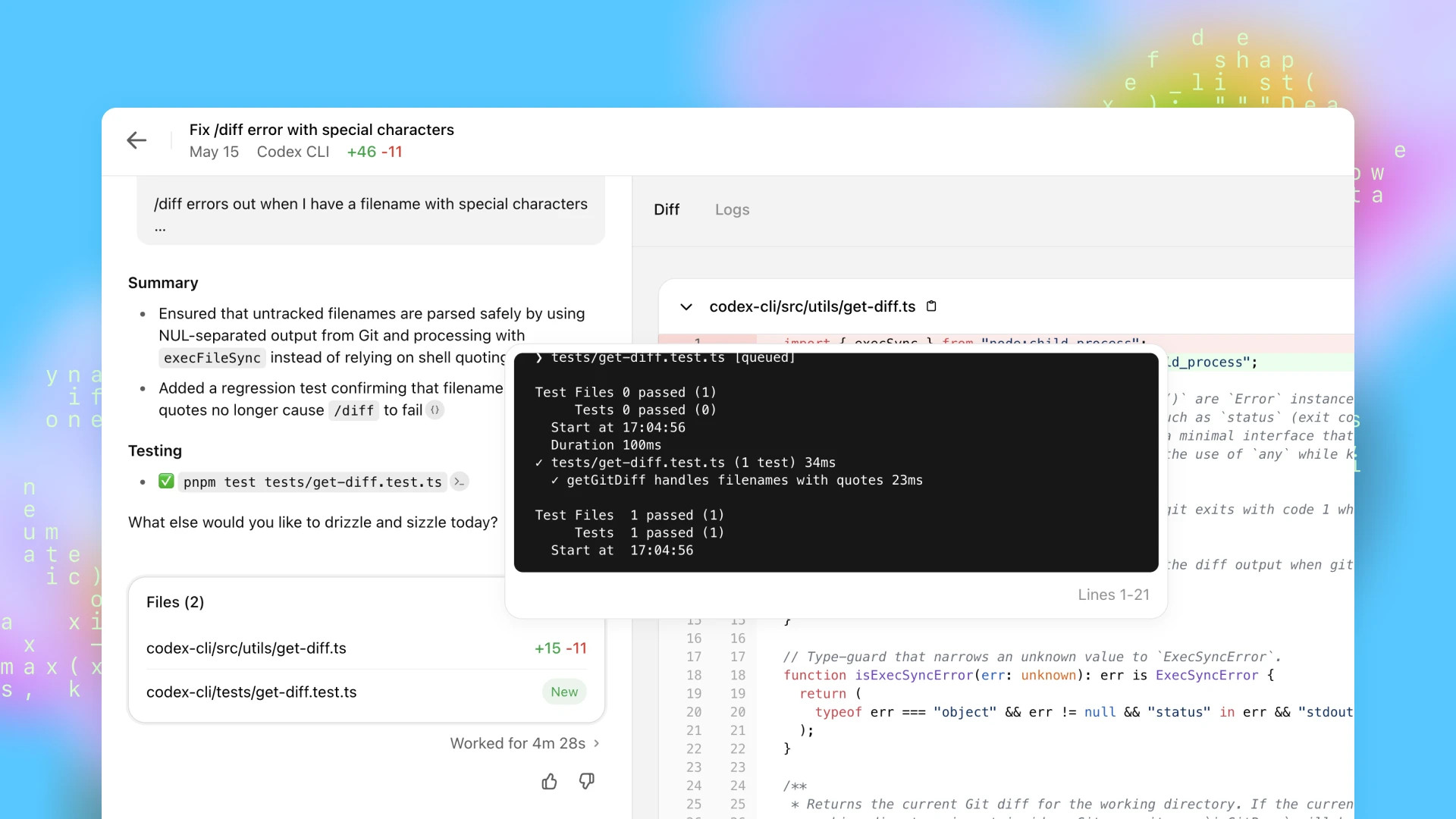

Codex consente agli sviluppatori di delegare attività ripetitive e semplici, come scrivere funzionalità base, correggere bug, generare test o proporre pull request. Opera all'interno di container isolati nel cloud, caricati con il codice dell'utente e configurati per rispecchiare accuratamente l'ambiente di sviluppo. Gli utenti possono assegnare task tramite prompt testuali direttamente dalla barra laterale dell'app web di ChatGPT, scegliendo tra i pulsanti "Code" (per generare codice) o "Ask" (per ricevere risposte e consigli tecnici).

Codex si basa su codex-1, una versione del modello o3 ottimizzata tramite reinforcement learning su compiti di programmazione reali. Rispetto ai predecessori, produce codice più pulito, segue istruzioni in modo più preciso e itera sui test automaticamente fino a ottenere risultati positivi. A differenza del tool open source Codex CLI, Codex offre un'interfaccia interattiva e orientata a casi d'uso professionali.

Per migliorare l'efficacia del sistema, OpenAI consiglia agli sviluppatori di includere nel repository un file AGENTS.md, simile a un README ma pensato per l'AI: può contenere linee guida stilistiche, standard del progetto o spiegazioni architetturali, aiutando l'agente a operare in modo più contestualizzato e coerente con le pratiche del team.

Clicca per ingrandire

OpenAI ha già testato Codex con aziende come Cisco, Temporal, Superhuman e Kodiak, che lo utilizzano per velocizzare i rilasci e migliorare la qualità del software. I risultati sembrano promettenti, soprattutto in termini di automazione delle attività a basso valore aggiunto.

Secondo Josh Tobin, Agents Research Lead di OpenAI, l'obiettivo è arrivare a una collaborazione uomo-macchina in cui Codex agisca come un "collega virtuale" capace di portare a termine compiti che normalmente richiederebbero ore o giorni di lavoro.

Codex funziona in un ambiente air-gapped, senza accesso a Internet o ad API esterne, ed è programmato per rifiutare la creazione di software dannoso. Tuttavia, OpenAI ribadisce che è fondamentale una revisione umana del codice generato, che non deve essere eseguito senza verifica.

Clicca per ingrandire

L'interesse per questo tipo di strumenti è in forte crescita. Google e Microsoft hanno affermato che circa il 30% del codice aziendale è già scritto da AI (e, nel caso di Microsoft, questo starebbe già incidendo sui posti di lavoro). OpenAI intende consolidare la propria posizione in questo mercato anche attraverso l'acquisizione della startup Windsurf, valutata 3 miliardi di dollari.

OpenAI prevede di introdurre limiti di utilizzo e un modello a crediti per l'accesso a Codex. Parallelamente, Codex CLI è stato aggiornato con il modello o4-mini, disponibile anche via API a pagamento.

Questo lancio si inserisce in una strategia più ampia di OpenAI per trasformare ChatGPT in una piattaforma agent-native, che includa strumenti autonomi come Operator (per la navigazione web automatica) e Deep Research (per la sintesi e l'analisi di informazioni complesse).

FRITZ!Repeater 1700 estende la rete super-veloce Wi-Fi 7

FRITZ!Repeater 1700 estende la rete super-veloce Wi-Fi 7 Fondazione Chips-IT, l'Italia alla riscossa nei chip. Il piano e la partnership EssilorLuxottica

Fondazione Chips-IT, l'Italia alla riscossa nei chip. Il piano e la partnership EssilorLuxottica Nutanix: innovazione, semplicità e IA al centro della strategia hybrid multicloud

Nutanix: innovazione, semplicità e IA al centro della strategia hybrid multicloud Intel prova macchinari 'cinesi' per i chip del futuro? Il caso ACM scuote Washington

Intel prova macchinari 'cinesi' per i chip del futuro? Il caso ACM scuote Washington Windows 11, problemi con l'aggiornamento KB5072033 e codice errore 0x800f0991

Windows 11, problemi con l'aggiornamento KB5072033 e codice errore 0x800f0991 Bitcoin, sono passati 15 anni dalla 'scomparsa' di Satoshi Nakamoto. Un mistero ancora irrisolto

Bitcoin, sono passati 15 anni dalla 'scomparsa' di Satoshi Nakamoto. Un mistero ancora irrisolto DAZN lancia il Pass Giornata per la Serie A: come si attiva e quanto costa

DAZN lancia il Pass Giornata per la Serie A: come si attiva e quanto costa Street Fighter: Paramount e Capcom pubblicano il primo trailer ufficiale del nuovo film

Street Fighter: Paramount e Capcom pubblicano il primo trailer ufficiale del nuovo film Corsa finale all'ultimo sconto: Amazon promette un weekend con sconti eccezionali un po' su tutto, ecco quelli che abbiamo trovato

Corsa finale all'ultimo sconto: Amazon promette un weekend con sconti eccezionali un po' su tutto, ecco quelli che abbiamo trovato Per Tom Cruise niente film nello spazio: non vuole avvicinarsi a Trump e Musk

Per Tom Cruise niente film nello spazio: non vuole avvicinarsi a Trump e Musk Invincible VS, dopo fumetti e serie TV arriva il picchiaduro con la giusta dose di sangue

Invincible VS, dopo fumetti e serie TV arriva il picchiaduro con la giusta dose di sangue Il robot umanoide che voleva fare il maggiordomo andrà in fabbrica

Il robot umanoide che voleva fare il maggiordomo andrà in fabbrica Galaxy Tab S10 Lite a 299€ su Amazon: tablet Samsung elegante con S Pen e Android 15 a prezzo bomba

Galaxy Tab S10 Lite a 299€ su Amazon: tablet Samsung elegante con S Pen e Android 15 a prezzo bomba Prezzi in picchiata sull'hardware PC: GPU, CPU e monitor in offerta per l'upgrade

Prezzi in picchiata sull'hardware PC: GPU, CPU e monitor in offerta per l'upgrade Aspyr ha rinviato Deus Ex Remastered: progetto in revisione dopo i feedback negativi

Aspyr ha rinviato Deus Ex Remastered: progetto in revisione dopo i feedback negativi Amazon Haul, prezzi mini senza precedenti: migliaia di prodotti a meno di 2€

Amazon Haul, prezzi mini senza precedenti: migliaia di prodotti a meno di 2€

4 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoHallucination is Inevitable: An Innate Limitation of Large Language Models

[I]Hallucination has been widely recognized to be a significant drawback for large language models (LLMs). In this paper, we formalize the problem and show that it is impossible to eliminate hallucination in LLMs. Specifically, we define a formal world where hallucination is defined as inconsistencies between a computable LLM and a computable ground truth function. By employing results from learning theory, we show that LLMs cannot learn all the computable functions and will therefore inevitably hallucinate if used as general problem solvers. Since the formal world is a part of the real world which is much more complicated, hallucinations are also inevitable for real world LLMs.[/I]

a me pare 'na strunzata...

mi aspetto da una MACCHINA che faccia il lavoro PERFETTO

già il fatto che si deve correggere significa che fa il lavoro con degli errori

e allora me lo faccio da solo

a me pare 'na strunzata...

mi aspetto da una MACCHINA che faccia il lavoro PERFETTO

già il fatto che si deve correggere significa che fa il lavoro con degli errori

e allora me lo faccio da solo

Diciamo che tu a scrivere un programmino ci metti 2 ore, l'IA ci mette 2 minuti, anche se il codice è più buggato al programmatore comunque conviene perché il debugging è problema d'altri! 😂

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".