NVIDIA H100 NVL è l'acceleratore pensato esclusivamente per ChatGPT

Alla GTC 2023 NVIDIA ha annunciato H100 NVL, una variante di H100 che unisce due schede ed è progettata specificamente per uno scopo, potenziare i modelli di linguaggio AI come ChatGPT.

di Manolo De Agostini pubblicata il 22 Marzo 2023, alle 08:01 nel canale Schede VideoChatGPTNVIDIAHopper

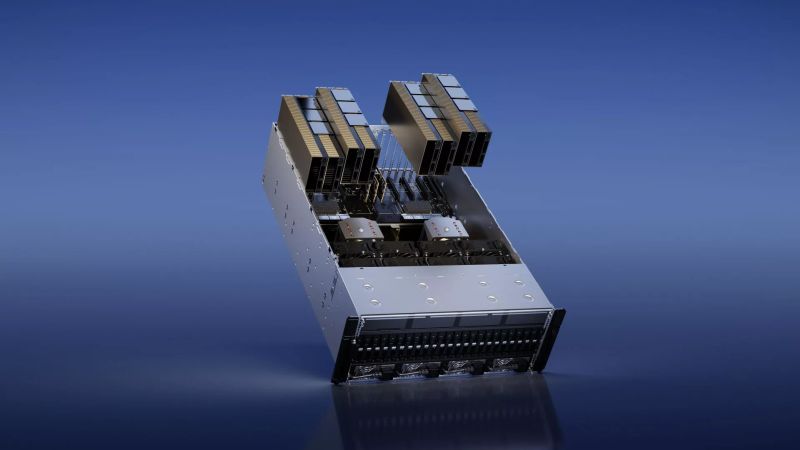

Qualcuno si è azzardato a chiamarla dual GPU, ma ci troviamo davanti a due schede separate collegate tra loro tramite tre collegamenti NVLink. Stiamo parlando di H100 NVL (NVL sta per NVLink), una nuova soluzione presentata da NVIDIA alla GTC 2023 destinata alla gestione di grandi modelli linguistici come ChatGPT.

In base a quanto diffuso dalla società, H100 NVL (H100 NVLink) prevede connettori NVLink nella parte superiore che consentono di collegare due schede adiacenti, inserite però in slot PCI Express 5.0 separati.

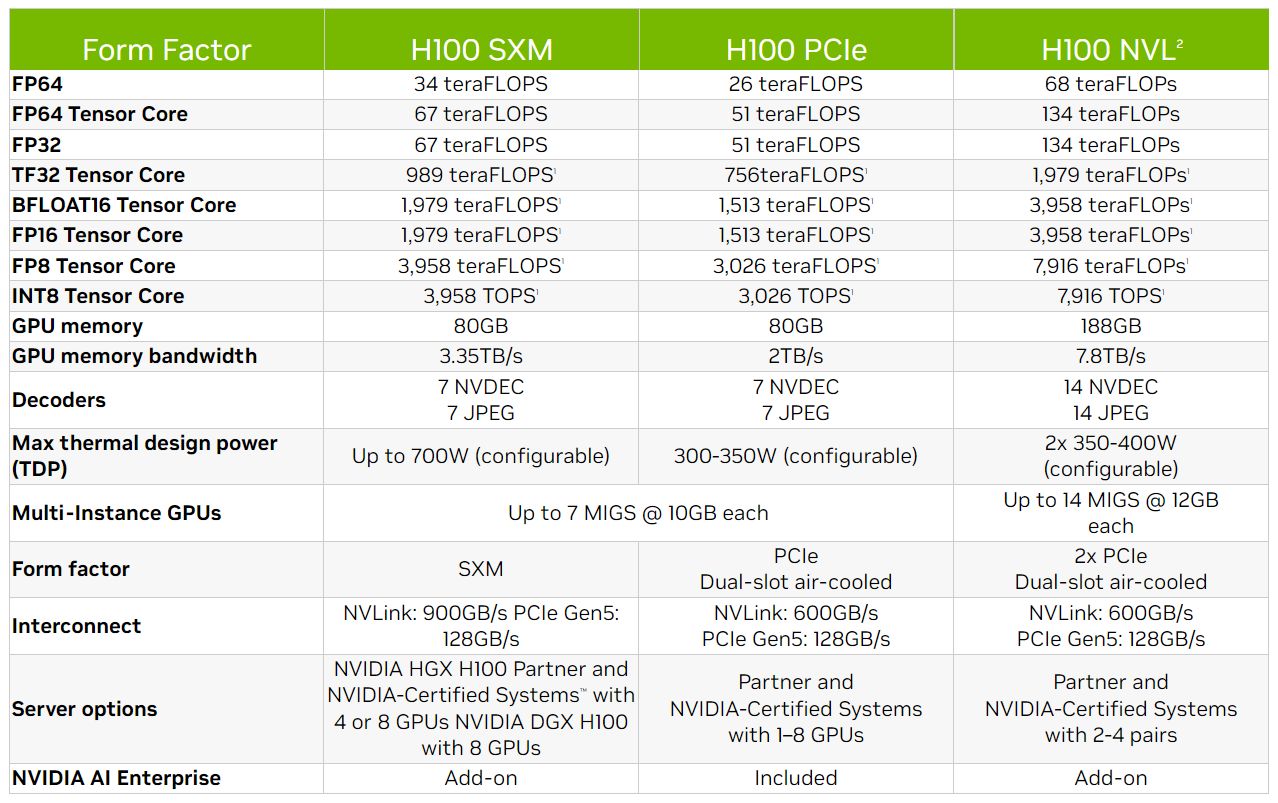

H100 NVL è dotata di un chip identico nelle caratteristiche alla versione H100 SXM5, ma troviamo 94 GB di memoria HBM3 per GPU al posto di 80 GB, per un totale di 188 GB. In virtù della maggiore memoria, il bus sale a 6144 bit (1024 bit per ogni stack HBM3) per una bandwidth di 7,8 GB/s.

Sebbene le due schede operino in tandem, parlare di dual GPU appare un attimo forzato: non ci sono due GPU sullo stesso PCB né il progetto ricorda la GeForce 7950 GX2, la scheda gaming a "panino" con due GPU e altrettanti PCB ma un singolo connettore PCIe.

NVIDIA afferma che diverse H100 NVL possono essere usate in parallelo nei server, tanto che i partner stanno mettendo a punto sistemi capaci di ospitare da due a quattro coppie. Ogni H100 NVL viene vista dal sistema operativo come due GPU, ma il carico viene distribuito automaticamente tra i chip senza richiedere modifiche o intervento umano.

Oltre alla H100 NVL, NVIDIA ha presentato NVIDIA L4, una proposta basata su architettura Ada Lovelace che prende il posto della T4 basata sul progetto Turing. Anche in questo caso, la scheda è destinata alla decodifica e transcodifica di flussi video e audio nel cloud (qui ulteriori dettagli).

Google Cloud prevede di usarla in nuove macchine virtuali di classe G2 per accelerare soluzioni basate sull'intelligenza artificiale come Descript. Nella gestione di calcoli di intelligenza artificiale nei video, la nuova NVIDIA L4 raggiunge prestazioni 120 volte superiori e un'efficienza migliore del 99% rispetto a un sistema basato su CPU. La scheda può anche essere usata per decodificare fino a 1.040 flussi video in parallelo. NVIDIA L4 è disponibile in un fattore di forma a basso profilo ed è alimentata solamente tramite lo slot PCIe.

Infine, NVIDIA ha creato anche NVIDIA L40 per la generazione di immagini (maggiori informazioni qui). "È ottimizzata per grafica e generazione di immagini 3D, 2D e video con l'IA. La piattaforma L40 serve come motore di NVIDIA Omniverse e offre prestazioni fino a 7 volte maggiori nell'inferenza per Stable Diffusion e 12 volte le prestazioni per Omniverse rispetto alla generazione precedente".

La rivoluzione dei dati in tempo reale è in arrivo. Un assaggio a Confluent Current 2025

La rivoluzione dei dati in tempo reale è in arrivo. Un assaggio a Confluent Current 2025 SAP Sapphire 2025: con Joule l'intelligenza artificiale guida app, dati e decisioni

SAP Sapphire 2025: con Joule l'intelligenza artificiale guida app, dati e decisioni Dalle radio a transistor ai Micro LED: il viaggio di Hisense da Qingdao al mondo intero

Dalle radio a transistor ai Micro LED: il viaggio di Hisense da Qingdao al mondo intero Una domenica bestiale Amazon: LG OLED, super portatile Lenovo, iPhone 16 Pro e Pro Max, robot e altri super sconti

Una domenica bestiale Amazon: LG OLED, super portatile Lenovo, iPhone 16 Pro e Pro Max, robot e altri super sconti DJI Mini 4 Pro Fly More Combo: drone leggero che non richiede il patentino oggi in offerta super su Amazon

DJI Mini 4 Pro Fly More Combo: drone leggero che non richiede il patentino oggi in offerta super su Amazon realme GT 7T: display da 6000 nit, potentissimo, 7000 mAh, quasi un top di gamma a metà del prezzo che ti aspetti

realme GT 7T: display da 6000 nit, potentissimo, 7000 mAh, quasi un top di gamma a metà del prezzo che ti aspetti Ancora qualche pezzo per il portatile Lenovo con Core i7, 40GB RAM e 1TB SSD: va sempre a ruba

Ancora qualche pezzo per il portatile Lenovo con Core i7, 40GB RAM e 1TB SSD: va sempre a ruba TV OLED LG Serie C4 2024: immagini da cinema e 4K a 144Hz in sconto su Amazon

TV OLED LG Serie C4 2024: immagini da cinema e 4K a 144Hz in sconto su Amazon Smartwatch Amazfit in sconto: Active 2 a 97€, ma ci sono offerte su tutta la gamma

Smartwatch Amazfit in sconto: Active 2 a 97€, ma ci sono offerte su tutta la gamma Router e ripetitori AVM FRITZ! da 30€ su Amazon: ecco tutte le offerte da non perdere

Router e ripetitori AVM FRITZ! da 30€ su Amazon: ecco tutte le offerte da non perdere Adulting 101: i corsi per imparare come era la vita fino a qualche anno fa

Adulting 101: i corsi per imparare come era la vita fino a qualche anno fa Blue Origin ha lanciato con successo la missione suborbitale NS-32 con New Shepard

Blue Origin ha lanciato con successo la missione suborbitale NS-32 con New Shepard L'amministrazione Trump ha ritirato la candidatura di Jared Isaacman come amministratore della NASA

L'amministrazione Trump ha ritirato la candidatura di Jared Isaacman come amministratore della NASA La NASA potrebbe chiudere le missioni OSIRIS-APEX, New Horizons e Juno cancellandone altre per risparmiare soldi

La NASA potrebbe chiudere le missioni OSIRIS-APEX, New Horizons e Juno cancellandone altre per risparmiare soldi Trump vieta anche la vendita di software per la progettazione di chip alle società cinesi

Trump vieta anche la vendita di software per la progettazione di chip alle società cinesi Le migliori offerte del weekend Amazon: portatili, robot, iPhone, Kindle ai prezzi più bassi di sempre

Le migliori offerte del weekend Amazon: portatili, robot, iPhone, Kindle ai prezzi più bassi di sempre Dreame L40 Ultra a 699€, prezzo shock: vale quasi quanto l’X40 Ultra da 999€ (ma costa 300€ in meno!)

Dreame L40 Ultra a 699€, prezzo shock: vale quasi quanto l’X40 Ultra da 999€ (ma costa 300€ in meno!)

2 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infomi pare prenda piuttosto il posto delle A40 o sbaglio?

"IBM voglio un robo che fa 20000"

"IBM presenta robo 7000, il robo che fa 20000"

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".