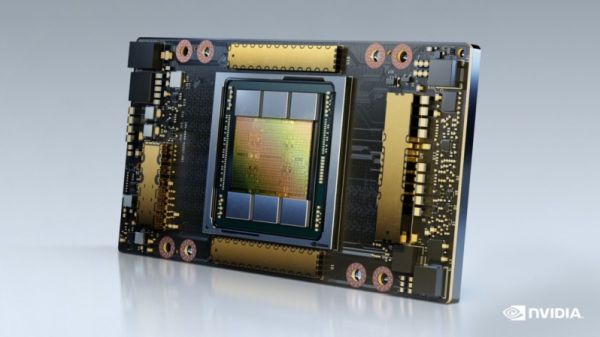

L'acceleratore Nvidia A100 raddoppia con ben 80 GB di memoria HBM2E

Nvidia ha presentato una nuova versione di Nvidia A100, l'acceleratore per carichi di intelligenza artificiale basato su GPU Ampere GA100, caratterizzata dal doppio della memoria, ben 80 GB di HBM2E a più alta velocità.

di Manolo De Agostini pubblicata il 17 Novembre 2020, alle 16:51 nel canale Schede VideoNVIDIA

Non solo AMD con la Instinct MI100, anche Nvidia ha annunciato una novità per il mondo dei supercomputer nelle scorse ore: l'azienda statunitense ha presentato una nuova versione dell'acceleratore A100 con il doppio della memoria. La nuova Nvidia A100 offre ben 80 GB di memoria HBM2E rispetto ai 40 GB di HBM2 che ritroviamo sul modello presentato solo alcuni mesi fa.

Il salto alla nuova memoria non è benefico solo dal punto di vista della capacità, ma anche per quanto riguarda la bandwidth, infatti si passa da 1,6 TB/s a 2 TB/s, grazie alla HBM2E a 3,2 Gbps su un bus che rimane a 5120 bit. Questa nuova versione di Nvidia A100 non manda in pensione il modello da 40 GB e strizza l'occhio a chi lavora con grandi insiemi di dati destinati all'allenamento di intelligenze artificiali.

Una così elevata quantità di memoria consente infatti di mantenere un intero modello in memoria, con un conseguente miglioramento prestazionale derivante dalla minore necessità di andare a pescare i dati nella memoria di sistema. Per il resto, la nuova soluzione A100 di Nvidia ha le stesse caratteristiche del modello da 40 GB, quindi abbiamo una GPU GA100 prodotta a 7 nanometri, dotata di ben 54,2 miliardi di transistor e 6912 CUDA core FP32 all'interno di 108 SM, affiancati da 432 Tensor core e altrettante unità texture. Non cambia nemmeno il TDP tra le due versioni, pari a 400W.

Nvidia ha dichiarato che il nuovo modello da 80 GB sarà disponibile anche agli utenti multi-istanza (MIG), per un totale di 7 istanze con 10 GB di memoria dedicata ciascuna. La nuova arrivata farà parte inoltre di sistemi HGX e DGX, in particolare il nuovo DGX A100 640GB con otto A100, e persino di una nuova soluzione chiamata DGX Station A100, che può essere vista come la metà esatta di un sistema DGX A100 - Nvidia la chiama "petascale workgroup server". A bordo ci sono quattro acceleratori A100 e un processore EPYC di AMD. Entrambi i sistemi sono in produzione e la disponibilità è attesa tra gennaio e febbraio 2021.

La rivoluzione dei dati in tempo reale è in arrivo. Un assaggio a Confluent Current 2025

La rivoluzione dei dati in tempo reale è in arrivo. Un assaggio a Confluent Current 2025 SAP Sapphire 2025: con Joule l'intelligenza artificiale guida app, dati e decisioni

SAP Sapphire 2025: con Joule l'intelligenza artificiale guida app, dati e decisioni Dalle radio a transistor ai Micro LED: il viaggio di Hisense da Qingdao al mondo intero

Dalle radio a transistor ai Micro LED: il viaggio di Hisense da Qingdao al mondo intero Squid Game 3, il trailer della terza stagione è qui! Trama, cast e data di usicta

Squid Game 3, il trailer della terza stagione è qui! Trama, cast e data di usicta Speciale offerte videocamere e webcam Insta360: 6 modelli tra 4K, 8K, POV e panoramiche a 360°

Speciale offerte videocamere e webcam Insta360: 6 modelli tra 4K, 8K, POV e panoramiche a 360° Microsoft annuncia diverse novità su Windows in Europa, per una maggiore adesione al DMA

Microsoft annuncia diverse novità su Windows in Europa, per una maggiore adesione al DMA Stranger Things 5: ecco il trailer e la data di uscita della stagione finale su Netflix

Stranger Things 5: ecco il trailer e la data di uscita della stagione finale su Netflix Sconti PlayStation 5 su Amazon: Slim con 2 DualSense a 459€, PS VR2 a 399€ e PS5 Pro in offerta a 749€

Sconti PlayStation 5 su Amazon: Slim con 2 DualSense a 459€, PS VR2 a 399€ e PS5 Pro in offerta a 749€ Roborock QV 35A: il robot che pulisce da solo e senza intoppi oggi è in offerta a 474€

Roborock QV 35A: il robot che pulisce da solo e senza intoppi oggi è in offerta a 474€ Gli iPhone in offerta oggi? C'è il 15 128GB a 645€, oltre ai 16 Pro e Pro Max al minimo storico

Gli iPhone in offerta oggi? C'è il 15 128GB a 645€, oltre ai 16 Pro e Pro Max al minimo storico Una domenica bestiale Amazon: LG OLED, super portatile Lenovo, iPhone 16 Pro e Pro Max, robot e altri super sconti

Una domenica bestiale Amazon: LG OLED, super portatile Lenovo, iPhone 16 Pro e Pro Max, robot e altri super sconti DJI Mini 4 Pro Fly More Combo: drone leggero che non richiede il patentino oggi in offerta super su Amazon

DJI Mini 4 Pro Fly More Combo: drone leggero che non richiede il patentino oggi in offerta super su Amazon realme GT 7T: display da 6000 nit, potentissimo, 7000 mAh, quasi un top di gamma a metà del prezzo che ti aspetti

realme GT 7T: display da 6000 nit, potentissimo, 7000 mAh, quasi un top di gamma a metà del prezzo che ti aspetti Ancora qualche pezzo per il portatile Lenovo con Core i7, 40GB RAM e 1TB SSD: va sempre a ruba

Ancora qualche pezzo per il portatile Lenovo con Core i7, 40GB RAM e 1TB SSD: va sempre a ruba TV OLED LG Serie C4 2024: immagini da cinema e 4K a 144Hz in sconto su Amazon

TV OLED LG Serie C4 2024: immagini da cinema e 4K a 144Hz in sconto su Amazon Smartwatch Amazfit in sconto: Active 2 a 97€, ma ci sono offerte su tutta la gamma

Smartwatch Amazfit in sconto: Active 2 a 97€, ma ci sono offerte su tutta la gamma

4 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoOrmai il consumo non ha nessun significato, dovrei sorprendermi ma in realtà è tutto estremamente ovvio

La mi100 con 100 watt in meno la passa lo stesso

La mi100 con 100 watt in meno la passa lo stesso

La mi100 è molto più lenta su un po’ tutte le specifiche

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".