Rilevare latenza e consumi, i kit Nvidia LDAT e PCAT in aiuto dei recensori

Nvidia ci ha inviato due kit molto utili per testare al meglio le schede video e non solo. LDAT è uno strumento che ci permette di superare le difficoltà nel test della latenza, sia per quanto riguarda i monitor ad alto refresh rate che per ciò che riguarda il carico di lavoro assegnato all'hardware in funzione del tipo di videogioco. Il secondo kit, PDAT, ci permette di misurare in modo accurato i consumi delle schede video.

di Rosario Grasso , Manolo De Agostini pubblicato il 08 Settembre 2020 nel canale Schede VideoNVIDIA

Quando si parla di schede video ci si concentra principalmente sulle prestazioni, caratterizzate dai frame per secondo (FPS) prodotti da una GPU. Esistono però altri due aspetti importanti nel caratterizzare una scheda video, e sono i consumi e l'impatto sulla latenza complessiva dell'interno PC.

Spesso si tratta di valori difficili da misurare con precisione e affidabilità, ed è per questo che Nvidia ha confezionato due kit appositi per aiutare i recensori a fornire informazioni di valore ai propri lettori. In questo articolo mostriamo e spieghiamo a grandi linee come sono fatti e cosa sono Latency and Display Analysis Tool (LDAT) e Power Capture Analysis Tool (PCAT), ma andiamo con ordine.

LDAT: la latenza è sempre più importante per il gaming

Recente tendenza nel mercato delle periferiche hardware PC riguarda le soluzioni volte a minimizzare la latenza dell'intera postazione di gioco. Con l'emergere del fenomeno eSport, in altri termini, si cerca di fare in modo che a schermo si concretizzi l'interazione del giocatore nel minor tempo possibile. Ovviamente si sta parlando di millesimi di secondo, ovvero della necessità di rendere la prestazione del giocatore il più fedele possibile. Questo passa dal mouse e dalla tastiera, dal metodo di funzionamento del server di gioco, ma anche dai calcoli che fa l'hardware interno al PC, CPU e GPU prima di ogni cosa. Incide più di tutti, ovviamente, il monitor e il suo refresh rate.

Abbiamo già cercato di misurare il ritardo tra l'istante in cui si clicca sul mouse e il cambiamento di luminosità a schermo (pensate al bagliore prodotto dallo sparo di un'arma), ma fino a ora siamo stati in grado di farlo solo in maniera artigianale (nel caso del cloud gaming). In altre parole, non avevamo la possibilità di quantificare il ritardo in maniera numerica. In tal senso ci viene in soccorso Nvidia, che nei giorni scorsi ci ha inviato in redazione uno strumento molto utile per rilevare la latenza: LDAT o Latency Display Analysis Tool.

LDAT usa un sensore di luminanza da applicare sullo schermo e al tempo stesso è connesso a un mouse (nella configurazione inviataci un Logitech G203). Il sensore rileva la luminanza dello schermo senza interruzioni e, tramite il software fornito a corredo, può essere usato in modalità Click-to-Photon Latency, ovvero misurare il lasso di tempo che intercorre il tra click sul mouse e il cambiamento di luminanza sullo schermo.

Quando il giocatore clicca sul mouse, un impulso viene inviato al PC, che elabora le conseguenze a quell'evento coinvolgendo la CPU, il sistema operativo, il gioco, la coda di rendering e la GPU. Infine, abbiamo la visualizzazione sullo schermo che, prima dell'introduzione di tecnologie di sincronizzazione adattativa come G-SYNC, procedeva su tempistiche differenti rispetto ai momenti in cui le elaborazioni dei frame eseguite dal sistema giungevano a termine. Il tempo necessario perché si passi dall'evento alla visualizzazione sullo schermo viene definito "tempo di risposta dei pixel". LDAT misura proprio questo intervallo di tempo, considerando il tempo di elaborazione del frame da parte di hardware e software e la visualizzazione a schermo.

Il messaggio che NVIDIA vuole trasmettere è che l'elaborazione del frame ha un ruolo sulla latenza. Un sistema in grado di fornire frame in maniera continuativa e a ritmi alti contribuirà a far sì che l'intera postazione generi meno latenza nel corso del tempo. In funzione della risoluzione a cui si gioca e della complessità delle scene di gioco da renderizzare e del motore grafico, dunque, ci possono essere differenze in termini di latenza, al netto del monitor e degli altri componenti della postazione.

Tutto parte dal mouse, ovvero dal primo contatto elettrico che si innesca nell'istante della pressione e dell'invio del segnale tramite il cavo della periferica. Quest'ultimo è inoltre dotato di accortezze per garantire la precisione della pressione, come l'anti-rimbalzo, che a loro volta possono incidere sulla latenza. Il mouse, similmente al monitor, deve attendere il prossimo istante di polling per comunicare con il sistema principale e inviare a quest'ultimo il dato. Di solito la velocità di polling è di 1000 Hz, ovvero in un secondo il mouse e il sistema comunicano 1000 volte: una frequenza nettamente superiore rispetto a quella che caratterizza altri componenti della postazione di gioco.

Poi c'è la parte del gioco, ovvero il motore grafico deve produrre animazioni, cambiamenti allo scenario e altre modifiche dovute all'input del giocatore. Questo processo prevede l'invio del carico di rendering da svolgere al runtime dell'API grafica che, a sua volta, passa i comandi di rendering al driver grafico. Gestito dalla CPU, il driver è responsabile della comunicazione della CPU con la GPU e, in funzione del tipo di API utilizzata, gestisce i comandi in maniera differente.

Una volta che il driver ha inviato il lavoro da svolgere, questo acquisisce una posizione nella coda di rendering. Quest'ultima è progettata in modo da mantenere sempre alimentata la GPU e ottimizzarne la sua architettura hardware. La GPU ha sempre lavoro da fare ma smaltisce la sua coda di rendering secondo tempistiche differenti a seconda del carico di lavoro, e questo fa crescere la latenza.

Nel processo c'è un ruolo del sistema operativo. In particolare, a seconda della modalità di visualizzazione (schermo intero, senza bordi, con finestre), il processo Desktop Windows Manager (DWM) invia del lavoro di rendering aggiuntivo per comporre il resto del desktop per ciascun frame, il che può far aumentare la latenza. Per questo motivo, si consiglia sempre di giocare a schermo intero. C'è poi una fase di "Scanout", ovvero il momento in cui il frame attualmente visualizzato a schermo nel frame buffer viene sostituito con il successivo frame completato. Infine, lo schermo elabora i dati che riceve e modifica i pixel a seconda del suo ritmo di aggiornamento.

LDAT, ci fa sapere Nvidia, misura la quantità di tempo che intercorre dal momento in cui lo switch del mouse chiude elettricamente il contatto al momento in cui la luminanza sullo schermo aumenta di almeno il 6% rispetto al suo valore iniziale. Tradizionalmente il tempo di risposta corrisponde a quella quantità di tempo che occorre per far passare un pixel da un grigio all'altro. Nvidia ha qui arbitrariamente deciso di ridurre questo intervallo di tempo per isolare la latenza del sistema, prima della soglia di rilevamento umana. La soglia di luminanza alla quale deve avvenire la misura può essere comunque configurata tramite il software di LDAT.

LDAT è dunque dotato nella parte posteriore di un sensore di luce che va accuratamente posto sullo schermo tramite un elastico che può essere fissato a partire dalla cornice superiore fino alla base del monitor. La parte anteriore del sensore LDAT ha due pin per la connessione del mouse e un indicatore di stato che comunica il tipo di operazione che in quel momento LDAT sta svolgendo. Tramite un cavo micro-USB, LDAT va connesso anche al PC, in modo da trasferire tutti i dati di luminanza che servono al software. Infine, anche il mouse va connesso al PC tramite il suo canonico cavo USB.

Il software di LDAT ha due modalità di funzionamento: Free Running, che rivela continuamente tutte le variazioni di luminanza sullo schermo; e Click-to-Photon Latency, che è la misura che ci interessa per gli scopi di questo articolo. Fondamentale la presenza dell'Auto Fire, ovvero la simulazione della pressione sul mouse, perché esclude dal test la variabilità dovuta a come il dito impone sul mouse la forza per innescare il click, il che ci aveva dato diversi problemi con il nostro primo test "artigianale". Inoltre, dato che la misura della latenza è estremamente suscettibile rispetto al momento in cui viene fatta, l'Auto Fire, emettendo una dopo l'altra pressioni fino a una serie di 100, ci permette di eseguire molte rilevazioni e di fare le nostre analisi in base a una media fra le misure.

Il primo test che abbiamo fatto è stato attraverso l'applicazione Speed of Light Latency. Si tratta di un programmino estremamente semplice, che mostra una schermata completamente nera che, al momento del click, diventa bianca per una frazione di secondo. Il passaggio dal nero al bianco viene rilevato da LDAT che ci indica una misura numerica legata alla transizione. Abbiamo eseguito il test sul monitor Predator XB253QGXbmiiprzx 24.5", IPS Full HD, 240 Hz con G-SYNC abilitato impostando i livelli di refresh rate 60, 144 e 240 Hz per simulare il comportamento a diverse frequenze di aggiornamento dello schermo.

Il test ci mostra delle differenze importanti, con lo schermo che ha una latenza particolarmente bassa al suo refresh rate di base, 240 Hz, aumentando in maniera abbastanza importante quando impostato a 60 Hz. Che cosa vuol dire questo? Nel caso di una sessione di gioco multiplayer, una latenza di 50 o di 100 ms in più da aggiungere a quella del server può comportare a prestazioni in gioco scadenti. Se altri 50 o 100 ms di ritardo derivano dalla connessione al server si può parlare di latenze raddoppiate, che hanno un peso in un contesto sportivo competitivo.

Uno schermo che si aggiorna a 240 Hz si traduce nella possibilità di visualizzare una nuova immagine ogni 4 millesimi di secondo circa, che diventano 6 millesimi circa nel caso dei 144 Hz e 16 con i 60 Hz. Deve essere chiaro questo concetto: se il frame proveniente dall'hardware arriva in prossimità del momento del refresh, la latenza è contenuta, se è pronto molto tempo prima e l'hardware non fornisce altri aggiornamenti allora la latenza può aumentare di qualche millesimo di secondo.

Negli umani il tempo di risposta agli stimoli visivi è tipicamente fra i 150 e i 300 millesimi di secondo, quindi siamo su valori superiori rispetto a quelli che qui stiamo misurando. Si tenga però conto che quest'ultimo dato corrisponde al tempo di reazione rispetto a un unico stimolo, mentre il gioco multiplayer è molto più complesso, prevedendo un'interazione continua e diluita nel tempo. Una postazione di gioco che mantiene sempre ritardi contenuti può dunque consentire notevoli vantaggi rispetto a un sistema che offre un'esperienza meno granitica e che occasionalmente sottopone a ritardi.

Come vedete abbiamo poi aggiunto la rilevazione con la Modalità bassa latenza attivata. Si tratta di una modalità presente nei driver NVIDIA che diminuisce la latenza nel caso di abilitazione del G-SYNC o di condizioni che portano a un incremento della latenza. Infatti, in questo test riduce considerevolmente la latenza quando il monitor è impostato a 60 Hz, mentre è molto meno efficiente nelle condizioni per le quali il monitor già lavora al suo meglio.

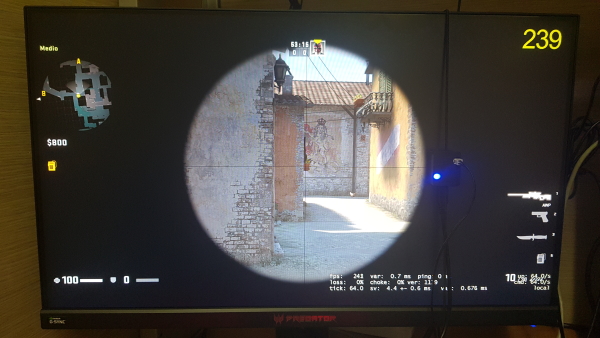

Ovviamente, lo scenario appare in forma molto diversa nel caso di un videogioco. Abbiamo scelto Counter-Strike: Global Offensive e abbiamo eseguito il test su una postazione dotata di AMD Ryzen 1700X e 16 GB di RAM, con tre schede video differenti: GeForce GTX 1080, GeForce RTX 2070 Super e Radeon RX 5700 XT. I test sono stati fatti in Full HD 1080p e con G-SYNC abilitato nel caso delle Nvidia e sincronia verticale abilitata per la scheda AMD.

Il test è stato svolto sulla mappa "Inferno" di CS:GO impostata nella modalità "Partita con i bot". Abbiamo abilitato i cheat per avere munizioni infinite, per poter comprare tutto e poter usare l'iconico fucile da cecchino di Counter-Strike AWP. Poi, per ogni run del test, ci siamo spostati in un preciso punto della mappa, che vedete nello screenshot, e abbiamo puntato al vaso di fiori.

In modalità "ironsight" abilitata, in cui ciò che sta fuori dal mirino è nero e solo la parte centrale mostra una porzione della mappa di gioco, abbiamo chiesto al software di LDAT di fare 100 scansioni con un ritardo di due secondi tra una scansione e l'altra. Il sensore, posizionato inizialmente sul nero, rileva il passaggio dal nero al colore e misura la latenza, poi esegue una media tra le 100 scansioni.

La prima cosa da sottolineare è come le latenze aumentino rispetto al test Speed of Light Latency. Come abbiamo detto prima, infatti, il processo di elaborazione del frame ha un impatto sulla latenza "click-to-photon", contribuendo per oltre 10 millesimi di secondo in queste circostanze. La 5700 XT e la 2070 Super, inoltre, guadagnano qualcosa sulla 1080 di precedente generazione, evidenziando ancora una volta che un frame rate più stabile comporta latenze inferiori. Notiamo, infine, che la tecnologia Modalità bassa latenza di Nvidia si comporta mediamente meglio rispetto a Radeon Input Lag in quelle condizioni per le quali le latenze si dilatano.

Passiamo a Fortnite per rilevare altri interessanti comportamenti. Parliamo di un gioco dotato di un motore grafico più moderno (Unreal Engine 4), che richiede al sistema un maggior consumo di risorse di calcolo. Le latenze, infatti, aumentano leggermente, mentre la 2070 Super mostra un certo vantaggio rispetto alle altre due schede.

Il test è stato realizzato all'interno della modalità Creativa, Laboratorio della Battaglia (per evitare che la presenza di altri giocatori compromettesse l'uniformità dei test). Siamo andati alla ricerca di una precisa arma, il Fucile d'assalto, per ciascuna run del test, in modo da assicurarci di misurare lo stesso tipo di fiammata per tutte le condizioni. E successivamente ci siamo recati sempre nello stesso punto di un capannone in modo che le tre schede video lavorassero nelle stesse condizioni di carico di rendering. Abbiamo poi posizionato il sensore sull'area dello schermo in cui si sarebbe verificata la fiammata, siamo andati in "ironsight" e poi abbiamo chiesto al software di LDAT di fare 20 rilevazioni con un ritardo di 1,5 secondi l'una dall'altra.

Le latenze maggiori dipendono dal frame rate erogato nelle varie circostanze dalle tre schede video. Mentre sul nostro sistema CS:GO va a totalizzare circa 300 frame per secondo con la 2070 Super, e qualcosa in meno con le altre schede video, Fortnite si ferma a circa 150/170 frame per secondo. E questo si traduce in un aumento delle latenze. Per cui il test ci dà una misura concreta e numerica di come le prestazioni della scheda video, e la complessità del gioco, incidano sulla latenza. Possiamo concludere che un sistema performante consente di giocare con meno ritardi, con vantaggi competitivi nei contesti eSport.

A questo punto, i più attenti ci diranno che abbiamo riscontrato latenze più alte perché abbiamo lasciato abilitato il G-SYNC. È´vero, ovviamente, e lo abbiamo fatto per simulare le condizioni di latenza con giochi elaborati a 60 e a 144 frame per secondo e monitor con refresh rate rispettivamente di 60 e di 144 Hz. G-SYNC, però, dilata le latenze e non ci permette di giocare nelle migliori condizioni possibili di cui la postazione di gioco sarebbe capace. Questo ovviamente per quanto riguarda il discorso latenza ma, come noto, permette di godere di una grafica migliore in termini di minor incidenza di artefatti di tipo tearing e stuttering. Ad ogni modo, sono questi i risultati dei test con CS:GO con G-SYNC disabilitato.

La Modalità bassa latenza ha meno "lavoro" da fare con il test con G-SYNC abilitato che rimarca ancora una volta l'efficacia di questa tecnologia nelle condizioni di latenza maggiore. Si rivela molto utile, se non indispensabile, per quei giocatori che volessero avere un'esperienza priva di problemi visivi all'immagine, sfruttando il pieno potenziale del monitor G-SYNC. La latenza minima di 20 millesimi di secondo, inoltre, è un dato molto interessante, che evidenzia ancora una volta come un monitor a 240 Hz può fare la differenza nei contesti competitivi. Si avvicina, infatti, moltissimo alla misura ottenuta con Speed of Light Latency, il che è possibile anche grazie alle ottime prestazioni dell'hardware con questo motore di gioco. Passiamo ora a PCAT.

PCAT: rilevare i consumi delle schede video con precisione

Il tema dei consumi nell'ambito delle schede video è da sempre di grande attualità, perché si traduce in un costo in bolletta che si riflette sulle tasche dei consumatori. I consumi di una determinata GPU sono inoltre fondamentali per il successo di un'architettura grafica, in quanto la scheda video produce meno calore e di conseguenza si può raffreddare con un sistema meno elaborato e/o rumoroso.

I consumi sono un aspetto fondamentale anche della progettazione della GPU stessa, in quanto più i consumi sono bassi, più si può spingere sull'acceleratore delle prestazioni. Le prestazioni di una GPU sono spesso limitate dalla quantità di calore che può dissipare, perciò un progetto efficiente si traduce in maggiori prestazioni. Insomma, realizzare un'architettura con ottime prestazioni per watt è fondamentale.

Finora rilevare i consumi in modo preciso non era affatto semplice: esistono alcuni software più o meno accurati che leggono i sensori a bordo delle schede, ma per avere informazioni dettagliate e a prova di bomba era necessario dotarsi di una strumentazione molto costosa. In casa Nvidia hanno deciso di correre in aiuto delle redazioni creando PCAT, acronimo di Power Capture Analysis Tool. Di cosa si tratta?

È una combinazione di hardware e software che consente di avere informazioni accurate sulle prestazioni per watt, il consumo della GPU e quello totale di una scheda video, il cosiddetto TGP (Total Graphics Power). PCAT si compone di alcuni componenti fisici: una scheda riser PCI Express da inserire tra la scheda video e lo slot PCI Express della motherboard in modo da registrare la richiesta energetica da parte di quel canale. I dati sono poi inviati al modulo PCAT tramite un cavo dati Dupont a 4 pin e da lì al software che li rileva e ne consente l'analisi.

Il sistema messo a punto da Nvidia funziona con le GPU di qualsiasi produttore, non si affida a chiamate API private, non richiede saldature e restituisce una misura diretta e accurata (a seconda della tensione misurata è precisa al millesimo di watt secondo l'azienda) del consumo della scheda video. Concentriamoci un attimo sul modulo PCAT.

Come potete vedere, è formato da tre connettori a 8 pin su ciascun lato, con uno shunt tra ogni coppia di connettori che legge e cattura con precisione i dati di consumo dai cavi di alimentazione PCIe che partono dall'alimentatore e arrivano alla GPU. I dati ottenuti dai cavi PCIe a 6 e 8 pin dall'alimentatore sono combinati con quelli ottenuti dal connettore riser e inviati al PC mediante un cavo micro USB dal modulo PCAT.

Sul modulo PCAT in nostro possesso è presente uno schermo OLED da 0,91 pollici da 128x32 pixel che mostra i valori rilevati in tempo reale, sotto carico e in idle. Si tratta però di uno schermo assolutamente opzionale, non serve per far funzionare il sistema, ma oltre alla potenza totale totale, mostra quanta potenza, corrente e tensione è richiesta da ogni cavo PCIe 12V connesso al modulo.

Una volta assemblato il tutto si arriva alla parte software ovvero PCAT Power Profile Analyzer. Si tratta del software che permette di capire cosa stanno registrando la board e la scheda riser. Nella parte alta a sinistra del software vediamo il riquadro TOTAL, con il consumo totale della GPU in quell'istante (con valori minimi, massimi e medi in costante aggiornamento). A destra ci sono le letture dei tre connettori a 8 pin 12V dall'alimentatore, quello legato allo slot della motherboard, insieme ai valori registrati dal canale 3,3V e quello 3,3V ausiliario.

A destra, nella parte centrale e bassa, ci sono alcune opzioni per modificare il grafico in tempo reale che vedete al centro: si tratta di opzioni sia di tempo che di visualizzazione dei canali di tensione monitorati. Nella parte alta, invece, potete vedere la voce più importate, "Log Data", che consente di registrare molte informazioni sui consumi delle schede video e le richieste ai vari canali grazie alla creazione di un .CSV con i dati necessari.

Solo per quanto riguarda le schede Nvidia, è possibile usare FrameView (un tool che potete scaricare gratuitamente e che vi risulterà utile per monitorare le prestazioni della GPU e a scopi di test) insieme a PCAT, permettendo a FrameView di intercettare le rilevazioni di PCAT e includerle nei log di FrameView, combinando frame rate e dati di consumo in un log. Purtroppo al momento le API AMD usate da FrameView riportano un valore per le schede Radeon che sembra a metà tra il consumo della GPU e della scheda intera, perciò non è possibile usare FrameView per mettere in relazione diretta il consumo di una GPU AMD e una GPU Nvidia.

Nvidia ha inoltre creato un foglio Excel (FrameView Analysis Template) per facilitare l'analisi e la comparazione di tre insiemi di dati, quindi potenzialmente tre schede video impegnate nello stesso carico di lavoro. Qui sopra vedete alcuni screenshot del file Excel in questione, in cui è possibile importare i log di Frameview e mettere in grafici in dati automaticamente, fornendo sommari e informazioni su possibili problemi di rilevazione.

GeForce Now: l'impatto della latenza sul cloud gaming

GeForce Now: l'impatto della latenza sul cloud gaming Due mesi di Battlefield 6: dalla campagna al battle royale, è l'FPS che stavamo aspettando

Due mesi di Battlefield 6: dalla campagna al battle royale, è l'FPS che stavamo aspettando Antigravity A1: drone futuristico per riprese a 360° in 8K con qualche lacuna da colmare

Antigravity A1: drone futuristico per riprese a 360° in 8K con qualche lacuna da colmare Sony Alpha 7 V, anteprima e novità della nuova 30fps, che tende la mano anche ai creator

Sony Alpha 7 V, anteprima e novità della nuova 30fps, che tende la mano anche ai creator Due GeForce GTX 580 in SLI: l'insospettabile base dell'AI che conosciamo oggi

Due GeForce GTX 580 in SLI: l'insospettabile base dell'AI che conosciamo oggi TSMC dà i numeri: dal processo N7 a quello A14 efficienza migliorata di 4,2 volte

TSMC dà i numeri: dal processo N7 a quello A14 efficienza migliorata di 4,2 volte La ricarica wireless dei Samsung Galaxy S26 sarà più veloce: la conferma da un nuovo accessorio

La ricarica wireless dei Samsung Galaxy S26 sarà più veloce: la conferma da un nuovo accessorio Stop ai social per gli Under 16: l'Australia è pronta e Meta ha iniziato a bloccare gli account

Stop ai social per gli Under 16: l'Australia è pronta e Meta ha iniziato a bloccare gli account Google svela i videogiochi più cercati online (e GTA 6 è solo al settimo posto)

Google svela i videogiochi più cercati online (e GTA 6 è solo al settimo posto) TikTok lancia il nuovo feed con contenuti geolocalizzati

TikTok lancia il nuovo feed con contenuti geolocalizzati Amazon aggiorna gli sconti e si prepara al Natale: inizia la grande corsa ai regali con super promozioni tutti i giorni

Amazon aggiorna gli sconti e si prepara al Natale: inizia la grande corsa ai regali con super promozioni tutti i giorni GeForce NOW: 50% di sconto e 30 nuovi giochi a dicembre 2025

GeForce NOW: 50% di sconto e 30 nuovi giochi a dicembre 2025 Insta360 Ace Pro 2 in offerta: disponibili a prezzi super Pack Standard e Pack Creatori

Insta360 Ace Pro 2 in offerta: disponibili a prezzi super Pack Standard e Pack Creatori Roborock Saros 10R a 909€ invece di 1.399€: il super robot 'anti-grovigli' con stazione 4.0 ora costa molto meno

Roborock Saros 10R a 909€ invece di 1.399€: il super robot 'anti-grovigli' con stazione 4.0 ora costa molto meno Solo oggi due monitor Acer a prezzi assurdi, partono da 119€: ecco quale scegliere per non sbagliare

Solo oggi due monitor Acer a prezzi assurdi, partono da 119€: ecco quale scegliere per non sbagliare FRITZ!Box in forte sconto su Amazon: modem, router e ripetitori Mesh ai minimi dell’anno

FRITZ!Box in forte sconto su Amazon: modem, router e ripetitori Mesh ai minimi dell’anno Apple + Samsung = monopolio totale nel Q3 2025. Che fine ha fatto la concorrenza?

Apple + Samsung = monopolio totale nel Q3 2025. Che fine ha fatto la concorrenza?

11 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoIl kit della latenza per fortuna non mi interessa, sono talmente pigro che non riconosco le unità di misura inferiori al secondo per quanto riguarda le periferiche di input

ps: quindi con la prossima rece fate la mega combo con riesumazione di FCAT+PCAT+LDAT?

Morale: FCAT non c'è più... da quando FCAT è sparito?

Vabbeh ma l'accrocchio per misurare l'assorbimento della scheda è un dispositivo analogico, mica può favorire nvidia rispetto ad amd.

Quell'affare puoi usarlo per misurare l'assorbimento di qualsiasi scheda, presumo già esistano kit del genere.

Senza considerare che si può stimare il consumo della scheda misurando con un wattmetro collegato alla PSU del sistema, testi prima con la grafica integrata e poi con la scheda e i numeri più o meno sono quelli...

bravi bravi

vi sono arrivati i giocattoli nuovi!

Bene, ora voglio che vi scateniate alla prossima rece !

si vedono gli occhi sbrilluccicosi anche da qui!

La vergogna......

Quelli sono strumenti: o funzionano per quello per cui sono nati, o no. Non c'è la terza via.

E se c'è qualcuno che pensi che non funzionino bene appositamente su prodotti diversi da quelli nVidia (quindi per favorire quest'ultima), dovrebbe DIMOSTRARLO.

Quelli sono strumenti: o funzionano per quello per cui sono nati, o no. Non c'è la terza via.

E se c'è qualcuno che pensi che non funzionino bene appositamente su prodotti diversi da quelli nVidia (quindi per favorire quest'ultima), dovrebbe DIMOSTRARLO.

Come mai FCAT è sparito dalle rece in giro per il web?

Non funziona più?

Strano eh...

E cmq commento: perché mai dovrei usare strumenti forniti da uno dei due competitor per fare le recensioni quando posso usare quelli (precisissimi) che uso da sempre?

Non ha alcun senso..

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".