OpenAI annuncia il nuovo piano ChatGPT Pro da 229 euro al mese: cosa offre

OpenAI ha lanciato ChatGPT Pro, un abbonamento mensile da 229 euro che offre accesso illimitato ai modelli IA più potenti dell'azienda. L'azienda decide così di espandere molto la sua offerta, promettendo prestazioni superiori in matematica, scienze e programmazione.

di Nino Grasso pubblicata il 06 Dicembre 2024, alle 10:21 nel canale WebOpenAIChatGPT

OpenAI ha annunciato il lancio di ChatGPT Pro, un nuovo servizio premium che promette di ridefinire le interazioni con l'intelligenza artificiale. Questo abbonamento mensile, dal costo di 229 euro in Europa, offre agli utenti un accesso senza precedenti alle capacità più avanzate dell'azienda nel campo dell'intelligenza artificiale generativa.

Il nuovo servizio include l'accesso illimitato a OpenAI o1, la versione più recente e potente del modello di linguaggio di OpenAI, insieme a GPT-4o e alla modalità Advanced Voice. La caratteristica più notevole di ChatGPT Pro è la o1 pro mode, che viene spiegata così dall'azienda:

"È una versione di o1 che utilizza più potenza di calcolo per pensare più a fondo e fornire risposte ancora migliori ai problemi più difficili. In futuro, prevediamo di aggiungere a questo piano funzionalità di produttività più potenti e ad alta intensità di calcolo .

ChatGPT Pro a 229 euro: come si confronta con la variante Plus

ChatGPT Pro, con la o1 pro mode, rappresenta un significativo avanzamento rispetto alle versioni precedenti: gli utenti possono aspettarsi un modello più veloce, potente e soprattutto accurato, particolarmente efficace nella codifica e nei calcoli matematici. Una delle novità più interessanti è la capacità di fornire risposte ragionate alle immagini, aprendo nuove possibilità di interazione tra testo e contenuti visivi, mentre OpenAI ha anche lavorato per garantire risposte più concise da parte del modello, promettendo tempi di risposta più rapidi. Questa ottimizzazione dovrebbe rendere l'interazione con ChatGPT Pro più fluida e efficiente, un aspetto cruciale per gli utenti che necessitano di risposte rapide e precise.

Per comprendere meglio il valore di ChatGPT Pro, è utile confrontarlo con l'attuale piano ChatGPT Plus, che ha un costo di 20 dollari al meser rispetto ai 200 dollari del Pro sul mercato americano. ChatGPT Plus offre già una serie di vantaggi significativi, tra cui l'accesso anticipato a nuove funzionalità come Canvas, l'utilizzo di modelli come OpenAI o1-preview, o1-mini, GPT-4o, GPT-4o mini e GPT-4. Gli utenti Plus possono inviare fino a 5 volte più messaggi per GPT-4o rispetto alla versione gratuita, e hanno accesso a funzionalità come l'analisi dei dati, il caricamento di file, la visione, la navigazione web e la generazione di immagini, oltre alla modalità vocale avanzata. Si tratta di un pacchetto già completo.

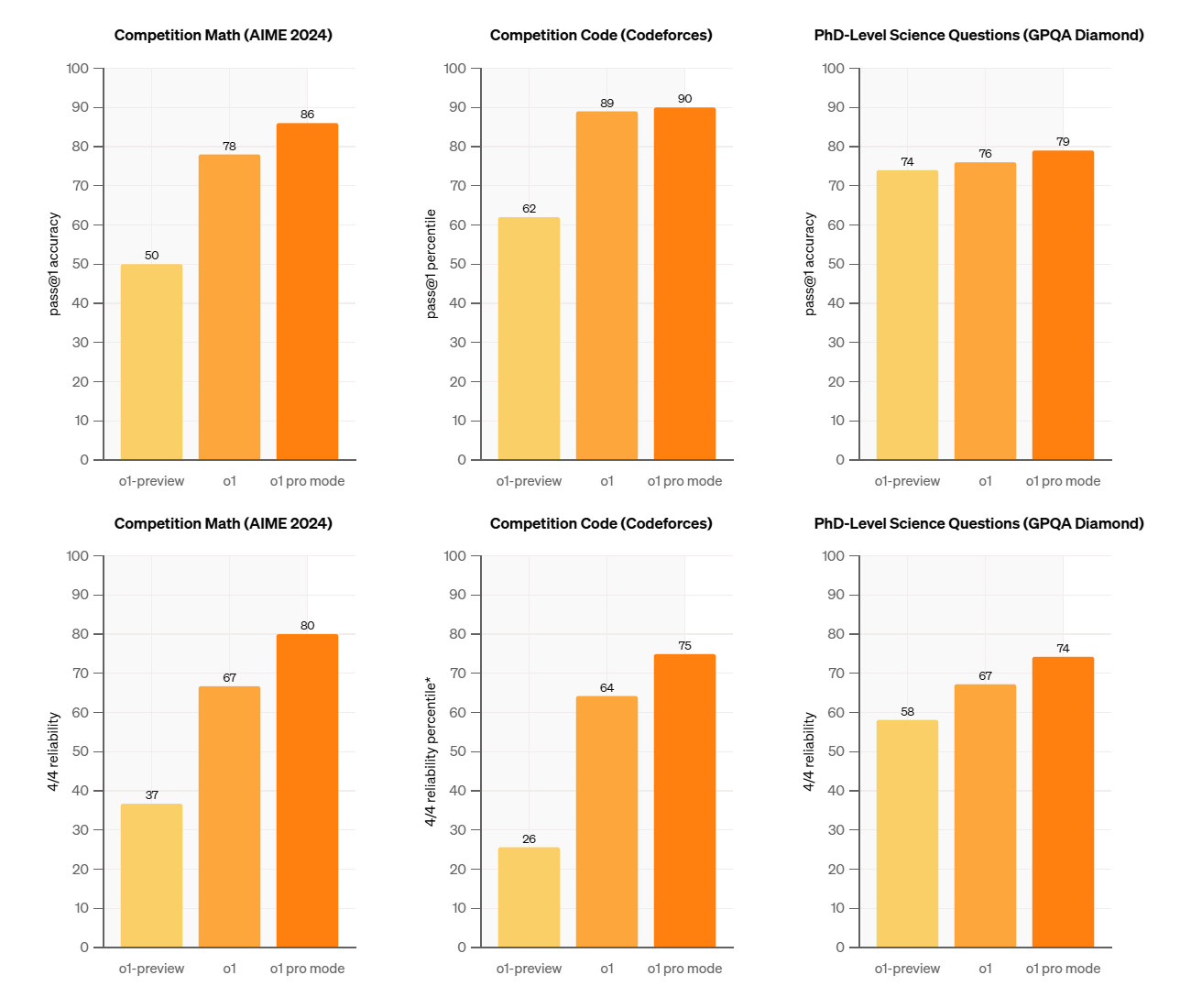

ChatGPT Pro, costando dieci volte di più, offre vantaggi significativi per le sessioni d'uso più intensive: oltre a tutto quello che è presente nel piano Plus, gli utenti Pro avranno accesso illimitato alla versione completa di o1, che sostituisce l'o1-preview, e alla modalità o1 pro, che utilizza una potenza di calcolo superiore per affrontare i problemi più complessi. ChatGPT Pro promette prestazioni sensibilmente migliori su benchmark ML impegnativi in matematica, scienze e programmazione rispetto a o1 e o1-preview, che l'azienda ha sintetizzato in una serie di grafici durante il lancio iniziale.

Nonostante l'entusiasmo per i diversi vantaggi del nuovo piano di abbonamento, il prezzo di ChatGPT Pro solleva alcune perplessità: con un costo dieci volte superiore rispetto al piano Plus, è normale chiedersi se il valore aggiunto giustifichi un tale investimento. OpenAI sembra puntare su un pubblico di professionisti e ricercatori che hanno assolutamente bisogno di capacità IA avanzate per i loro progetti più impegnativi. Per incentivare l'adozione di ChatGPT Pro nel campo della ricerca, OpenAI ha annunciato un programma di sovvenzioni che assegnerà 10 abbonamenti gratuiti a ricercatori medici di istituzioni di prestigio. L'azienda ha in programma di estendere queste sovvenzioni ad altre discipline, dimostrando il suo impegno nel supportare l'avanzamento scientifico attraverso l'intelligenza artificiale.

Gli utenti europei potranno accedere a ChatGPT Pro al costo di £200 o €229 al mese. OpenAI ha inoltre previsto un sistema di credito proporzionale per chi decide di passare dal piano Plus a quello Pro, facilitando la transizione per gli utenti esistenti.

DJI Mavic 4 Pro: sblocca un nuovo livello per le riprese aeree

DJI Mavic 4 Pro: sblocca un nuovo livello per le riprese aeree Idrogeno verde in Europa: nuovi studi prevedono costi ben superiori alle aspettative

Idrogeno verde in Europa: nuovi studi prevedono costi ben superiori alle aspettative Mario Kart World lancia Switch 2: la magia Nintendo ora in 4K

Mario Kart World lancia Switch 2: la magia Nintendo ora in 4K Scambio di chiavi quantistico via satellite: Colt, Honeywell e Nokia ci provano. Ma ha senso?

Scambio di chiavi quantistico via satellite: Colt, Honeywell e Nokia ci provano. Ma ha senso? HONOR 400 è un successo! Forte slancio nelle vendite con un +400%

HONOR 400 è un successo! Forte slancio nelle vendite con un +400% Redmi Pad 2, i nuovi tablet Xiaomi costano a partire da 200 euro: ecco le novità

Redmi Pad 2, i nuovi tablet Xiaomi costano a partire da 200 euro: ecco le novità All'aeroporto di Fiumicino il più grande sistema di accumulo italiano con batterie EV usate

All'aeroporto di Fiumicino il più grande sistema di accumulo italiano con batterie EV usate HONOR 400 vs HONOR 400 Pro: tutte le differenze, le specifiche e i punti di forza a confronto

HONOR 400 vs HONOR 400 Pro: tutte le differenze, le specifiche e i punti di forza a confronto Nintendo Switch 2 debutta oggi nei negozi! Prezzo e dettagli

Nintendo Switch 2 debutta oggi nei negozi! Prezzo e dettagli Samsung Galaxy S25 Edge è disponibile in Italia! Lo smartphone sottile, potente e intelligente come mai prima

Samsung Galaxy S25 Edge è disponibile in Italia! Lo smartphone sottile, potente e intelligente come mai prima  Nothing presenterà le sue prime cuffie over-ear il prossimo 1° luglio insieme a Phone(3)

Nothing presenterà le sue prime cuffie over-ear il prossimo 1° luglio insieme a Phone(3)  Le nuove soluzioni Lenovo per lo storage e oltre: ThinkAgile, ThinkSystem e gli AI Starter Kit

Le nuove soluzioni Lenovo per lo storage e oltre: ThinkAgile, ThinkSystem e gli AI Starter Kit Netatmo presenta la nuova Stazione Meteo ORIGINAL: aggiornata, potenziata con misurazione pollini e UV

Netatmo presenta la nuova Stazione Meteo ORIGINAL: aggiornata, potenziata con misurazione pollini e UV Cybersecurity: Fortinet rende disponibile Workspace Security Suite e aggiorna FortiDLP

Cybersecurity: Fortinet rende disponibile Workspace Security Suite e aggiorna FortiDLP Netatmo Stazione Meteo ORIGINAL: il ritorno di un’icona, più smart che mai

Netatmo Stazione Meteo ORIGINAL: il ritorno di un’icona, più smart che mai Il meglio dello State of Play, dal nuovo titolo di Suda51 alla collezione più completa di Mortal Kombat

Il meglio dello State of Play, dal nuovo titolo di Suda51 alla collezione più completa di Mortal Kombat Homematic IP: nuova app per ottimizzare i flussi energetici della casa

Homematic IP: nuova app per ottimizzare i flussi energetici della casa

12 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoIl problema non è (solo) la potenza di calcolo, il problema è la memoria MOLTO LIMITATA del maledetto affare.

Per ragioni personali ho acquistato un mese di Chat GPT plus ed approfittando dell'occasione gli ho dato in pasto alcuni capitoli di un libro personale che ho scritto e... cosa scopro? che non il coso non riesce nemmeno ad elaborare un singolo capitolo (87 mila caratteri) nella sua interezza, figuriamoci un intero volume o l'intero libro....ridicoli.

Il problema non è (solo) la potenza di calcolo, il problema è la memoria MOLTO LIMITATA del maledetto affare.

Per ragioni personali ho acquistato un mese di Chat GPT plus ed approfittando dell'occasione gli ho dato in pasto alcuni capitoli di un libro personale che ho scritto e... cosa scopro? che non il coso non riesce nemmeno ad elaborare un singolo capitolo (87 mila caratteri) nella sua interezza, figuriamoci un intero volume o l'intero libro....ridicoli.

vorrei capire cosa intendi con dare in pasto, cioè come hai chiesto di fare un training con il tuo libro? hai creato u nmodello gpt custom oppure gli hai allegato il pdf e detto leggilo?

Il mio primo approccio è stato quello di fornire i capitoli uno ad uno, l'idea era quella di fare un analisi per individuare eventuali problemi di narrativa (buchi di trama / errori di continuità ed altre incongruenze esplicite) .

Dopo diversi capitoli mi sono accorto che l'analisi di ogni capitolo non includeva le parti finali; Ho chiesto allora al IA di fare dei riassunti invece che delle analisi ed il problema è risultato essere subito lampante: l'IA semplicemente smetteva di leggere dopo circa la metà dei capitoli (in media 10/12 mila parole l'uno), ed anche quando chi chiedevo esplicitamente di fare il riassunto della "Seconda parte" del capitolo l'IA si è dimostrato totalmente incapace di reperire l'altra metà del capitolo, limitandosi al ripetere fino alla nausea il riassunto della prima metà.

Ho provato tanti modi per aggirare il problema (a parte quello di dividere i capitoli in parti più piccoli),compreso il chiedere al IA di NON ripetere le parti riassunte già citate ma .... totalmente inutile, l'IA continuava a ripetere ancora ed ancora le stesse parti nonostante i miei ripetuti espliciti comandi di non ripetere le parti già citate, era come parlare con un sordo.

In seguito, ho anche provato con un modello GPT personalizzato, allegando questa volta l'intero primo volume (7 capitoli / 88 mila parole o 420 caratteri circa) e... il problema rimaneva invariato.

Sebbene "Tecnicamente" l'IA aveva l'accesso completo a tutti e sette i capitoli, non era in grado di fare un analisi comprensiva perché andava ben oltre la sua molto limitata memoria.

Potevo chiedergli di individuare una particolare scena e ci riusciva, ma se gli chiedevo di fare un elenco, a titolo di esempio, di tutte le scene nei sette capitoli dove personaggio X ha parlato con personaggio Y ne elencava solo alcune dichiarando con la sua solita insopportabile sicurezza e confidenza che quelle erano tutte le scene in questione.

Ho letto da qualche parte che questa limitazione si chiama "Finestra di contesto" o qualcosa del genere, ovvero la quantità di informazioni che l'IA può elaborare contemporaneamente, che è diverso dal semplice avere a disposizione. Nel caso mio ad esempio pur avendo a disposizione documenti per 88 mila parole, di fatto un analisi che comprendesse il ricordare un numero di contenuti superiori a 10 mila parole era fuori questione.

Quindi quando leggo la notizia che "Aumenta la potenza di calcolo" sinceramente me ne frego altamente, la limitazione maggiore che vedo al momento è la memoria, non la potenza di calcolo(Anche se le due cose sono tecnicamente legate in questo contesto indicano cose differenti).

Dopo diversi capitoli mi sono accorto che l'analisi di ogni capitolo non includeva le parti finali; Ho chiesto allora al IA di fare dei riassunti invece che delle analisi ed il problema è risultato essere subito lampante: l'IA semplicemente smetteva di leggere dopo circa la metà dei capitoli (in media 10/12 mila parole l'uno), ed anche quando chi chiedevo esplicitamente di fare il riassunto della "Seconda parte" del capitolo l'IA si è dimostrato totalmente incapace di reperire l'altra metà del capitolo, limitandosi al ripetere fino alla nausea il riassunto della prima metà.

Ho provato tanti modi per aggirare il problema (a parte quello di dividere i capitoli in parti più piccoli),compreso il chiedere al IA di NON ripetere le parti riassunte già citate ma .... totalmente inutile, l'IA continuava a ripetere ancora ed ancora le stesse parti nonostante i miei ripetuti espliciti comandi di non ripetere le parti già citate, era come parlare con un sordo.

In seguito, ho anche provato con un modello GPT personalizzato, allegando questa volta l'intero primo volume (7 capitoli / 88 mila parole o 420 caratteri circa) e... il problema rimaneva invariato.

Sebbene "Tecnicamente" l'IA aveva l'accesso completo a tutti e sette i capitoli, non era in grado di fare un analisi comprensiva perché andava ben oltre la sua molto limitata memoria.

Potevo chiedergli di individuare una particolare scena e ci riusciva, ma se gli chiedevo di fare un elenco, a titolo di esempio, di tutte le scene nei sette capitoli dove personaggio X ha parlato con personaggio Y ne elencava solo alcune dichiarando con la sua solita insopportabile sicurezza e confidenza che quelle erano tutte le scene in questione.

Ho letto da qualche parte che questa limitazione si chiama "Finestra di contesto" o qualcosa del genere, ovvero la quantità di informazioni che l'IA può elaborare contemporaneamente, che è diverso dal semplice avere a disposizione. Nel caso mio ad esempio pur avendo a disposizione documenti per 88 mila parole, di fatto un analisi che comprendesse il ricordare un numero di contenuti superiori a 10 mila parole era fuori questione.

Quindi quando leggo la notizia che "Aumenta la potenza di calcolo" sinceramente me ne frego altamente, la limitazione maggiore che vedo al momento è la memoria, non la potenza di calcolo(Anche se le due cose sono tecnicamente legate in questo contesto indicano cose differenti).

mi piacerebbe capire con che termini dici "" truffa "".

Hai qualcosa che fino a 2 anni fa non esisteva, e che fino a 2 anni fa avresto dovuto farlo a mano (ammesso avere le capacitá di farle, sia chiaro, non sto dicendo che non sei capace, ma ci sono lavori e lavori. Chi scrive un libro NON é chi lo corregge, mai), oppure affidarti appunto ad un terzo.

Dagli chunks piú piccoli. Il tuo approccio e' un caso limite. 87 mila caratteri sono circa 100 pagine di testo...

Hai qualcosa che fino a 2 anni fa non esisteva, e che fino a 2 anni fa avresto dovuto farlo a mano (ammesso avere le capacitá di farle, sia chiaro, non sto dicendo che non sei capace, ma ci sono lavori e lavori. Chi scrive un libro NON é chi lo corregge, mai), oppure affidarti appunto ad un terzo.

Dagli chunks piú piccoli. Il tuo approccio e' un caso limite. 87 mila caratteri sono circa 100 pagine di testo...

Truffa nel senso che la differenza di prezzo non credo che giustifichi la differenza di prestazioni.

Inoltre dargli chunks più piccoli come dici tu non funziona se il genere di analisi richiede di prendere l'intero contesto in memoria.

Faccio un esempio facile facile:

Mettiamo che nel capitolo 3 un personaggio si rompe il braccio sinistro, poi nel capitolo 28 viene detto in un dialogo random tra due personaggi che il personaggio di prima si è rotto il braccio destro in quel evento. Questo è il genere di errore che puoi scoprire solo se ti ricordi quale braccio si è rotto il tizio 25 capitoli prima, o in alternativa devi controllare ogni volta l'intero libro per verificare che una affermazione sia congruente.

Quindi no, non funziona dividerlo in chunks

Certo, si tratta sempre di cercare incongruenze tra versioni già conndensate non complete dell'informazione.

Stanno bruciando risorse in maniera assurda sperando che prima o poi spunti fuori qualcosa di irrinunciabile per l'utilizzatore generico, e più non hanno risultati tangibili e più devono investire risorse per tener su l'hype in proposito.

Il problema non è (solo) la potenza di calcolo, il problema è la memoria MOLTO LIMITATA del maledetto affare.

Per ragioni personali ho acquistato un mese di Chat GPT plus ed approfittando dell'occasione gli ho dato in pasto alcuni capitoli di un libro personale che ho scritto e... cosa scopro? che non il coso non riesce nemmeno ad elaborare un singolo capitolo (87 mila caratteri) nella sua interezza, figuriamoci un intero volume o l'intero libro....ridicoli.

Capisco probabilmente non sia il tuo settore ma non stai usando lo strumento giusto. Innanzitutto se ti serve una context window enorme ti conviene usare Gemini di Google che ne ha una da 1B (circa 5 volte gpt), in secondo luogo quello che vuoi fare tu non ha senso in uno strumento generalista tipo chat gpt. Quello che vuoi fare tu è meglio farlo usando un sistema chiamato "embeddings", gpt pro da web ha un parziale supporto gli puoi dare in pasto degli attachment nella sezione per creare agenti personalizzati. Ma diciamo che in generale serve un approccio più complesso.

In altre parole uno strumento proposto come "generalista" non riesce a fare quello che un utilizzatore si aspetta sia "banale" per uno strumento di quel tipo e serve invece un setup che richiede maggiori competenze da parte dell'utilizzatore.

E non si tratta di un caso isolato.

Qui il problema non è (solo) tecnologico, questo è un sintomo del problema di fondo che si nasconde dentro la bolla speculativa costruita attorno ad una tecnologia utile (i LLM) ma che viene commercializzata a colpi di hype e FUD ovvero a fasi alterne di "questo ci porterà alla nuova età dell'oro" alternate a "se resti indietro su questo, finirai disoccupato ed in miseria".

La cosa più assurda è che visto che in questo momento a guadagnarci sono i produttori di hardware i fornitori di capacità di calcolo e storage sul cloud e le aziende che pompano le quotazioni delle loro azioni a colpi di hype sui LLM, non c'è manco un modello di business sostenibile a parte quello di Microsoft (slurpare ancora più dati dagli utenti dei loro servizi "AI" e rendere ancora più esteso il lock-in dei loro prodotti per le aziende), ma tale approccio si basa su una posizione già dominante.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".