NVIDIA DGX GH200: 256 Grace Hopper Superchip insieme per il prossimo ChatGPT

NVIDIA ha annunciato DGX GH200, un potentissimo supercomputer che, grazie a 256 Grace Hopper Superchip, può offrire una potenza di calcolo fino a 1 exaflop per l'intelligenza artificiale generativa. Google, Meta e Microsoft le prime ad accedervi.

di Manolo De Agostini pubblicata il 29 Maggio 2023, alle 09:01 nel canale Server e WorkstationNVIDIAGraceHopper

Al Computex 2023 NVIDIA ha annunciato "DGX GH200", un nuovo supercomputer pensato per favorire "lo sviluppo di enormi modelli di AI generativa" per l'applicazione nel settore linguistico (come ChatGPT), nell'analisi dati e nei sistemi di raccomandazione.

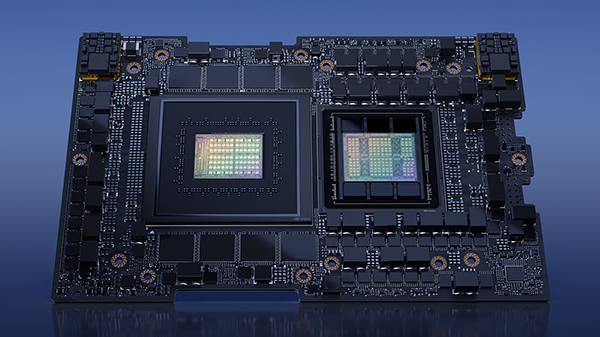

Il cuore di NVIDIA DGX GH200 prevede 256 Grace Hopper Superchip in grado di lavorare come una singola GPU con un'enorme spazio di memoria condiviso grazie all'interconnessione NVLink e al nuovo NVLink Switch System.

In questo modo NVIDIA DGX GH200 può offrire una potenza di calcolo fino a 1 exaflop con calcoli FP8 e ben 144 TB di memoria condivisa, valore quest'ultimo che rappresenta "quasi 500 volte più memoria rispetto alla precedente generazione NVIDIA DGX A100 introdotta nel 2020".

Ogni Grace Hopper Superchip prevede sullo stesso package una CPU NVIDIA Grace con 72 core e una GPU NVIDIA H100 Tensor Core, collegate tra loro mediante l'interconnessione NVIDIA NVLink-C2C. Rispetto al collegamento tramite bus PCI Express, CPU e GPU possono scambiarsi dati con una bandwidth fino a 7 volte maggiore (dai 128 GB/s del PCIe 5.0 si passa ai 900 GB/s di NVLink-C2C) e ridurre il consumo legato all'interconnessione di oltre 5 volte.

DGX GH200 è il primo supercomputer ad accoppiare Grace Hopper Superchip e NVIDIA NVLink Switch System, una nuova interconnessione che consente a tutte le GPU del sistema DGX GH200 di lavorare insieme come fossero una sola. La generazione precedente consentiva a solo otto GPU di sfruttare NVLink per operare come un'unica GPU senza compromettere le prestazioni. La nuova architettura di DGX GH200, inoltre, è in grado di fornire una bandwidth NVLink 48 volte maggiore rispetto alla scorsa generazione.

Google Cloud, Meta e Microsoft sono le prime società ad aver deciso di acquistare DGX GH200 per esplorarne le capacità nella gestione dei carichi di lavoro di IA generativa. NVIDIA intende rendere disponibile il progetto di DGX GH200 ai provider di servizi cloud e hyperscaler in modo che possano personalizzarlo ulteriormente per la loro infrastruttura.

NVIDIA ha annunciato contestualmente che NVIDIA GH200 Grace Hopper Superchip è in piena produzione e che sta costruendo il suo primo supercomputer basato su DGX GH200 per dare una marcia in più ai suoi ricercatori e team di sviluppo.

Il frutto di tale impegno si chiama NVIDIA Helios, un sistema basato su quattro DGX GH200, ognuno interconnesso con NVIDIA Quantum-2 InfiniBand. Helios include 1024 Grace Hopper Superchip e sarà messo in funzione entro fine anno.

BOOX Note Air4 C è uno spettacolo: il tablet E Ink con Android per lettura e scrittura

BOOX Note Air4 C è uno spettacolo: il tablet E Ink con Android per lettura e scrittura Recensione Sony Xperia 1 VII: lo smartphone per gli appassionati di fotografia

Recensione Sony Xperia 1 VII: lo smartphone per gli appassionati di fotografia Attenti a Poco F7: può essere il best buy del 2025. Recensione

Attenti a Poco F7: può essere il best buy del 2025. Recensione DJI OSMO Mobile SE a 69€: il gimbal compatto che trasforma i video dello smartphone in riprese da pro

DJI OSMO Mobile SE a 69€: il gimbal compatto che trasforma i video dello smartphone in riprese da pro Scope elettriche da record su Amazon: due modelli potentissimi sotto i 120€, ecco perché piacciono così tanto

Scope elettriche da record su Amazon: due modelli potentissimi sotto i 120€, ecco perché piacciono così tanto GTA 6 a 80 euro? Take-Two frena sul prezzo e punta tutto sul valore percepito

GTA 6 a 80 euro? Take-Two frena sul prezzo e punta tutto sul valore percepito I 3 portatili più convenienti su Amazon: sono 2 tuttofare Lenovo e un HP Victus gaming con RTX 5060

I 3 portatili più convenienti su Amazon: sono 2 tuttofare Lenovo e un HP Victus gaming con RTX 5060 AirPods Pro 2 a soli 199€: su Amazon anche AirPods 4 in sconto, ecco le differenze che contano

AirPods Pro 2 a soli 199€: su Amazon anche AirPods 4 in sconto, ecco le differenze che contano 2 Smart TV 4K Hisense con doppio sconto su Amazon: sono OLED e QLED, 55" e 75", fateci un bel pensierino

2 Smart TV 4K Hisense con doppio sconto su Amazon: sono OLED e QLED, 55" e 75", fateci un bel pensierino Portatili Apple ai minimi: MacBook Pro con chip M4 a 1.648€ e Macbook Air 13 16GB7256GB, sempre M4, a 998€

Portatili Apple ai minimi: MacBook Pro con chip M4 a 1.648€ e Macbook Air 13 16GB7256GB, sempre M4, a 998€ Come mantenere Windows 10 sicuro dopo il 2025: tutto sul programma ESU

Come mantenere Windows 10 sicuro dopo il 2025: tutto sul programma ESU Finalmente è tornato su Amazon l'iPhone 16 128GB a 749€, in tutti i colori, ma ci sono anche i 16e e 16 Pro in offerta

Finalmente è tornato su Amazon l'iPhone 16 128GB a 749€, in tutti i colori, ma ci sono anche i 16e e 16 Pro in offerta Auto nuove? Per il 65% degli italiani sono troppo care, non dovrebbero costare oltre i 20.000 euro

Auto nuove? Per il 65% degli italiani sono troppo care, non dovrebbero costare oltre i 20.000 euro Droni solari Airbus volano nella stratosfera grazie alle nuove batterie al silicio: test riusciti a oltre 20 km di quota

Droni solari Airbus volano nella stratosfera grazie alle nuove batterie al silicio: test riusciti a oltre 20 km di quota Colpo da 15 milioni di dollari: chi ha rubato un carico di prodotti AMD e Apple?

Colpo da 15 milioni di dollari: chi ha rubato un carico di prodotti AMD e Apple? Elon Musk lancia l'allarme su GPT-5: 'OpenAI divorerà Microsoft'. Ma Nadella lo sfida con un sorriso

Elon Musk lancia l'allarme su GPT-5: 'OpenAI divorerà Microsoft'. Ma Nadella lo sfida con un sorriso iPhone 17 Pro sarà più costoso, ma anche più conveniente

iPhone 17 Pro sarà più costoso, ma anche più conveniente

2 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoMi riprendo al discorso fatto con la tecnologia Nvidia Ace,così hanno la scusa di ammortizzare i costi di sviluppo e progettazione,aumentando il costo delle schede video per le nuove feature.

900 GB/s di banda passante

Spero si riescano a raggiungere grandi risultati con questo nuovo chip.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".