Il fenomeno DeepSeek fa male a NVIDIA: il titolo crolla in Borsa, ma l'azienda non si scompone

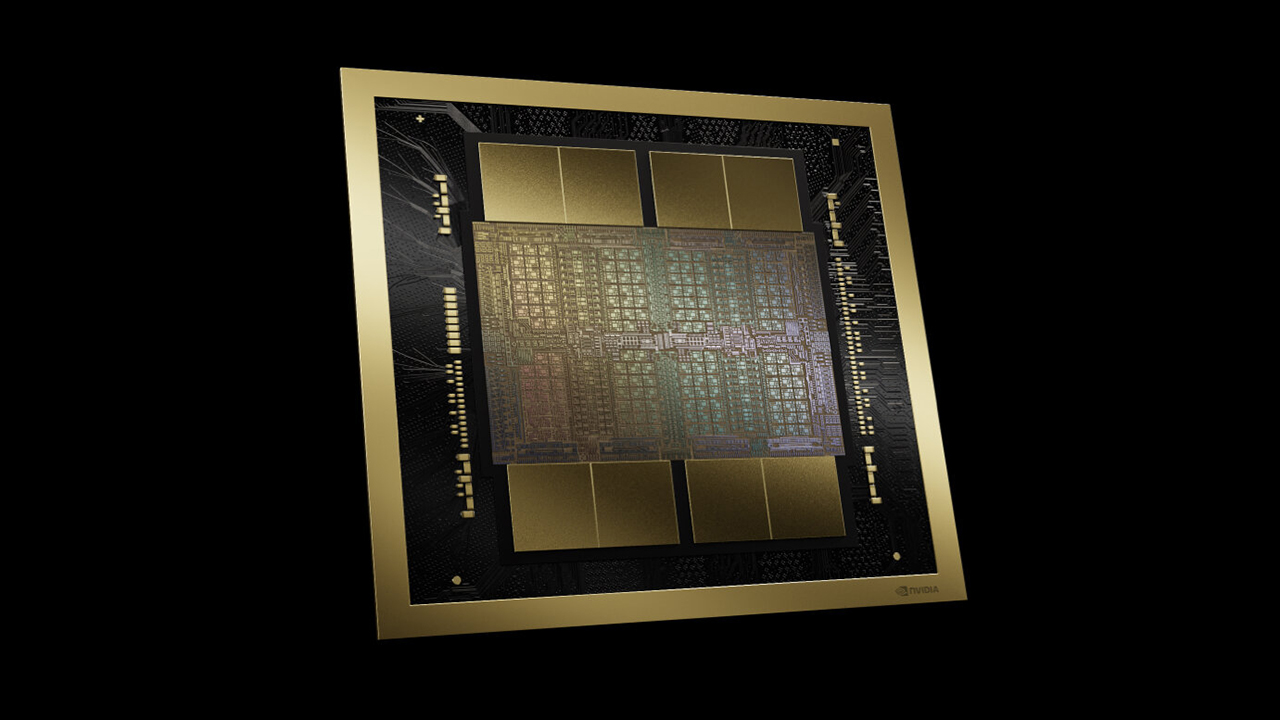

Giornata nerissima per il titolo NVIDIA in Borsa. Il panico creato dal rilascio del modello IA cinese DeepSeek-R1 ha scatenato le vendite, facendo crollare le azioni di quasi il 17%. NVIDIA, tuttavia, non si scompone troppo.

di Manolo De Agostini pubblicata il 27 Gennaio 2025, alle 22:31 nel canale MercatoDeepSeekNVIDIA

Il titolo NVIDIA ha subito una perdita del 17% nella giornata odierna, con una riduzione della capitalizzazione di mercato da 3.347 a circa 2.900 miliardi di dollari.

L'arrivo del fulmine a ciel sereno chiamato DeepSeek-R1, il nuovo modello di IA cinese dalle capacità strabilianti, addestrato con appena 6 milioni di dollari di investimenti e dell'hardware impiegati per riferimenti come OpenAI GPT-4o e Claude Sonnet 3.5, ha creato un'ondata di panico negli Stati Uniti.

NVIDIA, che è stata la principale beneficiaria di questi immensi investimenti, potrebbe assistere a una contrazione degli ordini qualora modelli come DeepSeek-R1 si rivelassero efficaci. Al momento, però, Jensen Huang e compagni non sembrano scomporsi più di tanto.

NVIDIA ha dichiarato che un nuovo modello rilasciato dalla startup cinese DeepSeek è un "eccellente progresso dell'intelligenza artificiale" che rispetta i controlli sulle esportazioni di tecnologia negli Stati Uniti.

"Il lavoro di DeepSeek illustra come sia possibile creare nuovi modelli" utilizzando la tecnica Test Time Scaling, ha dichiarato l'azienda in un comunicato inviato via e-mail alla CNBC, "sfruttando modelli e calcoli ampiamente disponibili e pienamente conformi ai controlli sulle esportazioni".

NVIDIA sottolinea che l'azienda cinese non ha violato le restrizioni statunitensi che limitano l'accesso ai chip americani avanzati per addestrare le IA. DeepSeek, infatti, ha utilizzato acceleratori NVIDIA H800, versioni depotenziate rispetto a quelle commercializzate da NVIDIA nel resto del mondo.

La dichiarazione sembra anche dipanare i sospetti di alcuni analisti ed esperti secondo i quali la startup cinese non avrebbe potuto fare la scoperta che ha dichiarato.

NVIDIA, inoltre, sottolinea che l'inferenza, il lavoro di esecuzione dei modelli di intelligenza artificiale, richiede comunque molti dei suoi prodotti. NVIDIA, quindi, non è solo "addestramento".

"L'inferenza richiede un numero significativo di GPU NVIDIA e reti ad alte prestazioni", ha spiegato l'azienda. "Ora abbiamo tre leggi di scaling: pre-training e post-training, che continuano, e la nuova test-time scaling".

Questo concetto afferma che un modello di intelligenza artificiale completamente addestrato, se utilizza più tempo e maggiore potenza di calcolo per eseguire previsioni o generare testo e immagini, migliora significativamente la qualità delle risposte rispetto a un utilizzo più rapido e meno intensivo.

In queste ore il mercato si chiede se gli investimenti multimiliardari da parte di aziende come Microsoft, Google e Meta per le infrastrutture di IA non siano sprecati se gli stessi risultati possono essere ottenuti in modo più economico. La scorsa settimana l'amministratore delegato di Meta, Mark Zuckerberg, ha dichiarato che prevede investire tra i 60 e i 65 miliardi di dollari in spese di capitale nel 2025 come parte della sua strategia di IA. Inoltre, una delle notizie più importanti ha riguardato il progetto Stargate da 500 miliardi di dollari.

Al coro dei pareri illustri si è aggiunto, con un post X, anche l'ex CEO di Intel Pat Gelsinger. L'ex dirigente del produttore di semiconduttori professa cautela, sottolineando che "DeepSeek ci ricorda tre importanti insegnamenti tratti dalla storia dell'informatica".

Il primo è che "l'informatica obbedisce alla legge dei gas. Rendendo l'informatica drasticamente più economica, il mercato si espanderà. I mercati stanno sbagliando, questo renderà l'IA molto più ampiamente distribuita".

Con le sue parole Gelsinger fa riferimento a un'analogia tra il comportamento dell'elaborazione informatica e il principio fisico della legge dei gas. In fisica, la legge dei gas stabilisce che un gas tende a espandersi fino a occupare tutto il volume disponibile. L'analogia nel contesto dell'informatica suggerisce che le attività di calcolo, le risorse o i dati tendono a espandersi per occupare tutto lo spazio o le risorse disponibili.

Il secondo insegnamento è che "l'ingegneria è fatta di vincoli. Gli ingegneri cinesi avevano risorse limitate e dovevano trovare soluzioni creative". Infine, Gelsinger rimarca un suo cavallo di battaglia degli ultimi anni, ovvero "l'open source vince. DeepSeek contribuirà a reimpostare il mondo sempre più chiuso del lavoro sui modelli di IA fondamentali. Un plauso al team di DeepSeek".

BOOX Note Air4 C è uno spettacolo: il tablet E Ink con Android per lettura e scrittura

BOOX Note Air4 C è uno spettacolo: il tablet E Ink con Android per lettura e scrittura Recensione Sony Xperia 1 VII: lo smartphone per gli appassionati di fotografia

Recensione Sony Xperia 1 VII: lo smartphone per gli appassionati di fotografia Attenti a Poco F7: può essere il best buy del 2025. Recensione

Attenti a Poco F7: può essere il best buy del 2025. Recensione DJI OSMO Mobile SE a 69€: il gimbal compatto che trasforma i video dello smartphone in riprese da pro

DJI OSMO Mobile SE a 69€: il gimbal compatto che trasforma i video dello smartphone in riprese da pro Scope elettriche da record su Amazon: due modelli potentissimi sotto i 120€, ecco perché piacciono così tanto

Scope elettriche da record su Amazon: due modelli potentissimi sotto i 120€, ecco perché piacciono così tanto GTA 6 a 80 euro? Take-Two frena sul prezzo e punta tutto sul valore percepito

GTA 6 a 80 euro? Take-Two frena sul prezzo e punta tutto sul valore percepito I 3 portatili più convenienti su Amazon: sono 2 tuttofare Lenovo e un HP Victus gaming con RTX 5060

I 3 portatili più convenienti su Amazon: sono 2 tuttofare Lenovo e un HP Victus gaming con RTX 5060 AirPods Pro 2 a soli 199€: su Amazon anche AirPods 4 in sconto, ecco le differenze che contano

AirPods Pro 2 a soli 199€: su Amazon anche AirPods 4 in sconto, ecco le differenze che contano 2 Smart TV 4K Hisense con doppio sconto su Amazon: sono OLED e QLED, 55" e 75", fateci un bel pensierino

2 Smart TV 4K Hisense con doppio sconto su Amazon: sono OLED e QLED, 55" e 75", fateci un bel pensierino Portatili Apple ai minimi: MacBook Pro con chip M4 a 1.648€ e Macbook Air 13 16GB7256GB, sempre M4, a 998€

Portatili Apple ai minimi: MacBook Pro con chip M4 a 1.648€ e Macbook Air 13 16GB7256GB, sempre M4, a 998€ Come mantenere Windows 10 sicuro dopo il 2025: tutto sul programma ESU

Come mantenere Windows 10 sicuro dopo il 2025: tutto sul programma ESU Finalmente è tornato su Amazon l'iPhone 16 128GB a 749€, in tutti i colori, ma ci sono anche i 16e e 16 Pro in offerta

Finalmente è tornato su Amazon l'iPhone 16 128GB a 749€, in tutti i colori, ma ci sono anche i 16e e 16 Pro in offerta Auto nuove? Per il 65% degli italiani sono troppo care, non dovrebbero costare oltre i 20.000 euro

Auto nuove? Per il 65% degli italiani sono troppo care, non dovrebbero costare oltre i 20.000 euro Droni solari Airbus volano nella stratosfera grazie alle nuove batterie al silicio: test riusciti a oltre 20 km di quota

Droni solari Airbus volano nella stratosfera grazie alle nuove batterie al silicio: test riusciti a oltre 20 km di quota Colpo da 15 milioni di dollari: chi ha rubato un carico di prodotti AMD e Apple?

Colpo da 15 milioni di dollari: chi ha rubato un carico di prodotti AMD e Apple? Elon Musk lancia l'allarme su GPT-5: 'OpenAI divorerà Microsoft'. Ma Nadella lo sfida con un sorriso

Elon Musk lancia l'allarme su GPT-5: 'OpenAI divorerà Microsoft'. Ma Nadella lo sfida con un sorriso iPhone 17 Pro sarà più costoso, ma anche più conveniente

iPhone 17 Pro sarà più costoso, ma anche più conveniente

33 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoQuando lo scopo primario diventa "facciamo più soldi in borsa" la strategia di ricerca va in secondo piano e si privilegiano le tattiche che portano più profitto a breve termine.

Quando lo scopo primario diventa "facciamo più soldi in borsa" la strategia di ricerca va in secondo piano e si privilegiano le tattiche che portano più profitto a breve termine.

Il vino in questo caso però non è male. Il training del modello cinese rimane appannaggio loro (e volendo ci sono pure dei dubbi su quanto “poco” effettivamente abbiano dovuto lavorare sul training primario, ma questo è altro discorso), ma la tecnologia è solida, non la solita cinesata.

Ad ogni modo, USA crede moltissimo nel first mover advantage, tanto in generale come cultura quanto nel caso specifico AI. In una certa misura è inevitabile che gli investimenti in capo all’apripista siano più elevati. Tantopiù se ti chiami USA.

C’è speculazione sopra? Sì. Se questo sia un male tout court però è tutto da dimostrare, i margini speculativi potenziali sono anche un enorme traino. L’alternativa quale sarebbe? Ad oggi, non essere della partita; e personalmente trovo difficile sostenere che questo se sia meglio.

Vedremo, anche perché quello che dicono i cinesi va sempre preso con le pinze.

...prego signori controllare i mie post dell'anno precedente, ma anche del 2023 riguardo ai Cinesi che inesorabili sarebbero arrivati anche in questo campo.

E infatti sono arrivati ! C.V.D.

E infatti sono arrivati ! C.V.D.

un paese che sforna 1.000.000 di ingegneri a l'anno arriva dappertutto

altro che 6 milioni di dollari. Questi hanno circa 50K GPU ed il supporto di un edgefound da miliardi dietro, inoltre il modello foundational utilizzato è LLMA sempre americano, come i chip che lo elaborano.

I Cinesi ed i Giapponesi (ovviamente) che hanno a che fare con tutti sti minimo 2000 Kanji ecc.. li fa in genere dei geni.

Detto questo la fame aguzza l'ingegno e piu' togliete Loro, sanzioni, ecc.. e piu' Loro dovranno cavarsela in qualche maniera ed a volte o spesso saltano fuori con qualcosa che stupisce e frega tutti. (un po' come chi vuole giocare ai triple AAA coi giochi moderni e non ha PC ultra potente perche' non ha soldi da buttare, si impegna e mod di qua, manual fix di la ci riesce in qualche maniera dove gli altri gongolano negli allori con super power PC e manco ci pensano a qualcosa del genere)

Mi sa che potranno cercare di limitarli in tutto per miliardi di volte, ma presto domineranno in tutto ed ogni campo.

Per questa IA e le future che ovviamente usciranno surclassando le precedenti, se rendono, sono free e servono, si vedra' se usarle, ovviamente si ricorda di non metterci dati personali, dati propri, proprie info, ecc..

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".