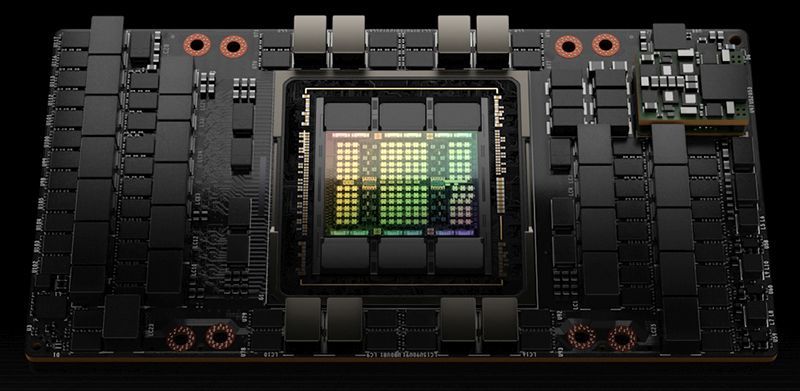

GPU NVIDIA H100 usate come collaterale per ottenere 2,3 miliardi di dollari di finanziamento

L'importanza degli acceleratori di intelligenza artificiale è in così forte crescita che CoreWeave ha usato le GPU NVIDIA H100 in suo possesso come collaterale per ottenere 2,3 miliardi di dollari da alcuni fondi.

di Manolo De Agostini pubblicata il 04 Agosto 2023, alle 16:11 nel canale MercatoHopperNVIDIA

CoreWeave, società del settore cloud che sfrutta un'enorme mole di GPU per fornire i propri servizi, si è assicurata una linea di debito di 2,3 miliardi di dollari. L'operazione è stata guidata da Blackstone e Magnetar, con la partecipazione di Coatue, DigitalBridge, BlackRock, PIMCO, Carlyle e Great Elm.

I soldi ottenuti, secondo il CEO Michael Intrator, saranno interamente impegnati per "l'acquisto e il pagamento dell'hardware per i contratti già stipulati con i clienti e per continuare ad assumere i migliori talenti del settore".

Se un round di finanziamento è cosa comune nel mondo imprenditoriale, è interessante il modo in cui CoreWeave è riuscita a convincere gli investitori, usando le GPU NVIDIA H100 come collaterale. Questa parola indica un bene, di tipo reale o finanziario, che è sostanzialmente messo a garanzia del creditore al momento della scadenza del debito. Una sorta di pegno, sul quale in caso di inadempienza il creditore si rifà a compenso di quanto offerto.

"Abbiamo negoziato con loro per trovare un programma per la quantità di garanzie da inserire, quale sarebbe stato il programma di ammortamento rispetto al programma di pagamento", ha affermato Michael Intrator secondo quanto riportato da Reuters. "Per noi andare a prendere in prestito denaro contro la base patrimoniale è un modo molto conveniente per accedere ai mercati del debito".

In CoreWeave, nata nel 2017, ha investito anche NVIDIA e per questo ha accesso privilegiato agli acceleratori di ultima generazione di NVIDIA, per i quali c'è molta domanda ma la disponibilità è limitata, nonostante la produzione a pieno ritmo da parte di TSMC.

CoreWeave ha importanti piani di espansione, solo la scorsa settimana ha annunciato la costruzione di un datacenter in Texas da 1,6 miliardi di dollari e punta a espandersi in 14 Stati americani entro fine anno. Quest'anno CoreWeave aveva già ottenuto 421 milioni di dollari di finanziamento da Magnetar sulla base di una valutazione di oltre 2 miliardi di dollari.

DJI Mavic 4 Pro: sblocca un nuovo livello per le riprese aeree

DJI Mavic 4 Pro: sblocca un nuovo livello per le riprese aeree Idrogeno verde in Europa: nuovi studi prevedono costi ben superiori alle aspettative

Idrogeno verde in Europa: nuovi studi prevedono costi ben superiori alle aspettative Mario Kart World lancia Switch 2: la magia Nintendo ora in 4K

Mario Kart World lancia Switch 2: la magia Nintendo ora in 4K Logitech G Astro A30 LIGHTSPEED in offerta su Amazon: cuffie wireless di altissimo livello per gaming e intrattenimento

Logitech G Astro A30 LIGHTSPEED in offerta su Amazon: cuffie wireless di altissimo livello per gaming e intrattenimento Splendido TV Samsung da 65'' in offerta a 899€: Neo QLED 4K con Quantum Matrix e Dolby Atmos

Splendido TV Samsung da 65'' in offerta a 899€: Neo QLED 4K con Quantum Matrix e Dolby Atmos Una super offerta su un PC Desktop pronto per il gaming: HP Victus 15L con Intel Core i7-14700F e GeForce RTX 4060 a 999€ su Amazon

Una super offerta su un PC Desktop pronto per il gaming: HP Victus 15L con Intel Core i7-14700F e GeForce RTX 4060 a 999€ su Amazon Amazon rivoluzionerà le consegne: in arrivo i primi test con robot umanoidi

Amazon rivoluzionerà le consegne: in arrivo i primi test con robot umanoidi Silent Hill f: allo State of Play la data d'uscita e un nuovo trailer dell'horror psicologico

Silent Hill f: allo State of Play la data d'uscita e un nuovo trailer dell'horror psicologico Iliadbox e Fibra Pura a 21,99€: Wi-Fi 7, velocità massima e tutto quello che devi sapere

Iliadbox e Fibra Pura a 21,99€: Wi-Fi 7, velocità massima e tutto quello che devi sapere iPhone 16 base scende a 769 euro su Amazon: chip A18 e display Super Retina ora a un prezzo super interessante

iPhone 16 base scende a 769 euro su Amazon: chip A18 e display Super Retina ora a un prezzo super interessante Aira Cleaner Future: sono i bambini a guidare la transizione green, ma l'Italia è pronta per le pompe di calore

Aira Cleaner Future: sono i bambini a guidare la transizione green, ma l'Italia è pronta per le pompe di calore Il Washington Post punta sull’intelligenza artificiale: Ember affiancherà i nuovi opinionisti

Il Washington Post punta sull’intelligenza artificiale: Ember affiancherà i nuovi opinionisti La saga di Thief ritorna con un nuovo gioco in Realtà Virtuale

La saga di Thief ritorna con un nuovo gioco in Realtà Virtuale Meta investe sul nucleare per alimentare intelligenza artificiale e metaverso

Meta investe sul nucleare per alimentare intelligenza artificiale e metaverso Amazfit Active 2 cala ancora di prezzo: smartwatch elegante e con tante funzioni, ora su Amazon a 109€ con cinturino in pelle

Amazfit Active 2 cala ancora di prezzo: smartwatch elegante e con tante funzioni, ora su Amazon a 109€ con cinturino in pelle Amazon: maxi investimento da 10 miliardi di dollari per nuovi data center in North Carolina dedicati all'IA

Amazon: maxi investimento da 10 miliardi di dollari per nuovi data center in North Carolina dedicati all'IA HP Laptop 15s con Ryzen 5, SSD da 512GB e 8GB RAM scende ancora di prezzo, ora a 323€ su Amazon

HP Laptop 15s con Ryzen 5, SSD da 512GB e 8GB RAM scende ancora di prezzo, ora a 323€ su Amazon

8 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoHo già detto mille volte che IBM è scafata in questo settore e ha dimostrato che,le GPU sono efficaci e non efficienti,basti a vedere nel settore mining,che furono costruiti appositi Asics che consumavano la metà e minavano il triplo,a parte ethereum.

I big si stanno costruendo hardware ad hoc per questo,qualche mese fa era uscito l'articolo che i tensor core di Google,vecchi di 3 anni,come rapporto consumi ed efficienza erano superiori all'hardware Nvidia odierno,vabbè l'hardware odierno Nvidia riesce a fare una mole di calcoli superiori,ai tensor core di Google ma a un costo energetico non trascurabile,difatti Google sta lavorando a dei tensor core rimodernati per la sua IA,stessa cosa Microsoft,Amazon etc.

Mi pare che,in generale,ci sia tanto marketing ma poca sostanza ultimamente,Nvidia fa prodotti eccellenti,una spanna sopra ad esempio la concorrente AMD,ma spesso quando se ne parla,sembra che Nvidia venda pietre filosofali e non dell'ottimo hardware.

Una volta che i big avranno messo a punto i loro sistemi,su questo settore,secondo me,Nvidia verrà ridimensionata.

Ribadisco, IBM ha dimostrato che le GPU sono efficaci,i calcoli in parallelo li fanno per la IA ma non li fanno in maniera efficiente, l'hardware deve essere progettato in modo diverso e non adattato,come si sta facendo,tanto per riciclare i propri brevetti e tecnologie delle GPU.

In sostanza IBM dimostrò come hardware vecchio e riadattato tipo parti della serie 6800 o Power,era molto più efficiente nell'inferenza,machine learnig e IA dei vari acceleratori ricavati dalle GPU ma,che si poteva fare ancora meglio riprogettando tutto da zero, perché per fare queste cose,servono solo registri da 8/16 e al massimo 32 bit,anzi,la massima efficienza si aveva con 4 (casi rari) 8 e 16 bit ma già il 32 era quasi inutile,figurarsi registri da 64.

Sono più propenso a credere a IBM che ad altre aziende sinceramente.

Nvidia dovrà fare delle scelte... o gpu per grafica o chip per IA

non potrà vendere in eterno la stessa minestra per due scopi diversi (inventandosi dlss o cose del genere)

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".