NVIDIA Parallel Nsight 1.5 e CUDA Toolkit 3.2

NVIDIA presenta le versione aggiornate di Parallel Nsight e Cuda toolkit, la serie di applicazioni con cui intende spingere la diffusione di CUDA

di Gabriele Burgazzi pubblicata il 14 Settembre 2010, alle 15:55 nel canale ProgrammiNVIDIACUDA

CUDA (acronimo di Computer Unified Device Architecture) è una tecnologia proprietaria di NVIDIA dedicata al calcolo parallelo. La potenza di calcolo messa a disposizione dalla GPU, infatti, può risultare utile non solo per la renderizzazione di scene tridimensionali ma anche per l'esecuzione di applicazioni particolarmente pesanti. Tutte le GPU sviluppate da NVIDIA dalla serie GT200 in poi sono in grado quindi di supportare CUDA: questa tecnologia consente di poter usare il linguaggio C per scrivere algoritmi eseguiti dalla GPU.

CUDA offre quindi accesso a tutti gli sviluppatori ad un set di istruzioni native per poter sfruttare la GPU nella computazione parallela: l'utilizzo di questa tecnologia rende di fatto le GPU architetture aperte come le normali CPU. Sussistono ovviamente differenze sostanziali tra CPU e GPU, nonostante CUDA: la struttura estremamente parallelizzata propria delle architetture grafiche è particolarmente adatta all'esecuzione di centinaia di processi simultaneamente.

L'impiego della scheda grafica per questi compiti è noto come GPGPU (General Purpouse GPU) In questo senso se una applicazione si rivela adatta al tipo di architettura, potrà trarre importanti benefici: un esempio lampante sono le operazioni di decodifica video.

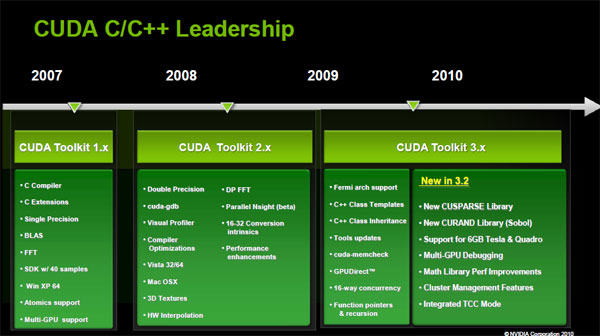

Oggi NVIDIA aggiorna alla versione 3.2 il proprio toolkit dedicato agli sviluppatori, andando ad aggiungere importanti funzioni. Queste le principali novità all'interno del nuovo toolkit, per il momento in versione RC, con particolare attenzione alle librerie:

- Implementazione di CUSPARSE per le routine a matrice sparsa

- Implementazione di CURAND

- Migliorie prestazionali per le librerie matematiche esistenti come FFT e BLAS

A questo annuncio corrisponde anche la presentazione di Parallel Nsight 1.5. Come abbiamo osservato in precedenza, la possibilità di poter sfruttare la GPU per calcoli che necessitano di molta potenza offre interessanti vantaggi: Tesla, la famiglia di soluzioni per sistemi HPC (High performance computing) ne è l'esempio lampante.

La forza bruta delle GPU può risolvere problemi altrimenti insormontabili con le solite architettura x86, ma non sempre.La necessità di avere del software che sia in grado di supportare correttamente la GPU è un elemento chiave per la diffusione di CUDA e del GPGPU e NVIDIA sembra esserne a conoscenza. Parallel Nsight 1.5 è la nuova versione del plugin per Visual Studio sviluppato per offrire supporto completo alla programmazione e al debugging per CUDA. Parallel Nsight era stato introdotto l'anno scorso, e da allora circa 8000 sviluppatori hanno cominciato ad impiegare tale plugin. Parallel NSight 1.5 sarà disponibile per gli sviluppatori a partire dal giorno 22.

ASUS ROG Kithara: quando HIFIMAN incontra il gaming con driver planari da 100mm

ASUS ROG Kithara: quando HIFIMAN incontra il gaming con driver planari da 100mm Roborock Qrevo Curv 2 Flow: ora lava con un rullo

Roborock Qrevo Curv 2 Flow: ora lava con un rullo Alpine A290 alla prova: un'auto bella che ti fa innamorare, con qualche limite

Alpine A290 alla prova: un'auto bella che ti fa innamorare, con qualche limite Area Science Park scommette sul deep tech: un milione di euro per cinque startup

Area Science Park scommette sul deep tech: un milione di euro per cinque startup Samsung presenta le nuove Galaxy Buds4 e Buds4 Pro. Prezzi e dettagli

Samsung presenta le nuove Galaxy Buds4 e Buds4 Pro. Prezzi e dettagli Ecco la nuova serie Galaxy S26: Samsung punta tutto su AI e il rivoluzionario Privacy Display

Ecco la nuova serie Galaxy S26: Samsung punta tutto su AI e il rivoluzionario Privacy Display Ken il Guerriero e Ghost in the Shell: le nuove serie saranno distribuite da Prime Video

Ken il Guerriero e Ghost in the Shell: le nuove serie saranno distribuite da Prime Video Fallout 4 sbarca su Nintendo Switch 2: c'è tutto, ma proprio tutto

Fallout 4 sbarca su Nintendo Switch 2: c'è tutto, ma proprio tutto BMW tratta con Bruxelles per liberare Mini Aceman e Cooper dai dazi sulle auto elettriche cinesi

BMW tratta con Bruxelles per liberare Mini Aceman e Cooper dai dazi sulle auto elettriche cinesi NVIDIA, l'amara verità: zero H200 vendute in Cina dopo il via libera di Trump

NVIDIA, l'amara verità: zero H200 vendute in Cina dopo il via libera di Trump Uomo morto intrappolato nella Xiaomi SU7: ubriaco a 200 km/h di velocità, ma le maniglie sono da ripensare

Uomo morto intrappolato nella Xiaomi SU7: ubriaco a 200 km/h di velocità, ma le maniglie sono da ripensare HP: prezzi di DRAM e NAND raddoppiati, la memoria pesa ora il 35% sul costo di un PC

HP: prezzi di DRAM e NAND raddoppiati, la memoria pesa ora il 35% sul costo di un PC Vodafone è la rete mobile più veloce d'Italia: battuti tutti i rivali, il 5G raggiunge 201 Mbps in download

Vodafone è la rete mobile più veloce d'Italia: battuti tutti i rivali, il 5G raggiunge 201 Mbps in download Iliad arriva a Sanremo con un hub tecnologico. Ecco la strategia di ecosistema al Festival

Iliad arriva a Sanremo con un hub tecnologico. Ecco la strategia di ecosistema al Festival  Monitor gaming QD-OLED a prezzi mai visti: AOC 240 Hz a 399€ e MSI MAG 273QP a 489€ su Amazon

Monitor gaming QD-OLED a prezzi mai visti: AOC 240 Hz a 399€ e MSI MAG 273QP a 489€ su Amazon Paramount aumenta l'offerta per acquisire Warner Bros. Discovery, Netflix pronta ad abbandonare

Paramount aumenta l'offerta per acquisire Warner Bros. Discovery, Netflix pronta ad abbandonare Grazie ad ALMA di ESO catturata una nuova, spettacolare immagine che svela i segreti del cuore della Via Lattea

Grazie ad ALMA di ESO catturata una nuova, spettacolare immagine che svela i segreti del cuore della Via Lattea

23 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoCome non quotare..

sono 2 i produttori di schede non 50.

professionalmente il GPGPU e CUDA sono molto piu diffusi, a differenza dell'ambito home dove nella maggiorparte dei casi lo sforzo di trasportare il codice su GPU non vale il risultato....

Professionalmente, non si pone nemmeno il problema, visto che l'80-90% del mercato è in mano a nVidia e difatti è praticamente quasi tutto CUDA.

dipende a quale settore ti riferisci.

se stai pensando al settore consumer PC, resta vero il fatto che non è cosa buona e giusta dover scrivere software per Nvidia e per Ati in linguaggi differenti. OpenCL da una mano, ma ancora non è maturo.

se parliamo del settore professionale e militare, non è assolutamente come dici. Sul mercato ci sono migliaia di CPU con set istruzioni non x86 e non frega niente a nessuno di questo. Un autoradio, non ha una CPU x86, cosi come non ce l'ha un iPod o un Tomtom e si può andare avanti all'infinito.

Nel settore professionali e militare, hai un problema e ti serve una soluzione e deve essere quella: quasi mai è richiesta la compatibilità x86.

CUDA nel mondo militare e scientifico è mooolto usato, se ne parla poco per ovvie ragioni, ma nvidia attualmente investe 4 volte tanto in termini di soldi e di risorse umane allocate su CUDA e i suoi driver, piuttosto che nello sviluppo di GPU.

Uso CUDA per lavoro (settore appunto militare) e quello che permette di fare ha dell'incredibile, i clienti restano a bocca aperta xkè gli viene data la possibilità di rimpizzare vecchi sistemi basati su FPGA e DSP dal costo di migliaia di euro per pezzo, con un sistema enormemente più performante e drasticamente più economico.

se stai pensando al settore consumer PC, resta vero il fatto che non è cosa buona e giusta dover scrivere software per Nvidia e per Ati in linguaggi differenti. OpenCL da una mano, ma ancora non è maturo.

se parliamo del settore professionale e militare, non è assolutamente come dici. Sul mercato ci sono migliaia di CPU con set istruzioni non x86 e non frega niente a nessuno di questo. Un autoradio, non ha una CPU x86, cosi come non ce l'ha un iPod o un Tomtom e si può andare avanti all'infinito.

Nel settore professionali e militare, hai un problema e ti serve una soluzione e deve essere quella: quasi mai è richiesta la compatibilità x86.

CUDA nel mondo militare e scientifico è mooolto usato, se ne parla poco per ovvie ragioni, ma nvidia attualmente investe 4 volte tanto in termini di soldi e di risorse umane allocate su CUDA e i suoi driver, piuttosto che nello sviluppo di GPU.

Uso CUDA per lavoro (settore appunto militare) e quello che permette di fare ha dell'incredibile, i clienti restano a bocca aperta xkè gli viene data la possibilità di rimpizzare vecchi sistemi basati su FPGA e DSP dal costo di migliaia di euro per pezzo, con un sistema enormemente più performante e drasticamente più economico.

ho capito che il discorso si basa sul rapporto esigenza ---> soluzione passando per i benefici economici (=> miglior rapporto costo/risultato) e questo porta a sviluppare su CUDA. OK..

..però quello che io mi chiedo, nella mia niubbiaggine in merito è: una cosa come l'architettura X86 non ha praticamente possibilità di sparire nel breve-medio termine, quindi da quel punto di vista è sicura. Stesso discorso per altri standard/architetture radicate nel mercato e adottabili da più aziende (con volontà e risorse economiche adeguate) e quindi portate avanti.

Una cosa come CUDA invece è strettamente legata ad un'unica azienda che non è poi così solida o perlomeno nn lo è come un'architettura tipo x86.

nVidia potrebbe floppare l'architettura delle sue VGA ed accumulare ritardi indebolendosi notevolmente (è già capitato..) ed esponendosi ad eventuali acquisti da parte di terzi ecc.

Se domani nVidia fallisce o se la compra la Pinco Pallino Inc., le soluzioni CUDA (sw+hw) che fine fanno? La fatica dello sviluppo che fine fa?

Ripeto è solo una domanda da ignorante, se hai voglia illuminami

Ciao

anche i grandi sbagliano.

Sul discorso longevità del prodotto, non è esattamente come dici e mi spiego. mentre sul mercato una GPU come la 8800gts non la trovi a comprare, se hai un prodotto business professionale, nvidia ti garantisce la reperibilità per 10 anni.

Un altro problema non di poco conto rientra in ciò che una GPU può fare: se con una CPU x86 che probabilmente ti da più sicurezza, te ne servono 20-30 per fare una certa operazione, quando invece di GPU ti basta una GTX 480, e il tuo sistema va montato su un aereo da guerra vero, capisci che non me ne frega nulla del discorso x86, sia perchè non posso montare 20-30 server in una aereo supersonico, sia perchè il sistema che ho realizzato è specifico e non general purpose per milioni di utenti. ne progetto 1 ne vendo 200, a milioni di dollari a singolo pezzo.

Quello che tu dici, è successo con CELL di Ibm.

Quando usi la PS3, se ti ricordi, ci fu molto interessa in NASA e nel settore militare per questa CPU multicore.

IBM però non si è mossa bene, ha fatto mille difficoltà, prima fra tutte quella che le CPU CELL le potevi trovare solo su server Blade con un kernel linux appositamente compilato. L'azienda Mercury era l'unica al mondo che stava cercando di sviluppare un mini-pc atto al volo supersonico con CPU-CELL, ma hanno incontrato talmente tante difficoltà (nonostante il giro di soldi immenso che avrebbero mosso) che hanno abbandonato il progetto.

Di architettura CELL ne è esistita solo una, IBM non ha fornito supporto necessario, ha avuto problemi societari e il progetto CELL è morto.

E' probabile che dietro la mossa di Sony di togliare il supporto ad altri OS sulla PS3 ci sia anche la morte di CELL e la fine degli accordi con IBM.

Chi aveva provato a fare sperimentazioni di software militari e professionali con la PS3 e i server Blade in attesa che le CPU CELL si trovassero in versioni custom integrabili su i propri sistemi, ha perso tempo e soldi e ha dovuto buttare tutto.

Con Nvidia e con CUDA lo scenario non è certo quello di IBM, è dalla serie 8000 (e non dalla gt200 come dice l'articolo

http://www.defensemarket.com/?p=193

così come GPU nvidia si trovano nelle macchine che guidiamo, come fiat lancia volvo ecc

http://www.nvidia.com/object/tegra_automotive.html

le GPU nvidia vengono anche usate e vendute in sistemi per l'acquisizione immagini. Ad una conferenza Nvidia ho visto questo spettacolare software di realtime image filtering usato in ambito militare prodotto da IKENA. Guardate cosa riesce a fare una GPU anche se montata su un elicottero :-)

http://www.motiondsp.com/products/isr/

Lungi da me l'affermare che una GPU soppiante le CPU, così come ne Nvidia ne Intel affermano questo.

Commento molto professionale, io lavoro nel campo automobilistico come autoriparatore e quelle cose lì non le sapevo.

Ecco perchè Nvidia spinge tanto su CUDA e ha progettato Fermi per questo.

Il campo gamer-user passa in secondo piano rispetto a quegli usi da te elencati.

Ecco perchè Nvidia spinge tanto su CUDA e ha progettato Fermi per questo.

Il campo gamer-user passa in secondo piano rispetto a quegli usi da te elencati.

la maggiorparte delle persone conosce nVidia solo per le gaming e crede che sia quello il suo campo principale.... invece il campo user game è da un pezzo che per nVidia è in secondo piano

utili stimati 2010

180 milioni di dollari Professional

29 milioni discrete desktop

12 milioni discrete notebook

37 milioni integrated desktop

45 milioni integrated notebook

123 milioni tot dal comparto pc consumer

nVidia ha un utile di 180 milioni di dollari solo con il professionale, tutta la divisione ATI ha un utile stimato 2010 di 110 milioni di dollari...

nVidia è stata molto saggia a investire molto su CUDA visto che gia deteneva una quota altissima del mercato professionale PC ( senza contare il resto dei settori extra PC )

preferisco di gran lunga uno standard chiuso ma supportato come dio comanda come CUDA piuttosto che uno standard aperto lasciato solo.

Fino ad ora non se ne è sentito il bisogno di uno standard "aperto", visto che ATI nel professionale ha delle schede inferiori;

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".