Artificial Intelligence Unit (AIU) è il chip specializzato di IBM per il deep learning

IBM ha annunciato Artificial Intelligence Unit (AIU), un chip specializzato per i calcoli legati al deep learning. Al suo interno 32 core e un totale di 23 miliardi di transistor.

di Manolo De Agostini pubblicata il 20 Ottobre 2022, alle 14:41 nel canale ProcessoriIBMIntelligenza Artificiale

Si chiama Artificial Intelligence Unit, in breve AIU, il chip specializzato per la gestione dei calcoli legati all'intelligenza artificiale messo a punto dall'IBM Research AI Hardware Center. Secondo IBM, "stiamo esaurendo la potenza di calcolo" perché, a fronte di una crescita esponenziale dei modelli di intelligenza artificiale, l'hardware necessario ad addestrarli ed eseguirli non è progredito con altrettanta rapidità.

Ed è qui che la AIU entra in gioco. Le tradizionali CPU, pensate per essere flessibili e in grado di far girare software "general purpose", ossia senza un fine preciso, sono inadeguate a gestire l'enorme mole di operazioni parallele che i modelli di deep learning richiedono. "Un'auto con motore a benzina potrebbe funzionare con il diesel, ma se l'obiettivo è massimizzare la velocità e l'efficienza, è necessario il carburante giusto. Lo stesso principio si applica all'IA".

Eseguire modelli di deep learning su CPU e GPU, per IBM, non è la soluzione migliore. "Abbiamo trascorso gli ultimi 5 anni a capire come progettare un chip su misura per le statistiche dell'IA moderna", un percorso che ha portato IBM a identificare due strade da seguire.

La prima è quella di puntare su una minore precisione di calcolo. A differenza delle CPU, i chip di IA non devono essere ultra-precisi perché "non calcoliamo le traiettorie per far atterrare un veicolo spaziale sulla Luna o stimiamo il numero di peli su un gatto. Facciamo previsioni e prediamo decisioni che non richiedono una simile precisione".

Si può quindi passare da un'aritmetica in virgola mobile a 32 bit a formati che contengono un quarto delle informazioni. In questo modo si riduce drasticamente la quantità di calcoli necessari per addestrare ed eseguire un modello di intelligenza artificiale, senza sacrificare la precisione. Parallelamente, puntare su formati più snelli consente di ridurre la quantità di dati che è necessario spostare "da e verso la memoria".

"La nostra AIU usa una gamma di formati di bit più piccoli, comprese rappresentazioni in virgola mobile e interi, per rendere l'esecuzione di un modello di intelligenza artificiale molto meno dispendiosa in termini di memoria. Sfruttiamo le principali scoperte IBM degli ultimi cinque anni per trovare il miglior compromesso tra velocità e precisione".

La seconda soluzione è quella di creare un chip esplicitamente per l'IA, predisposto per semplificare i flussi di lavoro. "Poiché la maggior parte dei calcoli di intelligenza artificiale coinvolge la moltiplicazione di matrici e vettori, la nostra architettura presenta un layout più semplice rispetto a una CPU generica. IBM AIU è stata inoltre progettata per inviare i dati direttamente da un motore di calcolo all'altro, creando enormi risparmi energetici".

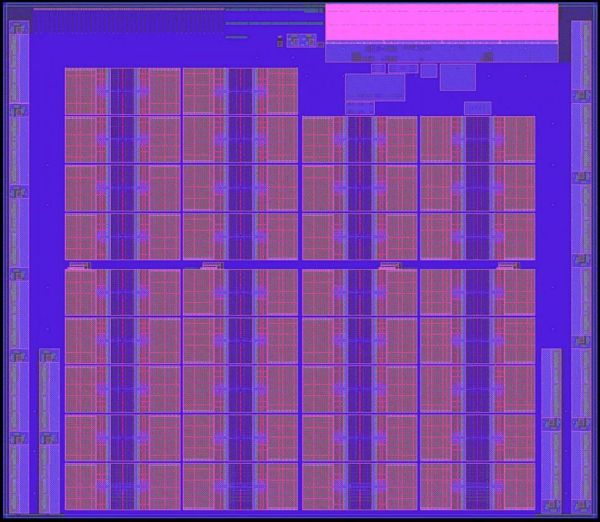

Insomma, IBM AIU non è altro che un ASIC (application-specific integrated circuit) progettato per il deep learning e programmabile per gestire diversi tipi di operazioni, che si tratti di elaborare la lingua parlata, parole o immagini su uno schermo. Nel chip ci sono 32 core e un totale di 23 miliardi di transistor, inoltre è collegabile facilmente a un computer o un server tramite slot PCI Express.

IBM AIU non è altro che la versione "in grande" dell'acceleratore di IA integrato in Telum, altra soluzione della società statunitense. Il nuovo chip, a differenza di Telum (7 nm), è prodotto con processo a 5 nanometri.

|

|

Due mesi di Battlefield 6: dalla campagna al battle royale, è l'FPS che stavamo aspettando

Due mesi di Battlefield 6: dalla campagna al battle royale, è l'FPS che stavamo aspettando Antigravity A1: drone futuristico per riprese a 360° in 8K con qualche lacuna da colmare

Antigravity A1: drone futuristico per riprese a 360° in 8K con qualche lacuna da colmare Sony Alpha 7 V, anteprima e novità della nuova 30fps, che tende la mano anche ai creator

Sony Alpha 7 V, anteprima e novità della nuova 30fps, che tende la mano anche ai creator TSMC dà i numeri: dal processo N7 a quello A14 efficienza migliorata di 4,2 volte

TSMC dà i numeri: dal processo N7 a quello A14 efficienza migliorata di 4,2 volte La ricarica wireless dei Samsung Galaxy S26 sarà più veloce: la conferma da un nuovo accessorio

La ricarica wireless dei Samsung Galaxy S26 sarà più veloce: la conferma da un nuovo accessorio Stop ai social per gli Under 16: l'Australia è pronta e Meta ha iniziato a bloccare gli account

Stop ai social per gli Under 16: l'Australia è pronta e Meta ha iniziato a bloccare gli account Google svela i videogiochi più cercati online (e GTA 6 è solo al settimo posto)

Google svela i videogiochi più cercati online (e GTA 6 è solo al settimo posto) TikTok lancia il nuovo feed con contenuti geolocalizzati

TikTok lancia il nuovo feed con contenuti geolocalizzati Amazon aggiorna gli sconti e si prepara al Natale: inizia la grande corsa ai regali con super promozioni tutti i giorni

Amazon aggiorna gli sconti e si prepara al Natale: inizia la grande corsa ai regali con super promozioni tutti i giorni GeForce NOW: 50% di sconto e 30 nuovi giochi a dicembre 2025

GeForce NOW: 50% di sconto e 30 nuovi giochi a dicembre 2025 Insta360 Ace Pro 2 in offerta: disponibili a prezzi super Pack Standard e Pack Creatori

Insta360 Ace Pro 2 in offerta: disponibili a prezzi super Pack Standard e Pack Creatori Roborock Saros 10R a 909€ invece di 1.399€: il super robot 'anti-grovigli' con stazione 4.0 ora costa molto meno

Roborock Saros 10R a 909€ invece di 1.399€: il super robot 'anti-grovigli' con stazione 4.0 ora costa molto meno Solo oggi due monitor Acer a prezzi assurdi, partono da 119€: ecco quale scegliere per non sbagliare

Solo oggi due monitor Acer a prezzi assurdi, partono da 119€: ecco quale scegliere per non sbagliare FRITZ!Box in forte sconto su Amazon: modem, router e ripetitori Mesh ai minimi dell’anno

FRITZ!Box in forte sconto su Amazon: modem, router e ripetitori Mesh ai minimi dell’anno Apple + Samsung = monopolio totale nel Q3 2025. Che fine ha fatto la concorrenza?

Apple + Samsung = monopolio totale nel Q3 2025. Che fine ha fatto la concorrenza? 6 TV 4K in super sconto su Amazon, anche QLED, dai 43 pollici in su e c'è un 65 pollici a 399€

6 TV 4K in super sconto su Amazon, anche QLED, dai 43 pollici in su e c'è un 65 pollici a 399€ Lava, aspira a 9000Pa e ha la stazione di svuotamento polvere: ECOVACS DEEBOT MINI è super venduto, a 199€ non ha rivali

Lava, aspira a 9000Pa e ha la stazione di svuotamento polvere: ECOVACS DEEBOT MINI è super venduto, a 199€ non ha rivali

5 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoSolo Nvidia fa prodotti per Ai e compagnia bella.

Ero sarcastico....spero si capisse

Quindi quella sopra o non è la foto giusta o Due core sono disabilitati....

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".