La Legge di Moore è morta, ma l'innovazione continuerà ad esserci

Un corposo approfondimento di Nature.com racconta il declino dell'affidabilità della Legge di Moore, la cui "morte" è già stata preannunciata da tempo

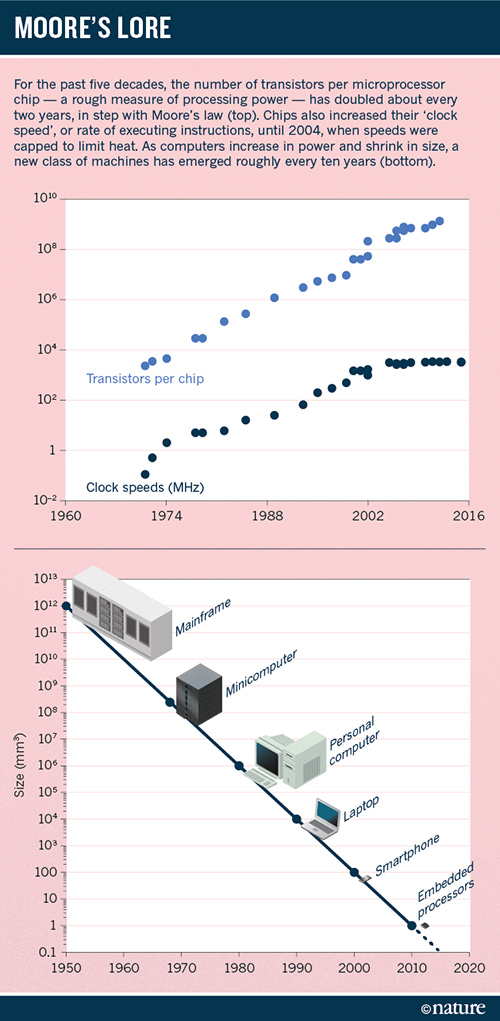

di Nino Grasso pubblicata il 16 Febbraio 2016, alle 13:01 nel canale ProcessoriIl settore del "silicio", quella alla base della produzione dei semiconduttori presenti nei nostri computer, non è più in grado di tener il passo stabilito dalla celebre "Legge di Moore", con la teoria che è ben presto destinata ad essere sepolta. Lo afferma un corposo approfondimento del sito Nature.com, che sostiene che presto le società del settore smetteranno di perseguire i dettami della vecchia teoria, che solamente l'anno scorso festeggiava il suo cinquantesimo anno dalla nascita.

La Legge di Moore è stata teorizzata per la prima volta dal leggendario co-fondatore di Intel, Gordon E. Moore, nel lontano 1965. È stata enunciata in vari modi nel corso degli anni, ma nella forma più semplice il concetto espresso dal suo autore è che "la complessità di un microcircuito, misurata ad esempio tramite il numero di transistori per chip", sarebbe raddoppiata di anno in anno. Un assunto che le società del settore, ad esempio la stessa Intel, sono riuscite a mantenere fino ad oggi considerando la revisione del 1970, con la teoria che cambiava prevedendo il raddoppio ogni diciotto mesi.

Il lungo approfondimento di Nature tuttavia racconta una realtà diversa per i prossimi anni, una realtà che il settore dei semiconduttori si aspetta da tempo. I chip moderni sono già parecchio complessi nella loro realizzazione e utilizzano processi produttivi già estremamente miniaturizzati, a tal punto che sta diventando sempre più complesso e difficile riuscire ad aumentare la loro densità. In considerazione di ciò sembra ad oggi molto difficile riuscire a raddoppiarne la capacità ogni 18 mesi.

I chip più avanzati attualmente in commercio utilizzano processi produttivi a 14nm, laddove un nanometro equivale ad un miliardesimo di metro. A questa grandezza le parti individuali che compongono il chip sono più piccole di una particella virale tipica, e simili alle dimensioni delle membrane esterne di un germe. Stampare chip a 14nm è diventato così complesso e costoso che ad oggi solo quattro società riescono a mantenere il passo: Intel, Samsung, TSMC e GlobalFoundries.

In paragone, solo 10 anni fa ce n'erano ben 18 sul mercato. Il prossimo passo che seguirà il mercato sarà quello dei 10nm, che dovrebbe arrivare nei chip destinati al mercato consumer nel 2016. In seguito arriveranno i 7nm, previsti nel 2018 o nel 2019, mentre TSMC ha iniziato a lavorare a un processo produttivo a 7nm con l'obiettivo di avere i primi prototipi pronti per l'anno prossimo. Sarà proprio con i 5nm che ci saranno le prime problematiche di natura fisica, difficili da aggirare con le competenze attuali.

Fonte: Nature.com

Con un processo produttivo così miniaturizzato i singoli elementi del chip avrebbero dimensioni di circa il doppio rispetto a un filamento di DNA. Le caratteristiche di design del chip non sarebbero in questo modo più grandi di 10 atomi, con gli elettroni che potrebbero cominciare a comportarsi in maniera poco prevedibile. Le difficoltà di produzione dei chip previste per gli anni a venire non si tradurranno naturalmente in un arresto dell'evoluzione tecnologica.

I produttori di semiconduttori si baseranno su una nuova strategia chiamata "More than Moore", stando al Nature. Ovvero, non cercheranno di basare l'evoluzione tecnologica solo ed esclusivamente sulla potenza bruta, con il progresso che sarà dettato dalle innovazioni richieste dal mercato. L'esempio svolto da Daniel Reed citato da Nature è quello del mercato degli aeroplani: "Un Boeing 787 non è molto più veloce rispetto ad un 707 del 1950", ha affermato lo scienziato.

Ma sono molte le innovazioni introdotte sul nuovo modello: ad esempio una migliorata efficienza nel consumo di carburante, una struttura più leggera e sistemi di navigazione elettronici più avanzati. Il percorso che verrà seguito dal mercato dei micro-chip sarà diverso nei prossimi anni e incontrerà differenti traguardi sulla base delle esigenze di mercato: "L'innovazione continuerà nella maniera più assoluta", ha commentato Reed. "Ma sarà molto più articolata e complessa rispetto ad oggi".

La Formula E può correre su un tracciato vero? Reportage da Misano con Jaguar TCS Racing

La Formula E può correre su un tracciato vero? Reportage da Misano con Jaguar TCS Racing Lenovo LEGION e LOQ: due notebook diversi, stessa anima gaming

Lenovo LEGION e LOQ: due notebook diversi, stessa anima gaming_L.jpg) Nothing Ear e Ear (a): gli auricolari per tutti i gusti! La ''doppia'' recensione

Nothing Ear e Ear (a): gli auricolari per tutti i gusti! La ''doppia'' recensione HiSolution amplia i propri servizi e punta sempre più sulla cybersicurezza

HiSolution amplia i propri servizi e punta sempre più sulla cybersicurezza F1 24 introdurrà migliorie al modello di guida, una carriera rinnovata e molto altro ancora

F1 24 introdurrà migliorie al modello di guida, una carriera rinnovata e molto altro ancora Arriva Omnissa, che prenderà in carico i prodotti per "utenti finali" di VMware

Arriva Omnissa, che prenderà in carico i prodotti per "utenti finali" di VMware Turista americano torna dall'Europa e si trova una bolletta telefonica da 135 mila euro per il roaming

Turista americano torna dall'Europa e si trova una bolletta telefonica da 135 mila euro per il roaming Larian al lavoro su due nuovi giochi, creati con la stessa 'passione' di Baldur's Gate 3

Larian al lavoro su due nuovi giochi, creati con la stessa 'passione' di Baldur's Gate 3 Microsoft Office LTSC 2024 disponibile in anteprima pubblica su Windows e Mac

Microsoft Office LTSC 2024 disponibile in anteprima pubblica su Windows e Mac Fallout 4 è il gioco più venduto in Europa! Le vendite schizzano del 7500% grazie alla serie TV

Fallout 4 è il gioco più venduto in Europa! Le vendite schizzano del 7500% grazie alla serie TV Razer Kishi Ultra: ecco il controller per ogni tipo di smartphone (o iPad mini)

Razer Kishi Ultra: ecco il controller per ogni tipo di smartphone (o iPad mini) Il Dimensity 6300 di MediaTek porta il 5G mainstream e tanto altro nella fascia media

Il Dimensity 6300 di MediaTek porta il 5G mainstream e tanto altro nella fascia media Google combina i team Android, Chrome e hardware: focus sull'IA

Google combina i team Android, Chrome e hardware: focus sull'IA Axiante vuole indagare come le imprese italiane affrontano la pianificazione aziendale

Axiante vuole indagare come le imprese italiane affrontano la pianificazione aziendale Italia quinto mercato europeo per i videogiochi: aumenta la spesa, ma diminuisce il tempo di gioco

Italia quinto mercato europeo per i videogiochi: aumenta la spesa, ma diminuisce il tempo di gioco Apple celebra la Giornata della Terra con sfide, innovazioni e impegno per l'ambiente

Apple celebra la Giornata della Terra con sfide, innovazioni e impegno per l'ambiente  La funzionalità 'AI Explorer' di Windows 11 sarà inizialmente esclusiva dei PC con CPU ARM?

La funzionalità 'AI Explorer' di Windows 11 sarà inizialmente esclusiva dei PC con CPU ARM?

_XXL.jpg)

31 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoVedere te che tra 10 anni sarà Intel stessa ad ammettere che x86 era una architettura nata male ed evoluta peggio solo per mantenere la retrocompatibilità e senza davvero aver apportato vere innovazioni.

Ovviamente lo dirà quando avrà in mano una nuova architettura che darà la birra a questa, ormai giunta al capolinea ben prima della morte della legge di Moore

R.I.P. Legge di Moore.. sinceramente mi eri davvero simpatica.

Non conoscevo questa legge, ma non è il giusto esempio, gli attuali smartphone, secondo me , sono solo un fenomeno commerciale, quale reale utilizzo hanno? Sarebbero telefoni portatili la cui batteria non dura niente a causa di schermi enormi.

Vedere te che tra 10 anni sarà Intel stessa ad ammettere che x86 era una architettura nata male ed evoluta peggio solo per mantenere la retrocompatibilità e senza davvero aver apportato vere innovazioni.

Ovviamente lo dirà quando avrà in mano una nuova architettura che darà la birra a questa, ormai giunta al capolinea ben prima della morte della legge di Moore

sinceramente dire che X86 sia un'architettura nata male ed evoluta peggio, è un po' offensivo verso il mondo dei microprocessori che ci ha assistito negli ultimi decenni.

Assistito o imposta per ragioni più commerciali che tecniche e di merito?

Sinceramente ne so troppo poco in merito per poter dire se X86 è questo e quello.. di certo però posso dire che come evoluzione di strada ne ha fatta parecchia eh.. non è che sia poi sta rovina direi.

Che poi si possa creare una architettura migliore ok posso anche ammetterlo.. ma scusa la cosa più furba in assoluto per Intel sarebbe sfruttare la sua posizione di capofila per diffonderla affiancandola alle soluzioni x86.

In tal modo garantirebbe la diffusione e al momento buono potebbe liberarsi del vecchio standard.

Se tutto questo non accade è perchè si vede che x86 è ancora valida.. no?

In arrivo pc immuni dai virus?

Baio

questa sarebbe una vera innovazione.

Al di là di imposizione o meno, è più che oggettivo affermare che tale architettura si sia difesa più che bene da quegli avversari che hanno provato a scalzarla (powerpc, arm, ecc., sempre a parità di prestazioni/efficienza energetica).

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".